Cela fait des années que l'on voit publiés sur le Web des chiffres sur les supposées parts de marché (PDM) des moteurs de recherche en France, en Europe ou dans le Monde. Certains sites publient des chiffres, parfois calculés de façon totalement différente et ces statistiques sont reprises, voire comparées à l'envi, par d'autres sources parfois sans aucune réflexion critique à la clé. Ces chiffres peuvent également être repris car cela arrange bien ceux qui communiquent dessus... Il nous semblait donc intéressant de bien comprendre ce que sont ces parts de marché des moteurs de recherche et d'analyser la façon dont elles pourraient (devraient ?) être calculées. C'est l'objet de cet article...

Comment définir les parts de marché des moteurs de recherche ?

Cette question est bien sûr la base de départ de la réflexion. Que mesure-t-on ? Comment comparer de la façon la plus objective possible plusieurs moteurs, par exemple dans un pays donné (sachant que la méthodologie sera la même à l'échelle d'un contient ou du Monde entier) ? Rappelons qu'il s'agit ici de comparer les PDM des moteurs de recherche, et de rien d'autre !

Il existe plusieurs façons de calculer ces PDM :

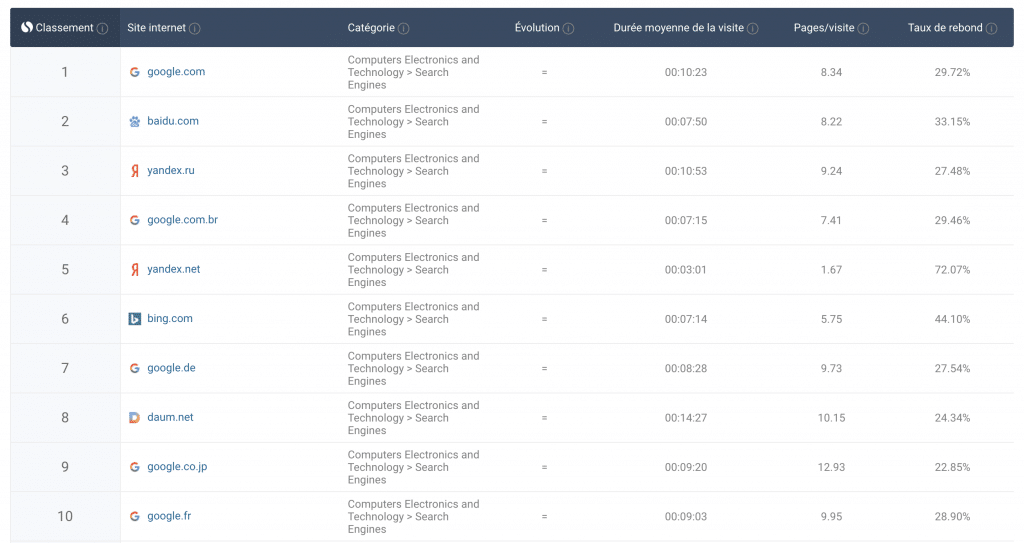

• La première consiste à comparer le trafic de chaque site, en termes de nombre de visiteurs uniques par exemple. Cela peut être intéressant si on se limite au strict trafic "moteur" et pas à ses à-côtés (autres sites ou autres contenus sur le même nom de domaine). A notre connaissance, des outils comme SimilarWeb fonctionnent ainsi, en prenant en compte non pas bien sûr le trafic réel de chaque site (qui reste en lui-même confidentiel), mais le trafic total mesuré (et anonymisé) sur un nom de domaine (en récupérant des données brutes depuis des FAI).

Source de l'image : SimilarWeb

Ce mode de calcul peut être fiable éventuellement pour certains sites (presse média, e-commerce), même si cela reste à prouver, mais ce n'est à notre avis pas le cas des moteurs de recherche. En effet, Google par exemple propose des tas de sites, d'informations et d'outils, qui doivent certainement générer un trafic loin d'être négligeable sur les noms de domaines Google.com et Google.fr, et ce trafic ne concerne pas uniquement le moteur.

Faisons à ce sujet une micro-étude rapide. Bien sûr, Google n'indexe pas ses propres SERP. Donc les pages indexées sur son nom de domaine doivent correspondre à du contenu éditorial ou des outils en-dehors des résultats de recherche proprement dit. Si on tape la requête "site:google.com" sur le moteur, on trouve plus de 2 milliards de pages indexées ! Pour "site:google.fr", on trouve 1,4 millions de pages qui génèrent donc de façon certaine un trafic énorme en dehors du moteur lui-même. Pourtant c'est le trafic global qui semble comptabilisé par SimilarWeb, donc "moteur" et "hors moteur".

Comparer le trafic global sur des noms de domaine uniquement fausse donc l'analyse, car on ne se réfère pas strictement au trafic "moteur". Ces outils sont peut-être intéressants pour mesurer la visibilité d'une marque (stratégie de branding), mais ils ne sont pas assez fiables et précis pour des analyses comparatives des différents moteurs de recherche.

D'autre études (Médiamétrie ?) fonctionnent selon un mode différent et considèrent que si un internaute va une fois ou mille fois sur Google ou Bing dans la même journée, la statistique sera identique in fine. Difficile de parler de fiabilité dans ce cas. Les résultats seront juste inexploitables, dans le cadre d'un calcul de PDM en tout cas… C'est ici encore pire que le cas précédent. Exit donc.

• Bien sûr, l'idéal serait d'avoir un outil permettant de mesurer le nombre de requêtes traitées par chaque moteur, chaque jour, chaque semaine ou chaque mois par exemple. Dans ce cas, le décompte ne serait pas loin d'être idéal, puisque ce chiffre serait le juge de paix dans le domaine. Mais les moteurs ne communiquent pas ces chiffres (qu'il faudrait par ailleurs vérifier !) et il y a peu de chance qu'ils le fassent un jour. Ce type d'outil ne peut donc être qu'un vœu pieux. Dommage…

• La troisième façon de calculer des PDM de moteurs est d'évaluer le trafic généré par ces outils sur un certain nombre de sites web, de la façon la plus exhaustive et représentative possible. Les mieux placés ici pour proposer ce type d'évaluation sont bien sûr les sociétés proposant des systèmes de mesure d'audience, comme Google Analytics, Yandex Metrica ou en France At Internet ou Matomo.

Dans le passé, de nombreux baromètres existaient sur cette base, notamment en France avec Xiti / At Internet qui proposait des études mensuelles, hélas abandonnées depuis (il faut dire que, mois après mois, elles donnaient des résultats quasiment identiques et que la lassitude de publier tout le temps les mêmes résultats a peut-être joué à ce niveau).

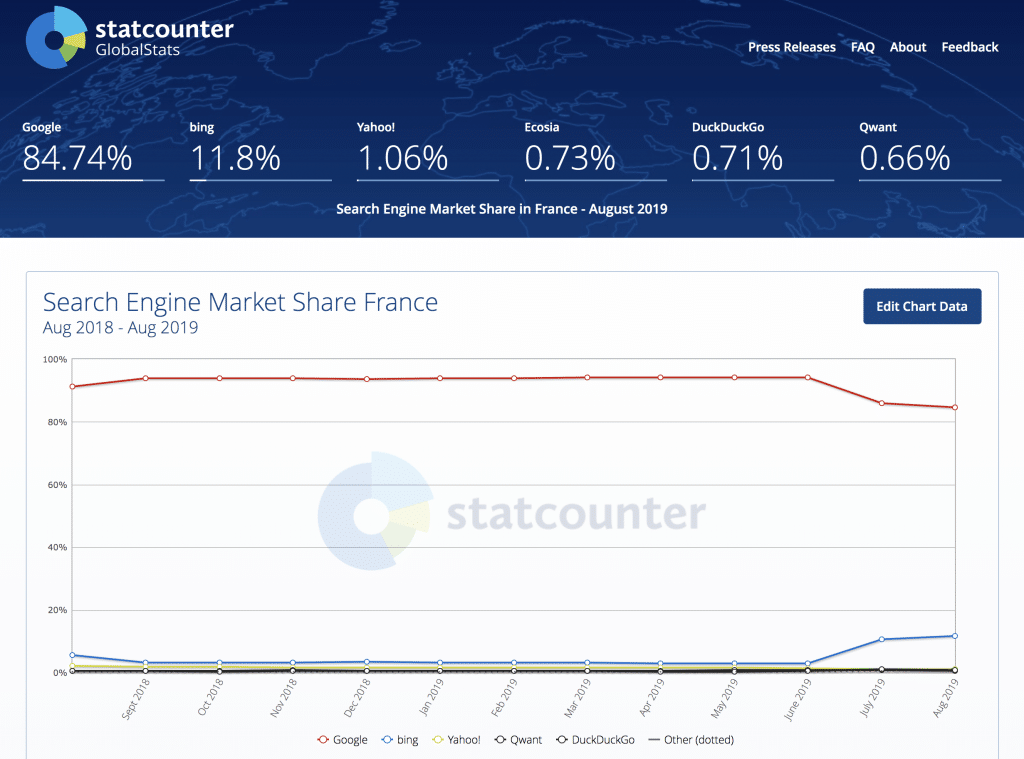

Actuellement, le marché est occupé par StatCounter qui, jusqu'au début de cet été, était l'outil dont les résultats se rapprochaient le plus de ce que l'on pouvait constater sur les différents sites web pour lesquels on a accès aux statistiques d'audience (exemple sur Google Analytics : Canaux > Organic Search).

Source de l'image : StatCounter

Mais en juillet et août 2019, StatCounter a décelé en France une baisse de -10% de PDM chez Google (notamment sur mobile, la raison parfois évoquée - l'apparition d'un menu permettant de choisir son moteur sur Android - nous semblant peu plausible pour un tel écart), un phénomène que nous n'avons par ailleurs constaté quasiment sur aucun site web pour lesquels nous avons consulté les données Analytics. L'outil a-t-il été spammé par de fausses stats sur cette période ? En tout cas, cela jette un voile d'ombre sur la fiabilité des résultats renvoyés par ce site… Malheureusement, à l'heure actuelle, il semble être le dernier des Mohicans et l'unique outil de ce type - ayant un minimum de notoriété - à rester disponible en ligne. Donc, il faut faire avec…

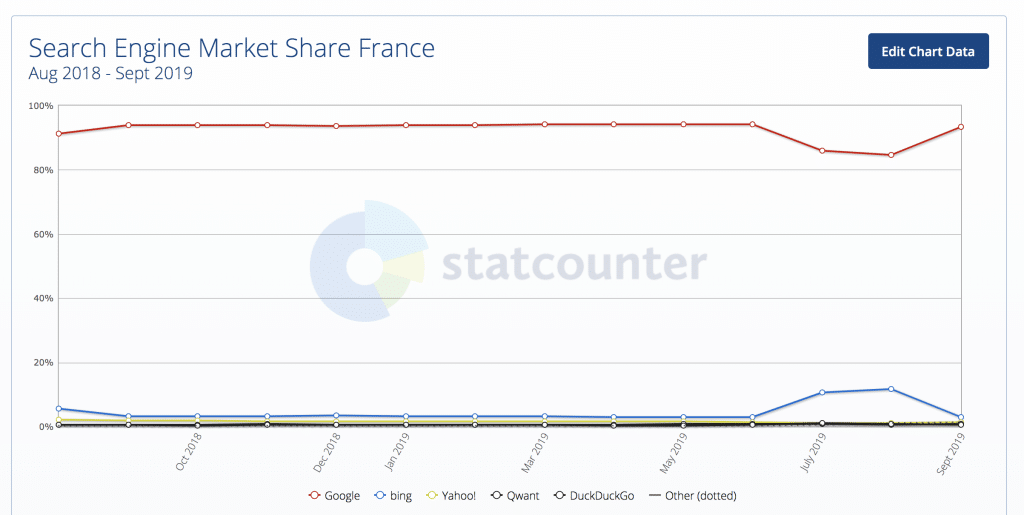

D'ailleurs, on voit sur l'illustration suivante que StatCounter semble avoir corrigé le tir depuis le début du mois de septembre, Google et Bing étant revenus à leurs statistiques d'avant l'été (93,5% pour Google, 2,9% pour Bing) :

Source de l'image : StatCounter

Ceci dit, on ne peut donc que constater qu'aujourd'hui, le seul baromètre existant sur ce modèle n'est pas d'une fiabilité absolue et peut proposer quelques "couacs" à certaines périodes. Est-ce dû à une base d'utilisateurs trop faible ? En effet, combien connaissez-vous de sites web utilisant les solutions de mesure d'audience de StatCounter ? Personnellement, aucun… Qui plus est en France, où cet outil semble peu répandu.

D'ailleurs, l'utilisation d'un tel outil ne résoudrait pas tous les problèmes. On sait par exemple qu'aujourd'hui, sur des moteurs comme Google (et certainement Bing), qui ont une vocation de "moteur de réponse", une SERP sur deux ne génère pas de clic, donc pas de trafic créé sur un site distant. Ce n'est pas rien… Ici, le "nombre de requêtes traitées" est donc le double du "nombre de requêtes générant un clic vers un site externe". Et ces stats sont certainement différentes sur des moteurs comme Ecosia, Lilo ou Qwant, pour lesquels les SERP sont plus "nues" et donc plus incitatives au clic vers un site web présent dans les résultats de recherche. Il y a donc disparité de l'analyse entre "moteurs de réponse" (Google, Bing) et "moteurs de recherche" (Qwant, Ecosia, Lilo…). Il faudrait donc tenir compte d'une sorte de coefficient (très complexe à calculer) tenant compte du phénomène des requêtes traitées mais ne générant pas de clic. Pas si simple, comme on peut le penser… On pourrait sinon se dire que les statistiques pour des moteurs comme Google ou Bing sont fournies a minima et sont certainement plus fortes dans la réalité. Pourquoi pas ? Ce n'est pas totalement satisfaisant, mais faute de grives…

Autre objection potentielle : le trafic perdu émanant d'internautes utilisant des "bloqueurs" (Ad blockers et autres) qui inhibent certains JavaScript et parfois les système de comptage de visites de type Analytics. Ce type de comportement reste-t-il suffisamment marginal pour que cela ne fausse pas les statistiques au point de ne plus les rendre représentatives ? Difficile à dire, mais le phénomène ne peut être nié… Tout comme les scripts qui pourrait être bloqués directement par les navigateurs (blocage de cookies et autres) dans le cadre de la "protection de l'utilisateur". On le voit, les obstacles sont nombreux...

Des résultats très différents selon les solutions

Et on ne peut même pas dire que, grosso modo, les différentes méthodes fournissent à peu près les mêmes résultats. On a déjà parlé plus haut de Google, qui aurait eu pendant deux mois autour de 85% de parts de marché en France selon StatCounter alors que, lorsqu'on regarde les statistiques réelles sur l'audience de nombreux sites web, on est bien plus proche des 92 à 95% du "search", voire plus (les résultats de StatCounter ont cependant été revu depuis, comme on l'a vu précédemment) !

Idem pour Qwant. Selon ce moteur qui cite parfois dans sa communication les chiffres de SimilarWeb, il aurait "5% de parts de marché" en France. Or l'analyse de statistiques d'audience réelles (une discussion récente sur Twitter à ce sujet a d'ailleurs donné de nombreux chiffres très intéressants, plusieurs webmasters partageant leurs statistiques à ce sujet) pour des sites très différents (en trafic et thématiques)) indique plutôt une fourchette entre 0,5% et 1% du trafic "search" en France pour Qwant (proportion confirmée d'ailleurs par StatCounter). Soit à peu près les mêmes chiffres que ses concurrents Ecosia et DuckDuckGo, voire Lilo. Et on ne parle même pas des 8% indiqués à une époque par Médiamétrie qui eux, étaient clairement risibles (à tel point que même Qwant avait pris ce chiffre avec des pincettes, à l'époque, même s'il continue à citer ce chiffre sur les réseaux sociaux, c'est tellement tentant 😉 )…

On le voit, selon les outils utilisés et les études citées, les chiffres peuvent vite s'affoler et partir dans tous les sens. La situation n'est pas simple…

Conclusion : alors, on fait comment ?

Bonne question, sachant que les chiffres actuels sont la plupart du temps plus ou moins faux 🙂

Explorons les différentes solutions possibles :

• On l'a dit, un système qui agrègerait le nombre de requêtes traitées par chaque moteur, sur la base de données vérifiées et fournies par chaque outil serait idéal mais est utopique. N'y pensons pas.

• La situation idéale pour la France serait alors l'aggrégation des chiffres de "search" (trafic généré sur les sites utilisant ces outils) de Google Analytics, AT Internet, Matomo et StatCounter (voire d'autres éventuellement). Cela semble hélas impossible. Bad luck pour l'instant…

• Continuons nos hypothèses avec un baromètre proposé spécifiquement par Google sur la base des résultats de son outil Google Analytics, affichant des statistiques regroupant les chiffres constatés sur les sites ayant intégré cette solution. Bref, un StatCounter à l'échelle de l'Analytics du moteur de recherche leader. Ce baromètre serait très fiable (au vu de l'énorme base de sites utilisant cette solution), mais la firme de Mountain View serait certainement taxée d'être juge et partie et les résultats fournis remis en cause. De plus, le fait que le trafic "Organic Search" d'Analytics exclut bizarrement certains moteurs (exemple : Qwant en France) affaiblirait les résultats et obligerait à jongler pour obtenir un classement plus fiable. Ceci dit, ce type de baromètre ne semble pas être à l'ordre du jour du côté de la firme de Mountain View. Mais sait-on jamais ?

• At Internet et Matomo pourraient additionner leurs stats et proposer un baromètre commun. Ou l'un ou l'autre pourrait proposer son propre outil d'analyse, comme l'avait fait At Internet à l'époque de XiTi, et ces statistiques seraient certainement plus fiables que celles de StatCounter, bien que limitées à la France. Mais ces sociétés ont-elles envie de créer un tel baromètre ?

• Un consortium pourrait se créer, au sein duquel un certain nombre de sites web, de tailles et de thématiques différentes, pourraient échanger certaines données d'audience sur leur trafic "search", pour éditer un baromètre qui soit le plus représentatif possible du PIF (Paysage Internet Français) ? Certainement complexe à mettre en place, mais pourquoi pas ?

On le voit bien, aucune solution simple n'est disponible à l'heure actuelle. Il faudra donc se contenter de ce que l'on a….

Alors, cela signifie qu'on ne peut pas mesurer et comparer de façon objective et fiable les PDM des différents moteurs de recherche ?

Exact 🙁

A l'échelle d'un pays, c'est tout bonnement impossible en l'état actuel des choses et des outils disponibles, de façon fiable et précise. En même temps, dès qu'on parle de mesure d'audience sur le Web, les notions de fiabilité et de précision deviennent très relatives...

Ceci dit, rien ne vous empêche de regarder les parts de trafic "search" sur votre site, ou sur les sites que vous gérez, pour avoir des informations de la meilleure fiabilité possible (tout en pensant bien à vérifier que TOUS les moteurs de recherche sont pris en compte, comme Qwant, oublié par Google Analytics dans la partie "Organic search" et pour lequel il faudra aller chercher les chiffres dans la zone "Referral"). Si vous gérez plusieurs sites, vous pouvez agréger leurs statistiques.

Mais pour comparer vos chiffres à une moyenne nationale, ou obtenir cette dernière, cela deviendra complexe et en tout cas à l'heure actuelle peu fiable (StatCounter), peu adapté (SimilarWeb) ou carrément lunaire (Médiamétrie)…

Nous n'avons d'ailleurs pas parlé dans cet article des app (Android / iOS) des moteurs : qu'en est-il ? Le trafic généré par ces applications mobiles est-il pris en compte dans les baromètres et études actuels ? Pas si sûr...

Ceci dit, le "meilleur" outil (ou plutôt le moins pire) reste selon nous StatCounter, avec toutes ses imperfections certes, mais il est clairement l'outil qui se rapproche le plus de ce que l'on retrouve dans les stats d'audience de nos sites. Il est juste dommage qu'il ait dérapé pendant deux mois pour les données concernant Google et Bing (les autres moteurs semblant moins touchés).

Mais si un nouvel acteur désire entrer sur le marché et proposer un outil plus fiable, il serait le bienvenu, bien entendu !

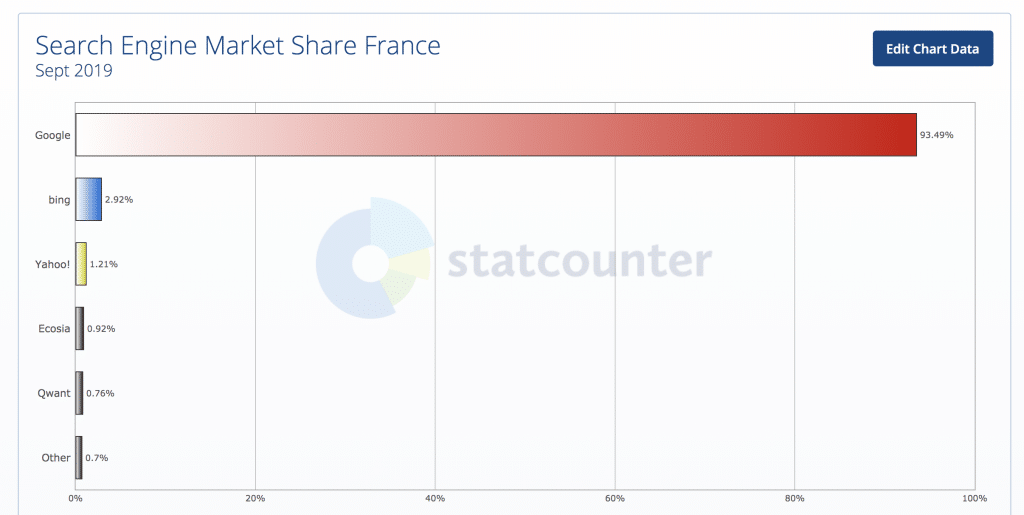

Ceci dit, s'il fallait donner des chiffres, ou des fourchettes, basées sur les statistiques "search" constatées sur de très nombreux sites web (de toutes tailles et dans de nombreuses thématiques), on pourrait donner les fourchettes suivantes pour les PDM des différents moteurs de recherche en France :

• Google : entre 92 et 95% du trafic "search" en France ;

• Bing : entre 2 et 5% ;

• Yahoo! : entre 1 et 3% ;

• Ecosia, Qwant et DuckDuckGo : entre 0,5 et 1% chacun.

Il s'agit certainement des chiffres les plus plausibles, basés sur l'analyse du trafic de très nombreux sites, avec des variations en fonction des mois, des sites et des versions (desktop/mobile), bien entendu… Ce sont d'ailleurs, grosso modo, les chiffres fournis par StatCounter en septembre 2019 :

Source de l'image : StatCounter

Merci Olivier de ces éclaircissements nécessaires. On entend ou lis dans les médias des chiffres irréaliste, qui ne se reflètent pas dutout dans les stats GG Analytics ni même dans les logs. Un peu de vérité est positif pour mesurer les acteurs et influences sur l’internet Français, c’estait nécessaire.

Dans la conclusion finale, on pourrait aussi différencier les versions mobiles et desktop…

Oui, les chiffres indiqués ici sont tous types de terminaux confondus…

Merci pour cet éclaircissement plus que nécessaire ! (vu la dernière polémique avec Qwant)

Toujours aussi pointu, fiable et avec beaucoup de recul et d’objectivité, cher Olivier Andrieu ! BRAVO !

Merci 🙂