Une nouvelle étude - portant uniquement sur des critères quantitatifs - nous montre que les plus gros sites web de la planète sont loin d'être les plus optimisés en termes de SEO...

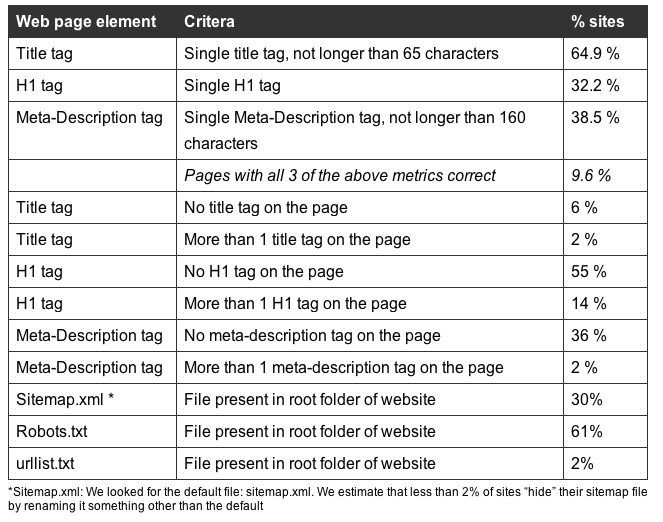

Le site Free SEO Scorecard a étudié 1 million de sites web et leur optimisation au niveau des fondamentaux SEO : balises Title, meta "description", H1, ainsi que sur la présence de fichiers robots.txt et Sitemap. Les sites web analysés sont les mieux classés selon Alexa, donc a priori plutôt de gros sites web (a href="http://freeseoscorecard.com/research/top_million_sites.rar" target="_blank">en voici la liste).

Il est cependant à noter que seule la présence et la taille des balises ont été testées, pas leur contenu sémantique. Idem pour le robots.txt et le Sitemap : seule leur présence ont été testée, ce qui est plus contestable (mais des critères automatisés sont, il est vrai, plus complexes à mettre en place dans ce cas).

Voici les principaux résultats de cette étude :

Source de l'image : Abondance |

Il faut quand même noter que :

- 55% des sites web n'ont pas de balise H1.

- 36% n'ont pas de meta "description".

- 2% ont plus d'une balise Title.

- Moins de 10% ont des balises Title, meta "description" et H1 correctes (selon les critères utilisés).

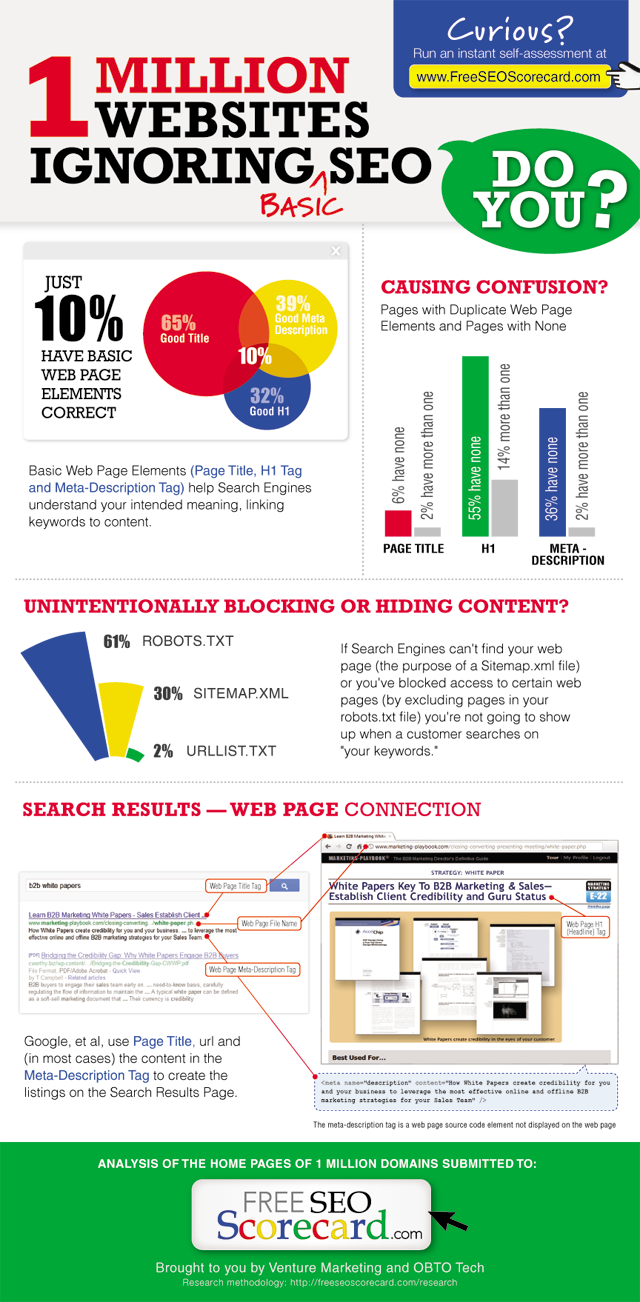

Une infographie est également proposée sous cette forme:

Source de l'image : Abondance |

Une étude - cette fois qualitative - reste encore à faire au niveau des différents critères imaginés, mais le premier constat que l'on peut tirer de cette étude est qu'en termes de SEO, il reste encore beaucoup de chemin à parcourir pour de nombreux sites... Et notre quotidien nous le montre à l'évidence...

Le SEO est important mais les outils sont bien intégrés dans les outils Web. Au final faire un site Web + / – optimisé pour le SEO ne demande que peu d’efforts supplémentaires et n’est qu’un élément pour être bien placé dans le classement de google.

Bonjour

Je rejoins l’avis de Ramzi. Finalement quand on est un gros site, le seo est-il toujours nécessaire ? Il faut le concevoir comme un levier au meme titre que le Sea ou une com’ via les réseaux sociaux. On parle de title alors que l’utilisateur n’y prete pas attention par exemple. Je ne dis pas que le Seo n’est pas important, je pense juste que pour certains sites (les gros notamment) ce n’est pas forcément le levier le plus stratégique.

Single H1 ? En quoi ça serait un critère positif pour le onpage ?? Ca n’a aucun sens… (c’est une des multiples incohérences de cette étude, d’ailleurs :(( )

Jamais entendu parler du urllist.txt … D’un autre coté, je ne dois pas être vu que seuls 2% des sites ne s’en servent 🙂

Le bon coté des choses, c’est que ça donne du travail aux professionnels du web & co.

D’un autre coté, ce qu’il aurait été de savoir, c’est l’impact de ces erreurs sur le référencement et l’accessibilité des sites. Car, comme le fait remarquer Thierry, si tout marche bien malgré ces erreurs, à quoi bon se prendre la tête …

Ça ne m’étonne pas ce chiffre quand je vois le nombre de sites mal optimisé ou même pas du tout optimisé parfois. Mais vu ou va le SEO avec Google je pense que de moins en moins de sites seront optimisés car le référencement est de plus en plus long donc de plus en plus coûteux.

@Olivier Andrieu: thank your for posting this. My team conducted the 1million site research and created the FreeSEOScorecard.com website.

@ DenisTRUFFAUT: We very much want to do a second research project, collecting data/elements like those you’ve listed.

If we were able to evaluate 10 things (including loading speed, 404, etc.), which are most important to you?

Moi j’arrive avec Google PageSpeed à 98/100. (futur site en ligne)

Et pour ça il faut une configuration aux petits oignons + un développement d’un framework spécifique:

Serveur web nginx, compressions, sprites, mise en cache et nombre de requête pour la 3G. Enfin cela pour dire que ce n’est pas que du développement pure.

@ DenisTRUFFAUT : je suis assez d’accord. En espérant que ça donne des idées à des développeurs du coin :-))

Mouais, certains éléments sont vraiment discutables, notamment la longueur maximale du title et de la description. Google les prend en compte, c’est juste qu’il limite l’affichage à cette longueur de texte. Nuance.

Le « sitemap qui doit être à la racine du site », c’est du grand n’importe quoi, ça n’a jamais été un critère de positionnement. En revanche, son chemin doit être précisé dans le robots.txt.

Le « robots qui doit être à la racine du site », c’est largement dispensable si on dispose de la redirection / réécriture d’url adéquate.

Tout ça pour dire que quand on est un minimum ordonné, on évite de placer la totalité de ses fichiers à la racine du site.

Il aurait été plus sympa d’avoir des stats sur le taux de 404, le ratio texte/balise, les perfs GooglePageSpeed, le poids de la page, l’utilisation de la compression, de sprites CSS, les rel next/prev, les rel alternate hreflang, les microdata… etc. Des trucs un peu plus costauds, quoi.

Bref, si c’est sur le fond une bonne initiative, les critères de testing sont à revoir pour espérer gagner en crédibilité.

Je jette un pavé dans la mare :

Si 90% des sites ne sont pas optimisés, que le monde de l’internet continue de tourner à correctement, et que les webmasters n’ont font qu’à leur tête… Y’a peut être quelques bonnes questions à se poser …. non ??

Un des commentateurs a dit que c’était une bonne chose pour les référenceurs. Je crois plutôt à l’inverse que c’est l’un des signes que de plus en plus Google a tendance à privilégier les gros sites, c’est à dire les grandes marques.

Si je réussis a trouver le site d’une grande marque par son nom sans recours à des pratiques seo, c’est bien que pour Google les fameuses techniques que lui même a pu parfois vouloir mettre en avant ( Balises title uniques, linking interne….) ne sont pas forcément essentielles

Petire coquille sur : (a href= »http://freeseoscorecard.com/research/top_million_sites.rar » target= »_blank »>en voici la liste).

Avant 2006, je faisais du SEO dans mon berceau boudiiii !

urlist.txt c’est un vieux truc (<=2006 de mémoire) une ligne égale une url.

Le sitemap.xml est arrivé après car il permet plus de chose, c'était l'époque des blogs.

Marrant en 2012 google continue à le traité.

si on reprend la vue de GG, 10% des sites sont des spammeurs, puisque maintenant le SEO est banni 😉

urllist.txt semble être le nom imposé par Yahoo! pour le Sitemap, mais j’avoue avoir peu d’infos sur ce sujet. Est-il vraiment encore d’actualité aujourd’hui que YST n’existe plus ? Quelqu’un a des infos ? Merci !

Bonjour Olivier,

je n’ai jamais entendu parlé du fichier urllist.txt, qu’est-ce donc ? Est-il vraiment important pour le référencement ?

C’est bien pour ça (entre autre) que le métier de SEO a de l’avenir.

Rien qu’en optim interne on a du taf, alors avec l’externe en plus…

Et ça ne parle pas des sites non indexés ou des parties complètes de sites non crawlables. Donc 10% c’est déjà sympa.