Google vient d’annoncer une avancée majeure dans ses technologies de traitement de données : le Graph Foundation Model (GFM), un algorithme d’IA capable d’analyser et de généraliser des structures complexes de données sous forme de graphes. Cette innovation promet des performances inédites pour la détection du spam, la compréhension du web et, de fait, bouleverse les repères du SEO. Mais en quoi ce nouveau modèle va-t-il impacter le travail des professionnels du référencement naturel ? Tour d’horizon des changements à anticiper, des risques à éviter et des opportunités à saisir.

Ce qu'il faut retenir :

- Google booste la compréhension du web : le GFM permet à Google d’analyser les sites et leurs liens d’une façon bien plus fine, détectant les relations entre contenus et entités à une échelle jamais atteinte.

- Un bouleversement dans la lutte contre le spam : les schémas artificiels de liens et de contenu sont désormais plus facilement repérables, ce qui risque de transformer profondément le SEO “à la limite”.

- La pertinence et la structure priment : avec le GFM, miser sur la cohérence sémantique et la qualité du maillage interne devient encore plus important pour se démarquer.

- Le SEO s’adapte à l’IA : les professionnels du secteur doivent revoir leurs stratégies en tenant compte de cette nouvelle capacité de Google à cartographier et interpréter les réseaux d’informations complexes.

Comprendre le Graph Foundation Model de google

Le Graph Foundation Model s’inscrit dans la famille des modèles d’intelligence artificielle spécialisés dans l’analyse de données relationnelles. Concrètement, il permet de transformer tout un ensemble de tables de données (typiques d’une base de données structurée) en un vaste graphe, où chaque ligne devient un nœud, et chaque relation (clé étrangère) une arête reliant ces nœuds.

À la différence des anciens Graph Neural Networks, qui devaient être entraînés à chaque nouveau type de graphe, le GFM sait généraliser et attaquer n’importe quel nouveau jeu de données relationnelles sans avoir besoin d’un nouvel entraînement. Cette évolution donne un net avantage à Google : le moteur peut interpréter la structure du web, ses contenus, ses liens, avec plus de subtilité, même quand la structure évolue.

Une révolution pour l’analyse du web et la recherche

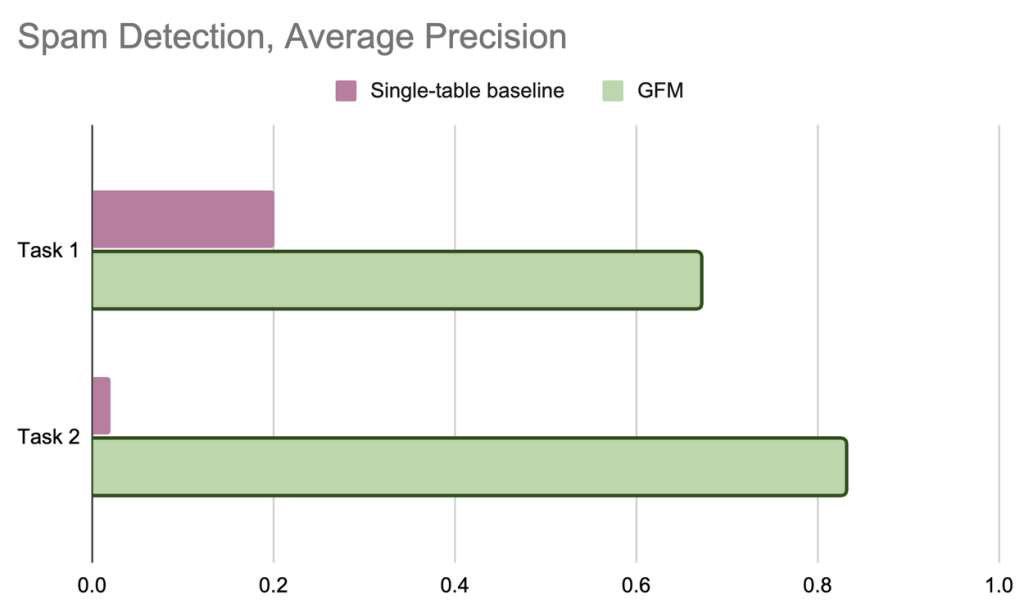

Les ingénieurs de Google le disent eux-mêmes : le GFM n’est pas simplement une optimisation, mais un véritable saut de performance. Selon leurs propres tests à grande échelle (ex : détection du spam Google Ads), la précision des analyses grimpe de 3 à 40 fois ! Ce bond est rendu possible non seulement par la capacité du modèle à voir toutes les relations cachées entre les données, mais aussi par la facilité à le déployer sur des systèmes complexes.

En SEO, cette capacité à relier des silos de contenus, à détecter les points communs ou les anomalies entre différents sites et réseaux de liens, va radicalement transformer l’analyse de l’information. Plus que jamais, les stratégies de netlinking, d’organisation du maillage interne et d’optimisation de la structure des contenus vont être placées, sous le microscope du moteur.

Les implications concrètes pour le SEO

Optimisation du maillage interne et structure des sites

Le GFM va permettre à Google d’aller bien au-delà du simple comptage des liens internes. Il saura interpréter la logique sémantique qui relie chaque page, chaque segment éditorial, et détectera si le maillage a été conçu pour améliorer la navigation, appuyer une thématique ou… manipuler l’algorithme de classement. Cela renforce l’importance de construire des structures de site authentiques, répondant réellement aux besoins de l’utilisateur.

Compréhension sémantique et poids des entités

En convertissant chaque contenu, entité et relation dans un immense graphe, le GFM affine la compréhension de la sémantique des pages. Le moteur saura mieux détecter les sujets traités, la pertinence des contenus, la cohérence entre pages, et la qualité des entités (marques, personnes, lieux). Cela signifie que travailler sur les données structurées, les balises sémantiques, et la consistance éditoriale devient indispensable pour « parler le même langage » que Google.

Lutte renforcée contre les manipulations et le spam

Parmi les premiers tests, c’est la détection de spam qui ressort avec des progrès spectaculaires. Le GFM sait faire le lien entre des réseaux de sites ou de pages liés de façon artificielle, détecter des patterns suspects dans les échanges de liens, et repérer les tentatives de manipulation à l’échelle de plusieurs sites, voire de tout un secteur. Les professionnels doivent donc faire en sorte de bannir les stratégies trop agressives ou automatisées de netlinking.

Knowledge Graph et personnalisation accrue

L’IA de Google gagne aussi en capacité à enrichir son Knowledge Graph : plus les relations entre pages et entités sont compréhensibles, plus les moteurs pourront générer des résultats enrichis (extraits, knowledge panels, réponses directes). Les sites ayant travaillé leur structure de données et leur sémantique seront favorisés dans la génération de ces SERPs de nouvelle génération.

Conseils pratiques pour les professionnels du SEO

- Soignez la qualité du maillage interne : pensez logique éditoriale et expérience utilisateur avant tout, plutôt qu'accumulation de liens.

- Misez sur la sémantique et les entités : utilisez des schémas de données structurées, enrichissez vos contenus autour d'entités fortes et de sujets bien définis.

- Évitez les artifices : esquivez les réseaux de liens ou le contenu dupliqué, le GFM se montre bien plus apte à les repérer.

- Adoptez une veille continue : suivez les évolutions de l’IA, analysez vos performances sous l’angle des relations et de la structure, et adaptez vos stratégies en continu.

Regards d’experts et retours terrain

La communauté SEO s’accorde à dire que l’arrivée du GFM marque un tournant : la notion de « structure » et « d’entités » prime sur celle de quantité pure de contenus ou de liens. Les premières analyses montrent que les stratégies gagnantes sont celles qui misent sur la pertinence, la cohérence et une réelle valeur ajoutée pour l’utilisateur, loin des schémas artificiels du passé.

Pour les professionnels du SEO, l’objectif est clair : évoluer vers des stratégies transparentes, sémantiques et structurées ; ou alors risquer de voir la visibilité dégringoler face à des moteurs de plus en plus « intelligents », en mesure de déceler les veilles combines techniques et approximations structurelles.