Des internautes ont découvert que lorsqu'on demandait à Google Translate certaines traductions depuis des langues peu répandues, le résultat devenait complètement fou et conduisait même à des prophéties bibliques annonçant la fin du monde et le retour du Christ. Ou quand l'intelligence artificielle dérape...

Des internautes ont découvert que lorsqu'on demandait à Google Translate certaines traductions depuis des langues peu répandues, le résultat devenait complètement fou et conduisait même à des prophéties bibliques annonçant la fin du monde et le retour du Christ. Ou quand l'intelligence artificielle dérape...

Google utilise des technologies d'intelligence artificielle pour mettre en place les traductions de son outil Google Translate. mais parfois, le système déraille complètement et le résultat peut même parfois faire peur...

Des utilisateurs du site Reddit s'en sont en effet aperçu et on appelé le phénomène "Translate Gate" (le site propose de très nombreux exemples de traductions très... étonnantes 🙂 ). Le problème survient notamment lorsque vous demandez une traduction, même (et surtout) de mots ne signifiant a priori rien, d'une langue peu connue vers une langue bien plus répandue. Prenons un exemple avec le mot "ag" dont vous allez demander une traduction du maori vers l'anglais. En fait, il faut répéter ce mot plusieurs fois pour voir les traductions fantaisistes arriver : "it is read" (traduction de "ag ag ag ag"), "it is countless" ("ag ag ag ag ag"), "it is very urgent" ("ag ag ag ag ag ag ag ag"), "it is very unreasonable" ("ag ag ag ag ag ag ag ag ag ag"), "We are very hungry and we are hungry" (ag ag ag ag ag ag ag ag ag ag ag ag ag ag"), "How much a greedy desire to be hungry?" ("ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag"), "we will not be able to get all the things we need." ("ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag ag"), etc. Quelqu'un parle-t-il le maori dans la salle pour confirmer ces traductions ? Nous, on doute un peu de l'efficacité de l'outil sur ce coup. 😉

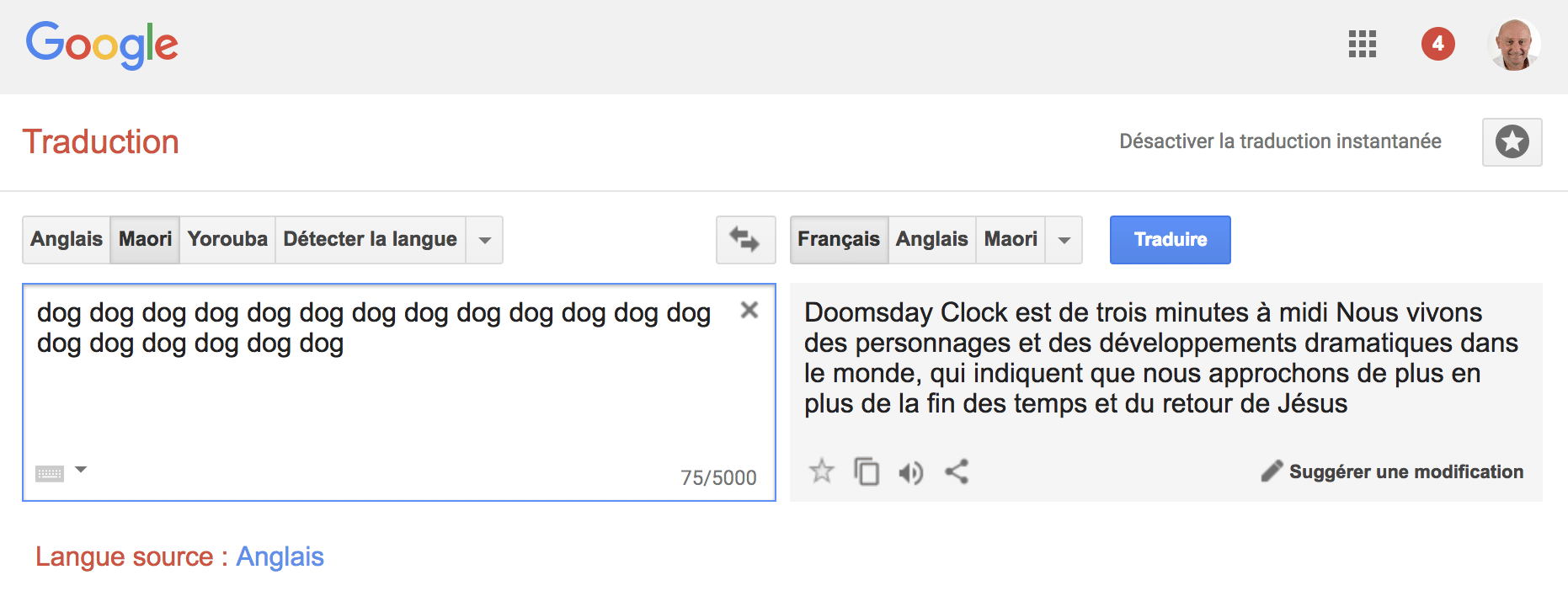

Le système peut même partir dans des traductions totalement surréalistes, comme des prophéties bibliques lorsqu'on tape 19 fois le mot "dog" et qu'on demande une traduction du maori vers le français, ce qui donne :

Traduction étonnante du maori vers le français. Source : Abondance

Traduction étonnante du maori vers le français. Source : AbondanceLe problème viendrait en fait de la procédure d'apprentissage automatique et de l'intelligence artificielle embarquée dans ces algorithmes : ils ont besoin de textes de référence et si possible des textes traduits dans de nombreuses langues. Autant dire que la Bible est un bon exemple... Dans certains cas très complexes de traductions très peu demandées, il semblerait donc que l'algorithme perde ses billes et revienne à des textes connus, sur lesquels il a des repères, ce qui donne ce type de résultat étonnant. Bref, ses réseaux de neurones pètent une synapse. Heureusement que cela n'arrive que sur des traductions et des phrases dont le moins que l'on puisse dire est qu'elles sont peu demandées. Sauf en ce moment peut-être... 😉

Essayez de Maori vers Anglais: « ag go go ag go ag go »

Quand Google se prends pour Nostradamus !

Tout est perfectible

Une Image n’est pas le reflet de tout le film