Google vient de publier son rapport sur le spam pour l'année 2020 et les chiffres qui y sont indiqués sont assez incroyables et en forte augmentation depuis l'année dernière...

Google a annoncé et publié cette semaine son Webspam report 2020, comme chaque année, pour donner quelques informations sur la façon dont il lutte au quotidien contre les attaques venues de l'extérieur.

À ce sujet, il explique que, chaque jour, il détecte désormais 40 milliards de pages de spam. Rappelons que l'année dernière, ce chiffre n'était « que » de 25 milliards, ce qui semblait pourtant déjà énorme à cette époque ! Voici ce qui est dit dans cette annonce : « En 2020, nous avons détecté 40 milliards de pages de spam chaque jour - y compris des sites qui ont été piratés ou créés de manière trompeuse pour voler vos informations personnelles - et les avons empêchés d'apparaître dans les résultats. (…) Le spam de contenu piraté était encore très répandu en 2020 car le nombre de sites web vulnérables est resté assez important, bien que nous ayons amélioré notre capacité de détection de plus de 50 % et supprimé la plupart des spams piratés des résultats de recherche. ».

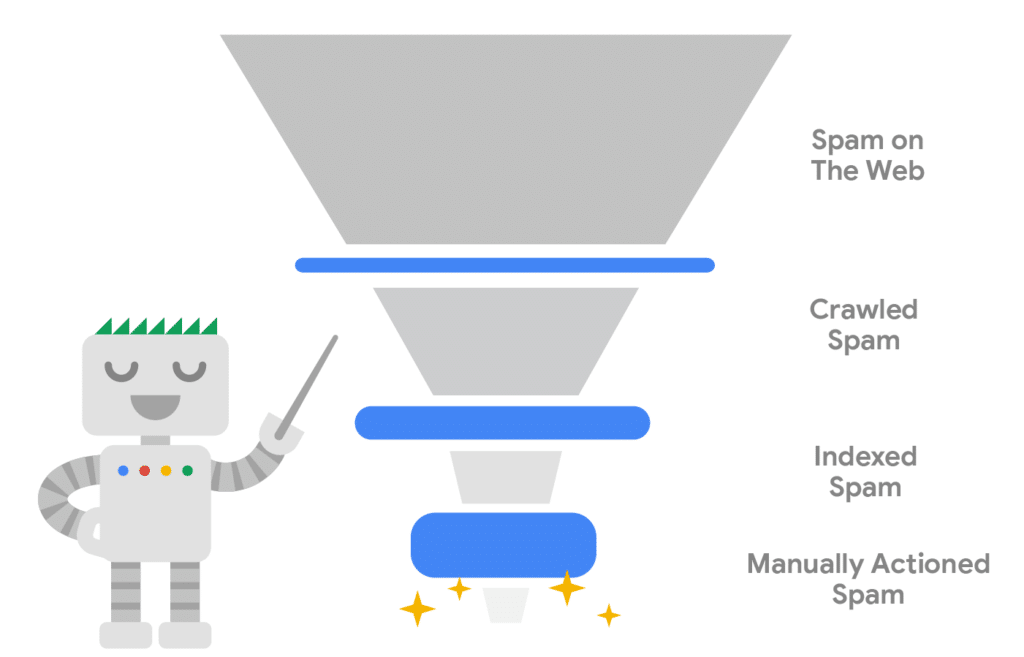

La détection du spam peut se faire via la navigation naturelle, la lecture des fichiers Sitemaps XML ou les soumissions d'URL dans la Search Console, comme il est expliqué dans le rapport : « Par exemple, la Search Console dispose d'une fonction de demande d'indexation qui permet aux éditeurs de sites de nous signaler les nouvelles pages qui doivent être ajoutées rapidement. Nous avons observé que des spammeurs pirataient des sites vulnérables, se faisaient passer pour les propriétaires de ces sites et utilisaient l'outil pour demander à Google d'explorer et d'indexer les nombreuses pages de spam qu'ils créaient. Grâce à l'IA, nous avons pu repérer les vérifications suspectes et empêcher les URL de spam d'entrer dans notre index de cette manière. (…) Ensuite, nous avons des systèmes qui analysent le contenu qui est inclus dans notre index. Lorsque vous lancez une recherche, ils vérifient si le contenu qui correspond est du spam. Si tel est le cas, ce contenu n'apparaîtra pas dans les premiers résultats de recherche. Nous utilisons également ces informations pour améliorer nos systèmes afin d'éviter que ces spams ne soient inclus dans l'index. (…) Nous estimons que ces systèmes automatisés permettent de garder plus de 99 % des visites du moteur totalement exemptes de spam. Quant à l'infime pourcentage restant, nos équipes mettent en place des Actions manuelles et utilisent les enseignements tirés de ces mesures pour améliorer encore nos systèmes automatisés. »

Il est clair que la lutte contre ce fléau qu'est le spam (sous toutes ses formes : spam, piratage, création de contenu de faible qualité, liens factices, etc.) est l'une des principales préoccupations de Google. De là à dire, comme ci-dessus, que 99% des SERP sont "spam-free", c'est peut-être aller vite en besogne et donner une image par trop idyllique de la situation. Ceci dit, il est clair qu'au vu des chiffres publiés cette semaine, la situation empire chaque année et devient de plus en plus problématique… Pour la crédibilité du métier de SEO également, d'ailleurs…

Différentes étapes de la détection du spam par Google. Source de l'image : Google

40 milliard : ce chiffre est juste dingue !