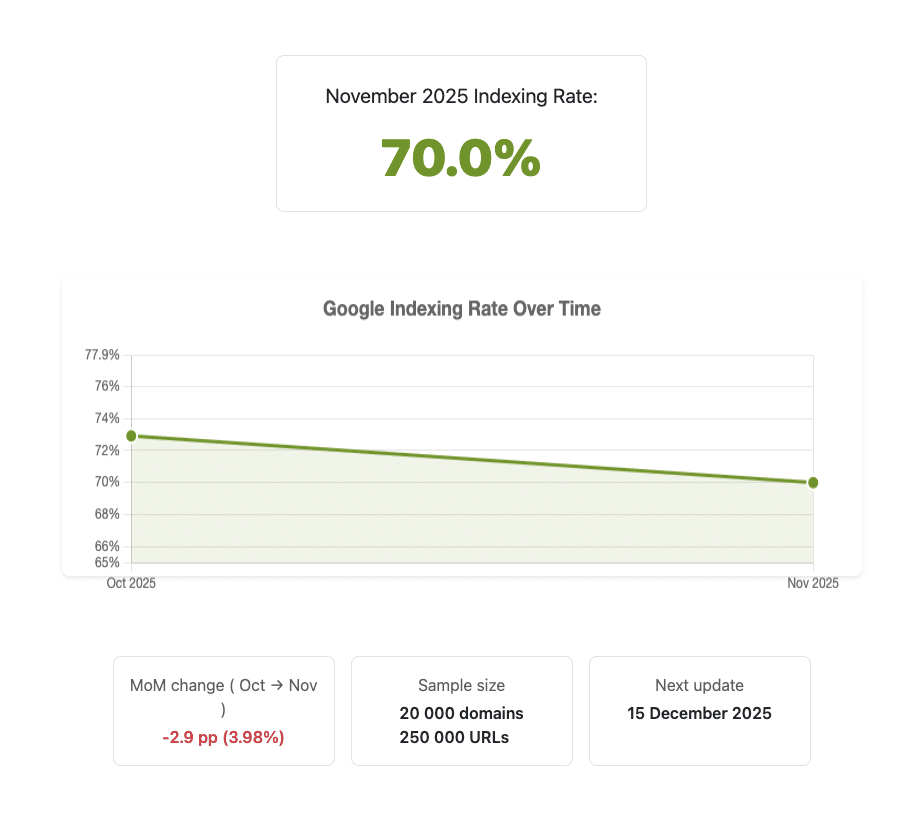

Pendant des années, les SEO n’ont eu accès qu’à des signaux indirects pour évaluer le « vrai » taux d’indexation de Google : logs serveur, Search Console et outils maison. Avec Indexometer, IndexCheckr propose un indicateur mensuel public basé sur un échantillon de 250 000 pages réparties sur 20 000 sites. Celui-ci montre notamment qu’en novembre 2025, seules 70 % des pages testées sont effectivement indexées.

Ce qu'il faut retenir :

- En novembre 2025, Google n’a indexé que 70,0 % des 250 000 URLs testées, contre 72,9 % en octobre, soit une baisse d’environ 4 % du volume de pages indexées entre les deux mois.

- L’indicateur repose sur un échantillon large et diversifié : 20 000 domaines sélectionnés dans le Top 1M Tranco, avec environ 50 URLs par site issues des sitemaps publics, couvrant aussi bien des pages récentes qu’anciennes.

- Chaque URL est testée une fois auprès de Google, y compris si elle renvoie une erreur HTTP, ce qui donne une mesure volontairement prudente, mais représentative de ce que Google garde ou non dans son index.

Un baromètre inédit du taux d’indexation de Google

Lancé il y a peu, Indexometer est le premier baromètre public qui mesure, mois après mois, la part des pages effectivement indexées par Google sur un large échantillon du web. Là où l’on se contentait jusqu’ici d’études ponctuelles ou de données propriétaires, l’outil propose une série temporelle pensée pour durer, avec une méthodologie stable et documentée.

Pour novembre 2025, l’indicateur affiche un taux d’indexation de 70,0 %, contre 72,9 % en octobre, ce qui correspond à une baisse de 2,9 points de pourcentage, soit environ 3,98 % de pages indexées en moins dans l’échantillon. Concrètement, cela signifie qu’en moyenne, 3 pages sur 10 d’un site « moyen » de l’échantillon ne sont pas visibles dans Google, même si elles sont bien en ligne et déclarées dans les sitemaps.

Une méthodologie pensée pour représenter le web réel

L’un des points forts d’Indexometer est la transparence de sa méthodologie, basée sur des principes assez simples, mais rigoureux. Les domaines sont tirés du Top 1M Tranco, en répartissant la sélection entre les rangs 100 et 1 000 000, ce qui permet de couvrir aussi bien des grands sites très visibles que des acteurs de la « longue traîne ».

Sur chaque domaine retenu, l’outil extrait environ 50 URLs à partir des sitemaps XML publics, en mélangeant des pages plus anciennes et des pages plus récentes afin de limiter les biais liés à la fraîcheur. Les formats non HTML (PDF, images, flux…) et les doublons évidents sont exclus pour se concentrer sur des pages réellement destinées à apparaître dans les résultats organiques.

Comment la mesure d’indexation est réalisée

Chaque URL de l’échantillon est testée une seule fois pour savoir si elle est actuellement indexée par Google, ce qui permet de rester scalable tout en couvrant un volume de 250 000 pages par mois. Particularité importante : les URLs qui renvoient des codes 4xx ou 5xx au moment de la vérification sont conservées, car ces pages peuvent parfois subsister dans l’index malgré une erreur serveur ponctuelle.

Les résultats sont ensuite agrégés pour produire le taux global : la part de toutes les URLs testées qui sont détectées comme indexées. À partir de ce même jeu de données, les créateurs d’Indexometer peuvent dériver des analyses complémentaires par CMS, TLD ou autres segments, même si la donnée mise en avant reste le pourcentage global pour garder le baromètre lisible.

Une mesure mensuelle pour suivre la tendance

Le protocole est répété chaque mois avec un nouveau tirage de domaines et d’URLs, ce qui permet de suivre la dynamique de l’indexation dans le temps plutôt que de rester sur une simple photographie. Les créateurs de l’outil insistent sur le fait que les variations mois par mois peuvent intégrer un peu de bruit statistique, alors que les tendances sur plusieurs mois sont plus fiables.

Le lancement d’Indexometer s’inscrit aussi dans un contexte où Google ajuste fortement ses critères et sa capacité d’indexation, notamment avec les mises à jour « helpful content » et les core updates récentes qui durcissent la sélection des pages jugées dignes d’être servies. Pour les SEOs, disposer d’un indicateur externe et indépendant de Search Console permet de mieux distinguer ce qui relève de la santé d’un site individuel de ce qui reflète un mouvement global dans la façon dont Google gère son index.

Ce que ça change pour les professionnels

Indexometer nous rappelle en premier lieu que l’indexation n’a rien d’automatique : même pour des pages présentes dans un sitemap, environ 30 % restent hors de l’index à l’échelle de l’échantillon. Cela oblige à considérer l’indexation comme un objectif à part entière, au même titre que le crawl ou le ranking, et à lui consacrer un pilotage spécifique.

Ensuite, le léger recul de 72,9 % à 70,0 % en un mois rappelle que Google peut resserrer ou desserrer le robinet d’indexation, avec des effets globaux qui dépassent les seuls problèmes techniques individuels. Suivre l’évolution mensuelle aide à interpréter certaines chutes de pages indexées dans Search Console : ce n’est pas toujours le site qui est en cause, parfois c’est l’appétit global de Google qui est sujet à des variations.