La Search Console de Google est un outil clairement indispensable pour la bonne gestion SEO d'un site web. Mais il souffre de quelques lacunes qu'il serait intéressant de combler en 2016. N'est-ce pas la période des bonnes résolutions ? Voici donc quelques pistes de réflexion pour améliorer l'existant...

La Search Console de Google (anciennement Webmaster Tools) est, pour moi, un outil essentiel au suivi et à la gestion, la mise à jour et l'administration d'un site web. Il s'agit de l"info vue par Google" qui permet de travailler quotidiennement à une meilleure qualité des données fournies en ligne, à la fois aux internautes et aux robots des moteurs. C'est absolument indéniable. Pour ma part, je travaille tous les jours sur cet outil pour améliorer les sites de mes clients. Certaines zones sont très intéressantes, voir essentielles, d'autres moins, mais peu importe, la Search Console existe et c'est déjà un point incontournable pour mener à bien notre (si complexe) métier.

Alors, comme on est à la fin de l'année 2015 et que les bonnes résolutions vont bientôt pleuvoir pour 2016, voici quelques améliorations que j'aimerais bien voir apparaître sur cette Search Console l'année prochaine. N'hésitez pas, si vous le désirez, à donner vos propres idées - constructives - dans les commentaires de cet article, je suis sûr que certain(es) googler(use)s viendront les lire pour y piocher quelques infos sympathiques et y glaner des idées de projets pour la nouvelle année...

Dossiers de propriétés

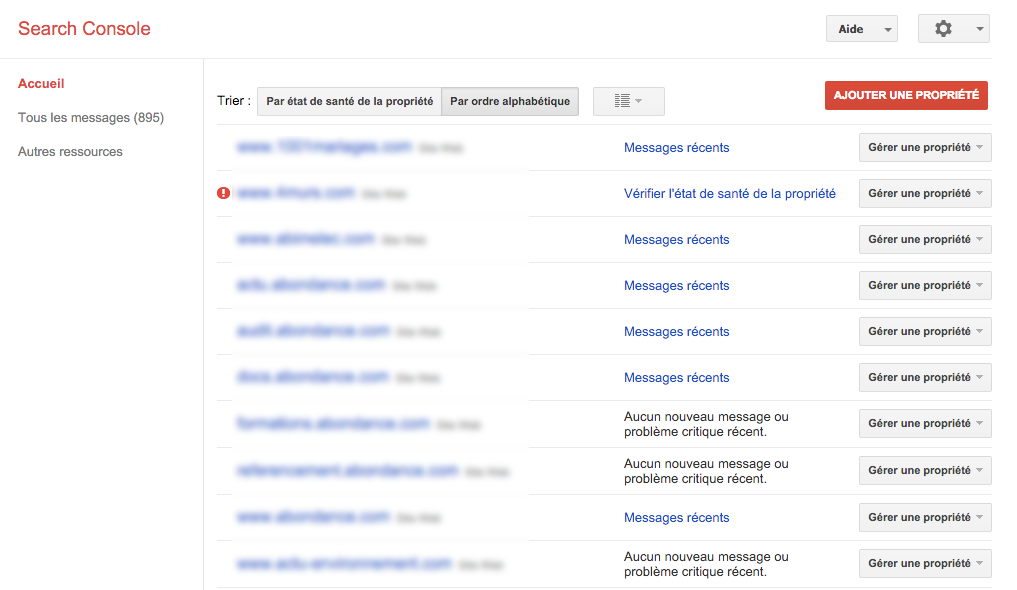

Lorsque vous ne gérez qu'un ou deux site(s) web, il n'y a globalement pas de problème à les traiter sous la Search Console. Mais, pour ma part, et c'est le cas de nombreux référenceurs ou éditeurs de sites, je demande à mes clients un accès à leur site, ce qui génère des dizaines (voire plus) de sites web dans ma Search Console (voir un exemple dans l'illustration ci-dessous).

Le fait de pouvoir les regrouper par dossiers (exemples : "Sites perso", "Anciens clients", "Dossiers actuels", "Urgent", "Sites du Client X", etc.) et ouvrir ou fermer ces dossiers avec un système d'accordéons - voire gérer et trier leur ordre d'affichage - serait une vraie facilité de travail au quotidien. A noter que des travaux allant dans ce sens semblent être en cours de test chez Google.

Suivi des propriétés dans la Search Console Google. Source de l'image : Abondance |

Téléchargement des URL indexées

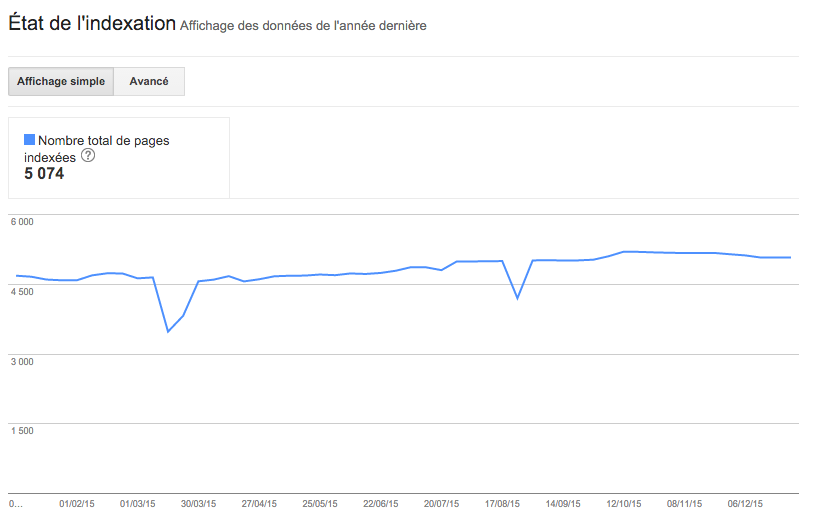

Dans la zone "Index Google > Etat de l'indexation" (voir illustration ci-dessous), un graphique donne le nombre d'URL indexées par le moteur sur les 12 derniers mois, ce qui est déjà une information très intéressante, notamment lors d'une refonte, mais pas seulement. Toute "anomalie" (croissance, baisse, voire stagnation) à ce niveau doit correspondre à une action sur le site qui doit être analysée. Malheureusement, seules les données brutes, globales, du graphique sont téléchargeables.

Il serait pourtant tellement utile de pouvoir obtenir la liste des URL indexées (ou au moins une liste exhaustive jusqu'à, par exemple, 10 000 URL minimum). Cela permettrait de vérifier que certaines URL ou groupe d'URL importantes sont indexées, mais aussi et surtout de n'indexer que le contenu de bonne qualité. Obtenir ces URL permettrait de déceler rapidement des contenus de faible qualité indexés "historiquement" ou par erreur et de les supprimer de l'index. ce qui, dans une optique Panda/ Quality Update, Phantom 3, etc., serait une excellente chose pour tout le monde !

Nombre de pages indexées sur les 12 derniers mois dans la Search Console Google. Source de l'image : Abondance |

Exhaustivité des backlinks et Indication des liens Nofollow et Désavoués

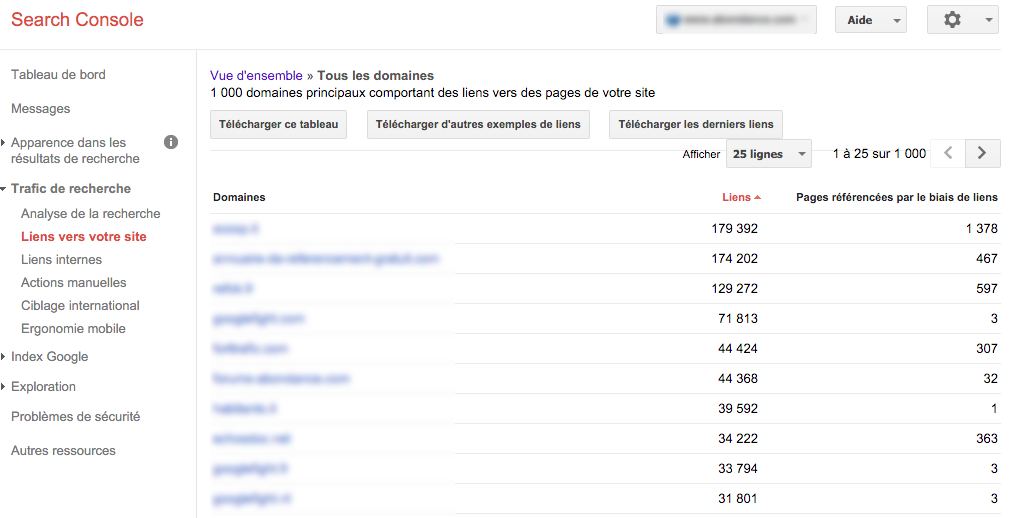

Une info logique et très souvent demandée à Google par de nombreux webmasters. Dans la zone "Trafic de recherche > Liens vers votre site" (voir illustration ci-dessous), on a à disposition une liste des sites web qui ont créé un backlink vers notre site. Un outil indispensable ! Deux améliorations pourraient être intéressantes : une plus grande exhaustivité et surtout le fait que les liens en Nofollow et désavoués soient affichés d'une façon différentes des liens réellement pris en compte par l'algorithme. Non seulement ce serait nécessaire, mais c'est presque une faute professionnelle de la part de Google de ne pas agir ainsi. Un avis largement partagé par de nombreux webmasters.

Les liens en Nofollow et désavoués pourraient tout simplement être affichés dans deux couleurs différentes par rapport aux liens "compatibles", ce qui ne demanderait pas un gros développement et donnerait de vraies indicateurs efficaces aux webmasters... Un vrai manque à l'heure actuelle...

Backlinks d'un site dans la Search Console Google. Source de l'image : Abondance |

Indication des filtres algorithmiques

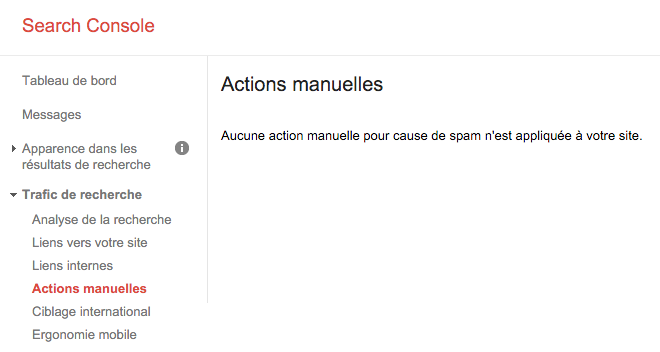

Google propose déjà , dans la zone "Trafic de recherche > Actions manuelles", des indications sur une éventuelle action/pénalité manuelle infligée au site par la Search Quality Team (voir illustration ci-dessous). Ceci est une excellente chose. Mais Google a mis en place, notamment depuis Panda en 2011, de nombreux filtres algorithmiques destinés à "pénaliser" les contenus ou les liens de faible qualité : Penguin, Payday Loan, Pirate, Page Layout ou autres EMD, sans parler des Phantom 3 ou Quality Update plus ou moins officiels.

Pourquoi ne pas intégrer dans la Search Console une sorte d'indicateurs ou d'alerte d'alarme, concernant ce type de filtre algorithmique ? Une sorte d'indicateur sur la valeur du contenu indexé ou des liens ? Bien sûr, il est normal que Google ne veuille pas communiquer sur ces filtres. Je comprends également que ce type d'indicateur pourrait rapidement être détourné ("spammons allégrement tant qu'on ne dépasse pas la ligne jaune"...). Je ne suis pas naïf... Mais n'y a-t-il pas quelque chose à faire dans ce domaine pour aider les webmasters loyaux tout en n'incitant pas au spam bourrin ? Une vraie question, mais il est clair et évident que tous ces filtres mis en place par Google sont un vrai handicap pour de nombreux sites web honnêtes qui n'ont jamais pensé un seul instant à spammer le moteur de recherche. Et Gooogle ne les aide pas du tout, à l'heure actuelle, à s'améliorer alors qu'ils ne demandent que ça... Et un site web qui s'améliore, ce sont des résultats de recherche de meilleure qualité. Tout le monde aurait à y gagner !

Indication d'une pénalité éventuelle dans la Search Console Google. Source de l'image : Abondance |

Des mises à jour plus fréquentes

Enfin, on se rend compte, quand on utilise souvent la Search Console, que certaines zones sont assez souvent mises à jour et d'autres beaucoup moins. Parfois, c'est même assez problématique. Il semblerait que cela soit dû au fait que chaque zone est gérée par des équipes d'ingénieurs différentes et que ces mises à jour dépendent de leur "bon vouloir". Pourquoi ne pas demander, pour 2016, des mises à jour quotidiennes (voire en temps réel ?) des données de TOUTES les zones d'informations. Là encore, ce serait une vraie amélioration ! Est-ce si difficile a gérer que cela ?

Merci Petit Papa Noël Google et bonne année à toi (et aux webmasters)

Bien sûr, on peut rajouter de nombreuses possibilités autour d'App Indexing et d'AMP. C'est clair mais quelque chose nous dit que c'est largement prévu pour 2016 :-). Donc on attendra tranquillement ces nouvelles fonctionnalités pour voir ce qu'il en est...

Mais une amélioration de l'existant serait également très intéressante. Alors, on fait le point dans 12 mois pour savoir ce qui a finalement été pris en compte par Google parmi les propositions ci-dessus ?

Et vous, qu'en pensez-vous ? Quelles sont les améliorations ou nouveautés que vous voudriez voir arriver en 2016 dans la Search Console en 2016 ? A vous la parole dans les commentaires !!

Personnellement ce que j’aimerais pouvoir faire c’est utiliser les données de la search console dans des rapports personnalisés sur Google Analytics ! Et un historique plus important ne serait pas non plus de refus 🙂

Idée très intéressante que cette liste de souhaits 🙂 Je te rejoint sur l’Indication des liens Nofollow et Désavoués ce serait quand même très pratique

Entièrement d’accord Olivier, tu as soulevé certains des « problèmes » de la Search Console, et il y en a certainement d’autres d’ailleurs que tu n’as pas encore exprimés ici.

Concernant la gestion des comptes, j’avoue qu’un compte CM comme pour Adwords serait bien pratique pour la Search Console, avec un système de dossiers et sous-dossiers (ou en accordeon comme tu le dis), ça changerait déjà pas mal la donne en termes d’usage courant. 😀

Hello,

je plussoie pour le regroupement de sites/propriétés par dossier, ce serait clairement pratique ainsi qu’une mise à jour plus régulière du crawl.

Autre point qui serait appréciable, est de pouvoir exporter les urls qui font un lien vers les pages en 404 depuis le rapport des erreurs d’exploration.

@ Formix : oui bien vu pour le crawl, je le note !!.

Pour le temps réel, c’était déjà proposé dans l’article.

Salut Olivier,

Je verrais bien un détail approfondi sur le crawl dans les statistiques d’exploration.

Et, pour un mastodonte qui se targue de faire du temps réel, arrêter de fournir les data à moins 3 jours c’est pénible.

voili voilou ^^