Matt Cutts a indiqué cette semaine dans un tweet qu'au cours du premier trimestre 2011, Google allait améliorer sa gestion de la détection du cloaking, technique interdite par les moteurs et permettant aux webmasters de présenter des contenus différents aux internautes et aux moteurs de recherche...

Le cloaking est une technique de référencement qui consiste à analyser quel type de visiteur arrive sur un site et à fournir un contenu différent aux internautes et aux robots des moteurs. Cette technique, condamnée par tous les moteurs (mais pourtant parfois acceptée dans certains cas), est utilisée par certains sites web, avec le risque que la manoeuvre soit détectée et que le site soit pénalisé.

Voici ce qu'en dit l'aide en ligne de Google pour les webmasters :

Exemples de "cloaking" :

* Présentation d'une page de texte HTML aux moteurs de recherche, mais affichage d'une page d'images ou Flash aux utilisateurs.

* Présentation aux moteurs de recherche d'un contenu différent de celui destiné aux utilisateurs.

Si votre site contient des éléments non explorables par les moteurs de recherche (par exemple, fichiers Rich Media autres que Flash, scripts JavaScript ou images), vous ne devez pas leur fournir de contenu masqué. Vous devez plutôt tenir compte des visiteurs qui ne peuvent pas non plus consulter ces éléments. Par exemple :

* Fournissez du texte alt décrivant les images aux visiteurs qui utilisent des lecteurs d'écrans ou qui ont désactivé les images dans leur navigateur.

* Fournissez le contenu textuel du script JavaScript dans une balise noscript.

Assurez-vous de fournir un contenu identique dans les deux éléments (par exemple, fournissez le même contenu dans le script JavaScript et la balise noscript). L'insertion de contenu en grande partie différent dans l'élément de substitution peut inciter Google à prendre des mesures en ce qui concerne le site."

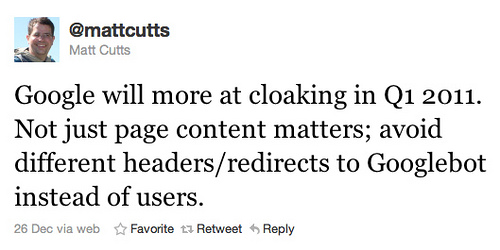

A ce sujet, Matt Cutts (porte-parole SEO du moteur de recherche) a levé un lièvre le 26 décembre dernier avec un tweet qui indiquait : "Google will more at cloaking in Q1 2011. Not just page content matters; avoid different headers/redirects to Googlebot instead of users." Ainsi, lors du premier trimestre 2011, Google utilisera plusieurs techniques pour détecter le cloaking et pénaliser certains sites qui utiliseraient ce type de technologie. Un webmaster averti en vaudra donc deux pour le début de l'année 2011...

Source de l'image : Abondance |

Plus d'infos :

- http://twitter.com/#!/mattcutts/status/19152836789014528

- http://www.google.com/support/webmasters/bin/answer.py?hl=fr&answer=66355

Source(s) :

- Google Vows To Look At Deceptive Cloaking Techniques (Search Engine Land)

Articles connexes sur ce site :

- Le cloaking, c'est quoi ? (mars 2005)

- Yahoo! et Google mettent WhenU en liste noire pour cause de cloaking (18 mai 2004)

- Problème de crawl Google chez OVH ? (18 février 2009)

- Live Search et le cloaking (6 décembre 2007)

Par exemple faire un accès via une IP inconnue des SEO et comparer ce que renvoit le site, par rapport à son accès spider 🙂

cdt

Y a quand même qu'une seule bonne façon de cloaker : sur les IPs des moteurs.

Et de ce côté là, je ne vois pas bien comment Google (ou un autre) pourra empêcher cette technique.

Bonjour,

Personnellement, je retire certains formats de pub propriétaires lorsque je détecte un robot afin de ne pas perturber le calcul de taux de clics.

Pensez-vous que cela puisse être pris pour du Cloacking ?