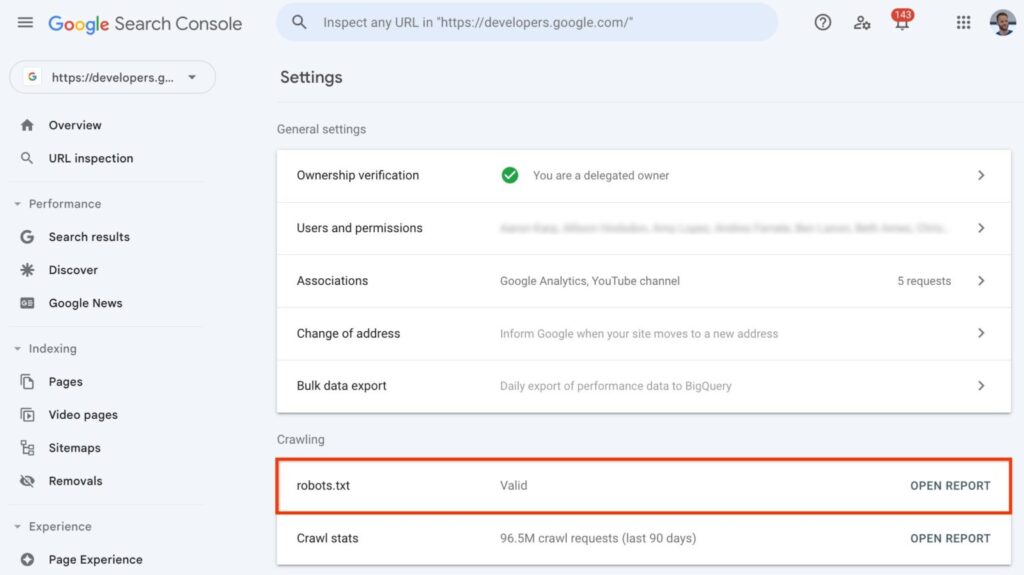

La Google Search Console introduit un nouvel outil : le rapport robots.txt. Cette innovation offre une analyse détaillée des fichiers robots.txt, essentielle pour optimiser l'indexation et le référencement des sites web.

Ce qu'il faut retenir :

- Google Search Console a lancé un rapport dédié aux fichiers robots.txt, permettant aux webmasters de mieux comprendre et gérer l'indexation de leurs sites ;

- Ce rapport fournit des informations sur les fichiers robots.txt trouvés, la date de leur dernière exploration par Google, et d'éventuelles erreurs ou avertissements ;

- Avec cette nouveauté, Google a décidé de retirer l'ancien outil de test des robots.txt.

Analyse du nouveau rapport robots.txt

Google a intégré dans sa Search Console un rapport dédié aux fichiers robots.txt. Cet outil est une avancée majeure pour les professionnels du SEO et les gestionnaires de sites web.

Il permet d'accéder à des informations détaillées sur les fichiers robots.txt, notamment quels fichiers ont été trouvés par Google, la date de leur dernière exploration, et les erreurs ou avertissements rencontrés. Google a également ajouté la possibilité de demander une nouvelle analyse d'un fichier robots.txt en cas d'urgence.

Ces fonctionnalités sont intéressantes pour diagnostiquer et résoudre les problèmes d'indexation. Elles sont d’ores et déjà disponibles dans le monde entier, alors n’hésitez pas à faire un tour dans les paramètres de votre Search Console pour vérifier l’état de vos fichiers.

Suppression du testeur robots.txt

Avec ce nouveau rapport sur la Search Console, Google a décidé de supprimer l’outil de test du fichier robots.txt. Il permettait de savoir si le fichier robots.txt empêchait les robots de Google d'explorer des URL spécifiques. Désormais, il n’a plus d’utilité. Il sera supprimé à partir du 12 décembre 2023.

Mais si on veut faire des modifications du robots.txt l’éditeur a disparu. Alors comment faire ?

Bonjour,

Je vous invite à consulter la page dédiée de Google : https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt?hl=fr

Bonne journée,

Mathilde

C’est un outil assez sympa et plutôt pratique que Google a développé.

Grâce a lui, pas mal d’informations supplémentaires pour les experts du SEO.

La Google Search Console est vraiment indispensable pour optimiser le référencement d’un site ! On attend avec impatience la nouvelle version pour, peut être découvrir encore une bonne surprise ?

Merci pour l’article !