Face à des accusations de biais dans son algorithme du système d’avis, Google se trouve au cœur d'une controverse soulignant la lutte entre grandes marques et éditeurs indépendants. Une situation complexe où la transparence et l'équité sont remises en question.

Ce qu'il faut retenir :

- Un article d’HouseFresh suggère un biais de l'algorithme de Google favorisant les avis de grandes marques, au détriment des sites indépendants ;

- Danny Sullivan ne reconnaît pas ce biais mais exprime l’engagement de Google à améliorer la diversité des résultats de recherche ;

- L'affaire met en lumière les défis pour les petits éditeurs face à la dominance des grandes marques, malgré un contenu de qualité.

Accusation par HouseFresh

Tout commence avec un article publié par HouseFresh, “Comment Google tue des sites indépendants comme le nôtre”, où l’éditeur indépendant, spécialisé en qualité de l’air, dénonce une manipulation de l’algorithme de Google par des sites d’avis, avec un moteur de recherche qui met en avant des produits malgré des évaluations moins bonnes.

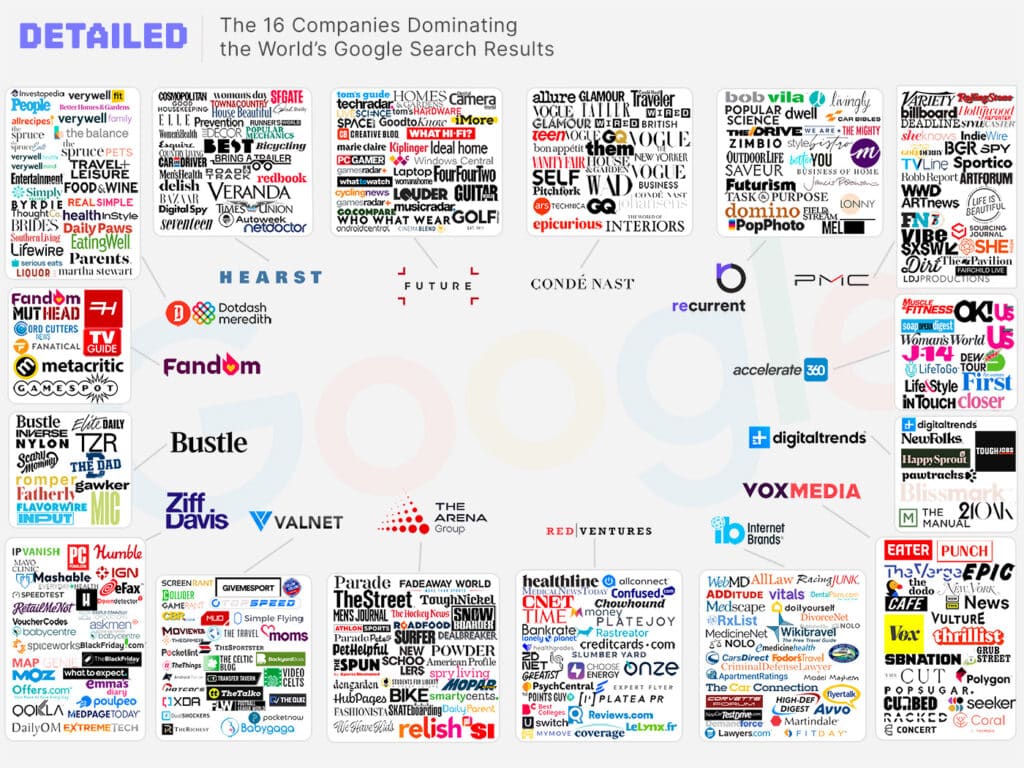

HouseFresh expose certaines pratiques douteuses, notamment l’utilisation de photos identiques par différentes marques pour un même produit ou le fait d’ajouter la mention “d’après nos tests” seulement après la Product Review Update de 2022, ce qui suggère d’après eux une absence de réel test et donc, une manipulation. L’éditeur insiste sur le fait que ce sont TOUJOURS les mêmes sites qui sont favorisés par Google :

Dans leur article, HouseFresh se focalise spécifiquement sur les avis concernant les meilleurs purificateurs d’air pour les animaux. Il se trouve que ce sont Forbes, BuzzFeed, Rolling Stone, Popular Science et Better Homes & Gardens qui ont la meilleure réponse, d’après l’algorithme de Google. Selon l’éditeur, ces grandes marques n’ont jamais testé par eux-même ces purificateurs, tout comme de nombreux produits présents sur leurs sites.

On vous recommande la lecture de cet article, car l’analyse de HouseFresh est véritablement poussée et s’appuie sur des années d’enquête pour prouver ce biais dans l’algorithme de Google. Ce qui les a poussé à la publier hier : une forte baisse de trafic sur leur site, dûe à des pertes de positions en faveur de ces médias. Cela ne va probablement rien changer au système d’avis du moteur de recherche, mais qui ne tente rien…

La réponse de Google

A la suite du tweet de HouseFresh partageant leur article, Danny Sullivan (aka SearchLiaison) a répondu, en prenant au sérieux les préoccupations de l’éditeur.

Voici sa réponse :

"Merci. J'ai apprécié la réflexion du post, les préoccupations et le détail qu'il contient. Je l'ai transmis à notre équipe de recherche avec mes réflexions, souhaitant que nous fassions plus pour assurer une meilleure diversité de résultats incluant à la fois petites et grandes publications.

Un commentaire sur cet excellent article : il suggère que nous faisons une sorte de vérification manuelle sur les affirmations faites par les pages. Ce n'est pas le cas. Cette référence concernant les examens que nous effectuons si une page fait l’objet d’une action manuelle de spam à son encontre et dépose une demande de réexamen. C’est différent de la façon dont nos systèmes de classement automatisés récompensent le contenu.

Par ailleurs, le simple fait de faire une réclamation et parler d’un processus de test rigoureux et suivre une checklist EEAT ne garantit pas un meilleur classement ni une amélioration de la page. C’est un concept qui s’aligne à la façon dont nous essayons de positionner les bons contenus, mais nos systèmes ne considèrent pas qu’une page est meilleure simplement parce qu’elle contient une affirmation disant “J’ai testé ça”. (...)

Merci encore pour l’article. J'espère que nous ferons mieux à l'avenir pour ce type de problèmes."

Thank you. I appreciated the thoughtfulness of the post, and the concerns and the detail in it. I've passed it along to our Search team along with my thoughts that I'd like to see us do more to ensure we're showing a better diversity of results that does include both small and…

— Google SearchLiaison (@searchliaison) February 20, 2024

Et donc ?

Cette controverse met en évidence l'importance pour les éditeurs de se concentrer sur la création de contenu utile et pertinent pour leur audience. Google insiste sur le fait que son algorithme vise à récompenser le contenu qui sert généralement les besoins des utilisateurs, en utilisant différents signaux, plutôt que des affirmations spécifiques de tests. Et bien sûr, sans vérification manuelle de la véracité de ces affirmations - il s’agit bien d’un système automatisé.

Il est donc difficile d’imaginer une amélioration à ce niveau-là : comment un robot pourrait-il définir si un site ment sur ses tests, et être certain qu’un autre dit la vérité ? Seulement par rapport à sa taille ? Est-ce que privilégier uniquement les sites indépendants ne serait pas un autre biais de l’algorithme ? Une des solutions serait peut-être de mettre davantage en avant les sites thématiques (HouseFresh étant véritablement spécialisé dans la qualité de l’air, contrairement à ses concurrents de SERP). Quel est votre avis sur cette question épineuse ?

J’ai cette réflexion depuis bien des années. Comme quand Matt Cuts disait nettoyer la SERP avec 1 résultat par site…