Sponsorisé par Semdatabase

Le SEO est aujourd’hui confronté à une mutation profonde. Les pages de résultats de Google ne se contentent plus d’afficher dix liens bleus : elles agrègent désormais une multitude de formats, souvent interactifs, qui fragmentent l’attention de l’internaute. Résultats sponsorisés, extraits enrichis, blocs de questions, carrousels, cartes, modules locaux… la SERP est devenue un espace algorithmique à forte densité concurrentielle.

Dans ce nouvel environnement, le positionnement dans les résultats ne suffit plus à garantir la visibilité. Un lien bien classé peut être décalé visuellement ou contextuellement, perdant en attractivité ou en accessibilité. Pour faire face à cette complexité, les professionnels du secteur doivent se doter d’outils capables de restituer une image fidèle de la réalité des SERPs, et surtout, de leur lecture par les utilisateurs. Cela implique de passer à une logique de données avancées, capables de modéliser des environnements instables, dynamiques et parfois très différenciés selon les thématiques.

Ce qu'il faut retenir :

- La SERP est devenue complexe et concurrentielle, avec une multitude de formats qui brouillent la visibilité réelle.

- Le Big Data rend le SEO plus stratégique, en révélant tendances, comportements et opportunités à grande échelle.

- Les positions classiques ne suffisent pas toujours, la visibilité réelle dépend du contexte (format, placement, scroll…).

- Les bases de données de SERPs fournissent des informations clés, fraîches et enrichies, pour mieux piloter sa stratégie SEO.

Le SEO à l’ère des données massives : enjeux et bénéfices

Les arbitrages SEO ne peuvent plus se baser uniquement sur des métriques classiques ou des impressions subjectives. À mesure que la compétition s’intensifie, la capacité à détecter des signaux faibles, à décrypter des configurations récurrentes de SERPs ou à anticiper l’évolution de certaines niches devient déterminante.

L’analyse à grande échelle, rendue possible par le Big Data, offre plusieurs bénéfices :

- Une lecture plus fiable des dynamiques de visibilité, à travers des volumétries représentatives de mots-clés et d’univers sectoriels variés.

- Une priorisation affinée des requêtes, fondée sur la structure réelle des résultats et non plus sur la seule position.

- Une compréhension accrue du comportement de Google dans des contextes spécifiques (intention de recherche, typologie d’appareil, sémantique dominante…).

En somme, le Big Data transforme l’intuition en modèle, et le test manuel en analyse systématique. Mais pour que cette puissance soit réellement exploitable, encore faut-il avoir accès à des bases de données continuellement mis à jour, bien structurés, et reflétant la diversité des scénarios rencontrés en SEO !

Compléter les données SEO classiques

Les outils traditionnels de suivi fournissent une lecture utile, mais souvent partielle, du positionnement d’un site. En se focalisant généralement sur une position numérique (1, 2, 3…) qui ne rend pas forcément toujours compte de la position réellement perçue ni du contexte dans lequel cette position s’inscrit.

Par exemple, deux résultats situés 3e position peuvent avoir des performances de clic radicalement différentes si l’un est visible dès l’ouverture de la page, tandis que l’autre est masqué par plusieurs blocs en haut de page. Ce type d’écart passe inaperçu dans les tableaux standards, mais peut être mis en évidence par une analyse enrichie de la SERP.

C’est là que les approches permises par le Big Data prennent le relais : elles permettent de restituer la hiérarchie réelle des éléments visibles, de qualifier l’environnement du résultat (formats voisins, densité concurrentielle, présence de modules Google), et donc de mieux expliquer les performances constatées en termes de trafic ou d’engagement.

Ce que le Big Data appliquée aux SERPs peut vraiment apporter

Une analyse approfondie des pages de résultats permet de produire des indicateurs jusque-là difficilement accessibles avec les outils de tracking classiques. Parmi ceux-ci :

- La position pixel, estimée à partir de la position réelle du résultat sur la page (en pixel). Cette mesure donne accès à une cartographie plus fiable du potentiel d’un mot-clé en conditions de navigation réelles.

- L’analyse de la structure native des SERPs, en tenant compte de la segmentation naturelle des pages (pagination, scroll, blocs de contenu). Cela permet de distinguer les requêtes qui valorisent le top 3… de celles où l’attention se disperse sur plusieurs pages.

- L’actualisation fréquente des données, qui garantit une meilleure réactivité dans le pilotage des actions SEO et réduit le risque de décisions fondées sur des informations obsolètes.

- La capacité à agréger des tendances sectorielles ou concurrentielles, en observant à grande échelle les comportements de Google sur un corpus thématique défini.

Ces éléments, lorsqu’ils sont croisés avec d’autres KPIs (CTR, conversion, prix, etc.), permettent d’alimenter une réflexion stratégique plus poussée, notamment dans des secteurs fortement concurrentiels ou volatils.

Cas d’usage : comment les SEO peuvent exploiter ces données aujourd’hui

L’exploitation des données massives issues des SERPs ouvre de nouveaux champs d’analyse et d’action aux experts. Parmi les applications les plus concrètes, on retrouve :

- Mesure de la performance réelle d’un site dans Google, en combinant les positions nominales et les métriques de visibilité graphique pour mieux corréler classement et trafic.

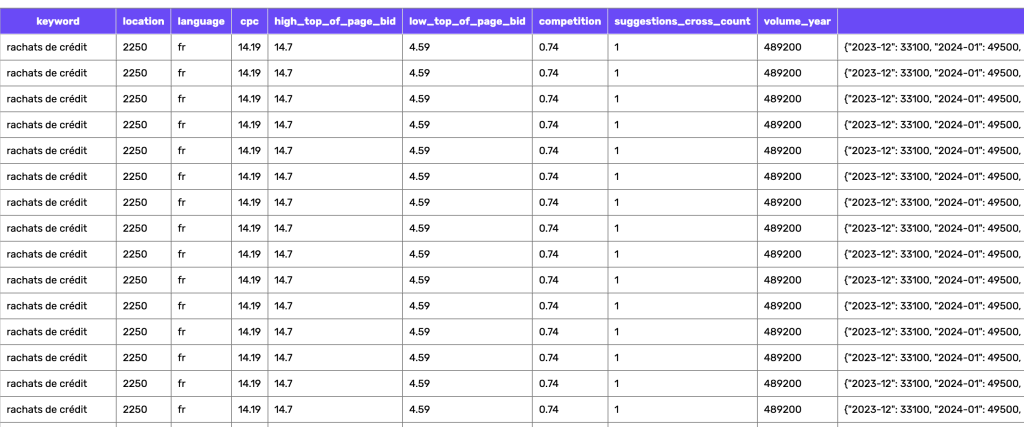

- Sélection avancée de mots-clés, en filtrant non seulement par volume ou difficulté, mais aussi par visibilité projetée, selon la configuration dominante des résultats.

- Analyse stratégique des concurrents, en identifiant les marques ou éditeurs les plus récurrents sur un ensemble de requêtes et en évaluant leur couverture selon différents formats.

- Optimisation du contenu éditorial, basée sur l’observation des types de résultats les plus fréquemment mis en avant par Google pour un thème donné.

- Entraînement d’algorithmes prédictifs, en utilisant des bases de SERPs réelles pour nourrir des modèles d’IA destinés au scoring de contenu, au clustering thématique ou à la simulation de performance SEO.

Vers un SEO plus intelligent, piloté par les données

Le recours au Big Data dans le domaine du SEO ne relève plus de la recherche expérimentale : c’est une évolution logique face à la sophistication croissante des moteurs de recherche. En s’appuyant sur des bases solides, représentatives, et actualisées, les professionnels peuvent ajuster leurs décisions à la réalité terrain, tout en gagnant en précision et en efficacité.

Des solutions comme Semdatabase permettent justement d’accéder à ces ressources stratégiques, en mettant à disposition des millions de SERPs analysées selon une méthodologie rigoureuse. L’objectif n’est pas seulement de suivre sa visibilité, mais de la comprendre dans toutes ses dimensions pour agir avec un temps d’avance sur la concurrence !