Google remplace la chaîne « parole → texte → recherche » par un modèle qui recherche directement depuis la voix, sans transcription intermédiaire, pour des réponses plus rapides et plus fidèles à l’intention, déjà déployé dans plusieurs langues. Sous le capot, Google relie la requête parlée aux contenus les plus pertinents et laisse son système de classement faire le tri final, tout en s’appuyant sur un jeu de tests ouvert (SVQ) pour évaluer les progrès réels et comparables dans le temps. Explications.

Ce qu'il faut retenir :

- S2R court-circuite l’ASR : la requête parlée est convertie en vecteur sémantique et mise en correspondance directe avec les documents, réduisant les erreurs de transcription.

- Les performances dépassent le cascade ASR et flirtent avec le “ground truth” idéal sur MRR, signe d’un saut qualitatif concret en pertinence.

- Le système est live, en plusieurs langues, avec un ranking qui combine similarité sémantique et centaines de signaux de qualité.

- Google publie le dataset SVQ (17 langues, 26 locales) au sein du benchmark MSEB pour faire progresser l’écosystème.

Pourquoi Google change tout maintenant

Jusqu’à maintenant, la chaîne « Cascade ASR » (Automatic Speech Recognition) convertissait d’abord l’audio en texte, puis lançait une recherche classique, mais la moindre erreur (ex. « scream » au lieu de « screen ») déviait l’intention et les résultats, un problème structurel d’erreur de transcription et de perte de contexte. S2R (Speech-to-Retrieval) pose une autre question : non plus « quels mots ont été prononcés ? », mais « quelle information est recherchée ? », ce qui diminue fortement la propagation des erreurs.

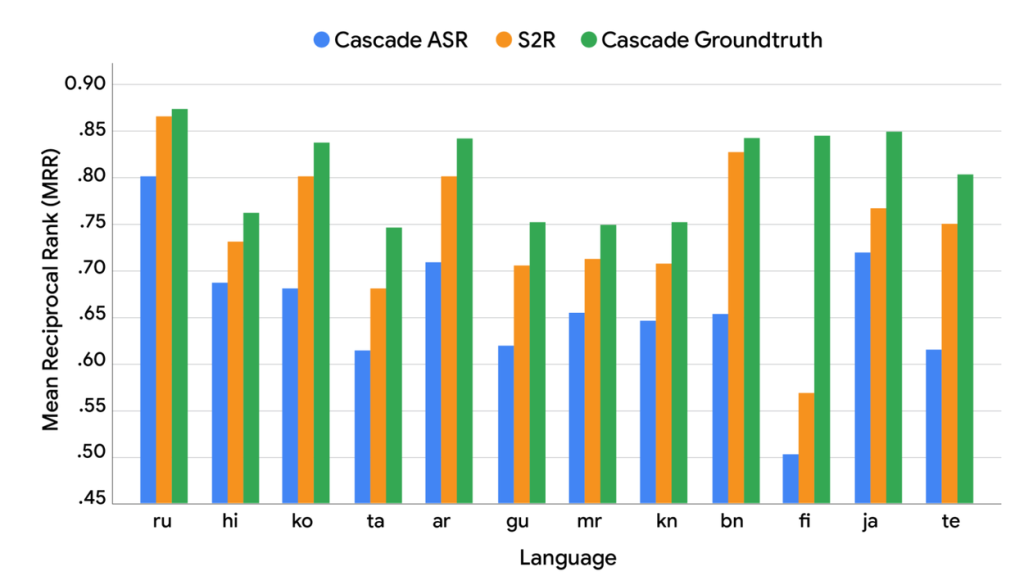

Au-delà des exemples, Google a comparé un système réel Cascade ASR avec un « Cascade groundtruth » (transcriptions humaines parfaites) et a observé un écart substantiel en MRR (Mean Reciprocal Rank), montrant que même un ASR parfait ne garantit pas la meilleure pertinence, d’où l’intérêt d’optimiser directement pour l’intention de recherche. Cette observation a motivé l’architecture S2R et l’évaluation dédiée.

Comment fonctionne S2R ?

Le cœur de S2R est un dual-encoder : un encodeur audio transforme la requête vocale en embedding riche, et un encodeur de documents projette les pages dans le même espace sémantique, pour rapprocher les paires audio-document pertinentes et éloigner les autres. L’objectif d’entraînement aligne géométriquement les vecteurs audio avec leurs documents cibles.

En production, l’embedding audio sert à récupérer rapidement des candidats proches dans l’index, puis un étage de ranking orchestre la position finale en combinant la similarité et des centaines de signaux de qualité de Search. Cette intégration conserve la vitesse perçue tout en maximisant la pertinence finale.

Les résultats : mieux que l’ASR, proche du plafond

Sur le dataset SVQ (Simple Voice Questions), S2R surpasse nettement le Cascade ASR et se rapproche du « upper bound » du Cascade Groundtruth en MRR, montrant des gains robustes multi-langues. Google souligne toutefois un petit écart résiduel, laissant un espace d’amélioration future et de recherche.

Point clé révélé par les tests : une baisse de WER (Word Error Rate) ne se traduit pas mécaniquement par une hausse de MRR, car l’impact des erreurs dépend du type d’erreur et de la langue. Optimiser la compréhension d’intention directement depuis l’audio est donc plus pertinent pour la recherche. Cette dissociation WER/MRR justifie l’approche S2R orientée intention.

Ce qui change pour l’expérience utilisateur

- Moins de mauvaises interprétations sur des requêtes ambiguës, bruitées ou avec variations d’énoncés (« montre-moi le tableau qui crie de Munch » mène correctement à « The Scream »). La robustesse vient de la similarité sémantique plutôt que du mot-clé exact.

- Des réponses plus rapides, car on évite une étape fragile et coûteuse de transcription parfaite avant la récupération et le ranking, tout en conservant l’infrastructure de classement éprouvée. L’utilisateur perçoit une pertinence plus « intelligente » et un temps de réponse stable.

- Multilingue dès le départ : le modèle sert déjà plusieurs langues, ce qui bénéficie aux requêtes non anglaises et aux contextes où l’ASR étaint historiquement en peine. Cette portée reflète l’entraînement et l’évaluation multi-locales de SVQ.

Impacts SEO et marketing à anticiper

- Passage de « matching lexical » à « matching sémantique audio→doc » : l’optimisation s’appuie encore plus sur la clarté d’intention des contenus, leur structure, leur autorité et leur capacité à répondre précisément à des formulations variées. Le signal d’intention domine les mots exacts.

- Importance accrue des signaux de qualité du ranking final : E‑E‑A‑T, UX, fraîcheur et signaux techniques restent déterminants, car S2R alimente le rappel sémantique, puis le ranking agrège des centaines de signaux pour ordonner les résultats. Le socle de qualité reste non négociable.

- Multilingue et bruit : produire des contenus clairs, contextuels, avec désambiguïsation interne (glossaires, FAQ, entités) peut aider le modèle à « coller » l’intention audio aux réponses, notamment dans des marchés à forte variabilité linguistique. La cohérence sémantique paie davantage.

Le rôle de SVQ et de MSEB

Google a ouvert le dataset Simple Voice Questions (SVQ) sur Hugging Face (plateforme open source dédiée à l'IA) : courtes questions audio, 17 langues, 26 locales, dans des conditions audio variées (propre, bruit de fond, trafic, médias), pour une évaluation standardisée. SVQ s’inscrit dans le Massive Sound Embedding Benchmark (MSEB).

Cet effort vise à stimuler la recherche ouverte sur l’alignement audio→documents et à comparer les approches au-delà des métriques d’ASR classiques. Pour l’écosystème, cela balise un cadre de mesure plus pertinent de la pertinence réelle côté utilisateur.

Exemple concret : « the scream painting »

Avec le cascade ASR, une confusion « scream » → « screen » mène à des résultats hors sujet ; S2R projette la requête parlée dans un espace où « The Scream » est proche du Munch Museum ou de Wikipédia, puis le ranking trie selon qualité et pertinence. L’intention dépasse la littéralité des mots.

Cet exemple illustre une propriété clé : la capacité du modèle à tolérer paraphrases et imprécisions de prononciation tout en aboutissant aux bons documents, grâce à l’alignement sémantique audio↔texte et au classement multi-signal. C’est la promesse tangible de S2R.

Limites et prochaines étapes

En somme, le modèle se rapproche du plafond « groundtruth ». Il reste donc du travail pour mieux aligner précisément l’audio et les documents, mieux gérer le mélange de langues dans une même requête (code‑switching) et rester robuste dans des environnements très bruyants. Google laisse entendre que ce gap est une opportunité de R&D ciblée.

Côté produit, la question de l’UX (historique, affichage d’une paraphrase texte de la requête, contrôle utilisateur) peut évoluer, mais le cœur « retrieval+ranking » est déjà en production et améliore la fiabilité perçue. L’itération continue devrait resserrer l’écart.