Google travaillerait actuellement à un nouveau critère de pertinence, basé sur l'analyse de la véracité des faits relatés dans une page web, comparée à un référentiel de type Knowledge Graph...

On apprend cette semaine par un article de la revue New Scientist que des chercheurs de Google ont publié une étude (PDF) intitulée "Knowledge-Based Trust: Estimating the Trustworthiness of Web Sources" (attention, solides connaissances en mathématiques conseillées pour la lire).

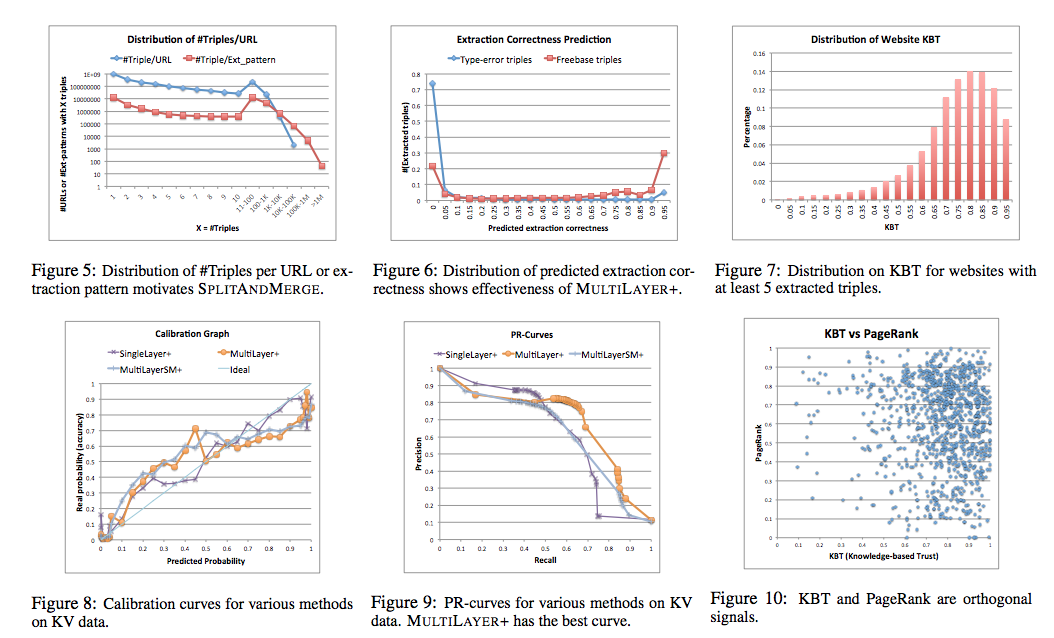

Cette étude montre comment il serait possible d'analyser et de classer des résultats en estimant la pertinence de leur contenu (et notamment le fait que les informations qui y sont fournies sont vraies ou fausses) et sans obligatoirement se baser sur le traitement des liens entrants, comme le fait Google aujourd'hui. Une source d'information qui proposerait des contenus erronés perdrait ainsi de la confiance envers le moteur, alors qu'un site web ayant "tout juste" monterait en termes de KBT (Knowledge-Based Trust, ou confiance basée sur la connaissance). L'idée serait de comparer les contenus identifiés sur le Web avec une base de connaissance (Knowledge Graph ou son futur Knowledge Vault). L'analyse d'une page et, de façon plus globale, du site entier, pourraient donner des indications sur le niveau de confiance que le moteur peut avoir envers une source d'informations. Une approche finalement pas si éloignée que cela du fonctionnement actuel de Google...

Bien sûr, ce système ne pourrait pas s'adapter au web dans son ensemble car toutes les pages ne contiennent pas des "faits" pouvant être comparés à un référentiel donné, mais l'approche est séduisante et pourrait venir en complément des critères actuels. Reste à envisager la façon dont le référentiel serait bâti et qui détiendrait la "vérité suprême" et comment elle serait établie. Une vraie question de fond...

Source de l'image : Google |

je pense pas que c’est vraie !! le poids des liens restes tjr un grand facteur pour le moteur de recherche et le référencement naturel 🙂

Bonsoir,

Je pense que ce n’est pas tout à fait le but de Google. Il ne triera pas le contenu faux du vrai, trop compliqué, imaginez doctissimo et même Wikipédia ? (Qui sont souvent remplis d’erreur).

Mais plus pour détecter les textes sans intérêt et sans queue ni tête. Les spins crados ou autre contenu générés automatiquement pour placer du lien …

Ce n’est qu’une pensée comme une autre, mais je le vois plutôt comme ça !

Car après tout, il arrive que certains résultats de Google soient faux selon la question posée … A méditer !

Amitiés, Yann.

Bonjour à tous,

L’idée serait peut être vraie dans les sciences exactes où un consensus scientifique est déjà fondé. Encore faut-il que à soit dans l’absolu (information pure et parfaite). Mais si l’on introduit de la relativité dans ces mêmes « postulats, connaissances, méthodes …etc.) établies, la théorie de Google serait un leurre. Dieu sait combien d’écoles ou de « vérités » existent bien même dans les sciences exactes ! Si tous les chemins mènent à Rome, lequel choisirait Google ? Sans doute celui du « big boss » avec qui il a des « relations sentimentales ». Du coup la pensée unique l’emportera effectivement et la qualité même si cher a Google sera altérée et biaisée.

Je pense donc que Google, n’étant pas bête je l’espère, choisira la « relativité » et usera d’un catalogue d’informations et de connaissances diversifié pour « factualiser » et « rationnaliser » son référentiel pour mettre un peu de démocratie dans ses SERPs.

Il sera donc laborieux de construire ce référentiel qui ne sera jamais parfait ni exhaustif ! Cette contrainte majeure contraindrait google à cibler l’usage de ce « nouveau facteur de confiance et de pertinence ». Il sera sans doute possible de l’utiliser pour certaines données structurées comme les dates de grands événements historiques, ou des événements tout court (sportifs, électoraux, …), pour des dates de naissance de personnalités, leurs noms et prénoms, des lieux …etc. Je pense que ça représentera moins de 1% dans l’ensemble (comme d’habitude !).

Par ailleurs, une autre piste est possible mais sera certaiment subjective et toujours incomplète : le référentiel fera un scoring sur le maximum de pages qui parleraient du même sujet. Dès alors, un certain niveau de « score d’exactitude » définira la vérité et constituera l’indice de référence.

Encore faut-il que la définition du sujet soit clairement établie ! S’agira-t-il d’un sujet global, d’une thématique ? Ou d’un micro-sujet ? Les chaussures e les souliers seront-ils considérés comme même et unique sujet ou proches ou différents ou totalement différents ?

Je vais méditer en attendant le futur du présent.

Je me suis fait la même réflexion en lisant l’étude.

Il suffirait qu’un journaliste émérite se trompe dans une information. Information bêtement reprise un peu partout, et qui finirait pas se retrouver dans la base de connaissance de Google, c’est à dire inscrite dans le marbre. Là, un petit blogueur, qui connait bien le sujet, se fend d’un chouette article où il tente de rectifier le truc. Eh bien ! Le pauvre blogueur a pas fini de ramer pour voir son site apparaitre sur la première page si l’info est erronée selon le Knowledge Graph/Vault.

Par ailleurs, certains sujets, politiques, sociétaux, religieux ou liés à la santé sont loin de faire consensus. Comment Google entend-il répondre aux requêtes d’internautes qui font des requêtes sur ces sujets ? Quels sites leur présenter ? Un panel représentatif des diverses opinions sur le sujet ou un classement des sites représentatifs de l’opinion dominante ?

Bref, l’idée de base est louable mais j’ai du mal à voir en quoi elle serait si pertinente que cela, finalement.

C’est le Gorafi qui va monter dans les SERP alors ! 🙂

Ah ah ah énorme ! Oui, le contenu pertinent bouilli sémantique devrait faire l’affaire. Histoire de corser la chose, on rajoute un peu de schema.org et tout ce qui peut plaire à GG en matière de web Objet et on se place en top de ligne de flottaison ^_^

Enfin… ceci dit Xavier n’a pas tord, pourquoi le contenu non pertinent mais bien rédiger ne ferait pas place à certaine bouilli journalistique ^^

La pensée unique a de beaux jour devant elle…

Comment Google va déterminer qu’une info est plus authentique qu’une autre ? Il va partir de la fabuleuse formule « plus on en parle, plus il y a de chance que ce soit vrais ? » J’ai comme des doutes …

@ Greg : c’est certainement l’une des voies visées par ce système, effectivement…

Le jour ou Google sera capable de déterminer si un site présente une information erronnée ou non, il sera également vraissemblablement en mesure de proposer directement la réponse à la question proposée par l’internaute. On risque de voir apparaitre de plus en plus d’answer box…