Jusqu'à maintenant, le spider Googlebot utilisait une version 41 de Chrome pour sa phase de "Rendering". Une nouvelle mouture basée sur la V69 serait en phase finale de test. Les sites complexes pourraient donc bientôt être mieux explorés...

Selon le site Deep Crawl, Google serait en train de tester de façon approfondie une nouvelle version de son robot Googlebot, capable de crawler des sites plus modernes, utilisant des techniques plus élaborées, notamment autour du langage Javascript.

En effet, jusqu'à maintenant, Googlebot utilisait pour sa phase de "rendering" une version 41 de Chrome (soit sa version de 2015 environ), ce qui cumulait un certain retard, presque 4 ans plus tard. Selon DeepCrawl, le crawler en test actuellement serait basée sur la version 69 de Chrome (septembre 2018).

Ce travail n'était d'ailleurs pas confidentiel puisque le googler Martin Splitt en avait parlé en novembre dernier, et avait confirmé l'information au salon SMX Munich début avril.

Il semble donc que ce ne soit désormais plus qu'une question de date d'annonce après la finalisation des derniers tests. Et on peut penser que bientôt, l'objectif ultime sera d'effectuer la phase de "rendering" avec la version courante du navigateur Chrome, et non plus avec quelques mois (ou versions) de retard.

En revanche, ne perdons pas de vue que la mise en place du rendering sur un site très complexe peut parfois prendre beaucoup de temps, comme le signalait Gary Illyes l'année dernière.

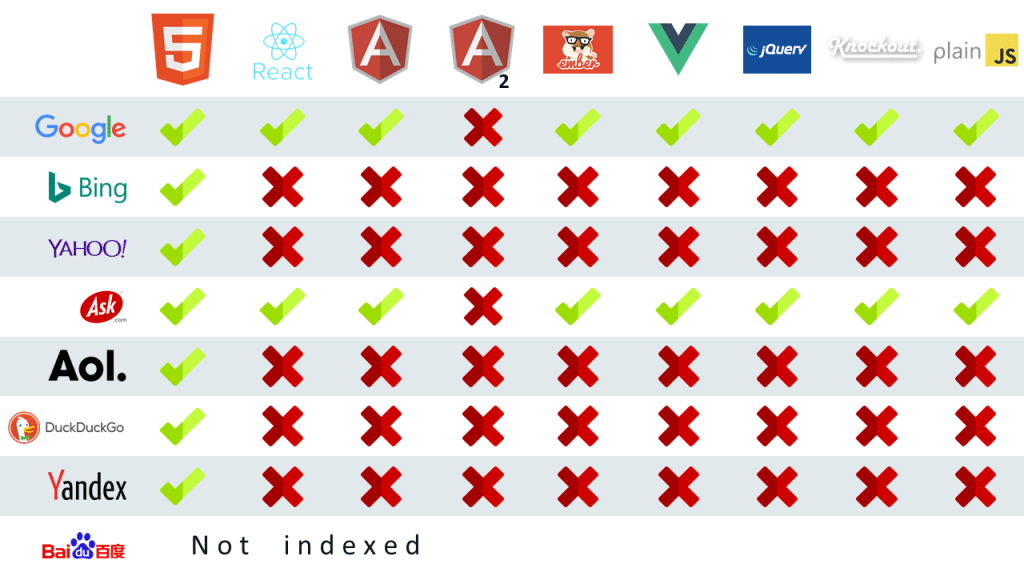

Résultat : si votre site utilise des technologies dites "modernes" (exemple : site 100% JS, voir illustration ci-dessous), il y a des chances pour qu'il soit très prochainement beaucoup mieux crawlé par les robots du moteur. Si votre site est "classique", vous ne devriez en revanche pas voir de différences…

Bonjour,

À propos du Google Bot, je me demande si les service de ping sont toujours efficaces pour demander l’indexation de pages externes ? (pour que Google prenne rapidement en compte un backlink par exemple).