Des documents internes de Google Search ont été divulgués par une source anonyme qui a appelé Rand Fishkin, le fondateur de SparkToro et ex-fondateur de Moz. Ils révèlent des informations cruciales sur le fonctionnement de l'algorithme de son moteur de recherche.

Ce qu'il faut retenir :

- Les clics et les comportements post-clics sont des facteurs de classement très importants ;

- NavBoost, un système de re-ranking basé sur les clics, influence directement le classement ;

- Google intègre les données de clics issues de Chrome ;

- Les clics permettent de pondérer les liens dans les SERP en classant les pages sur 3 niveaux ;

- Google applique des listes blanches pour des requêtes sensibles.

Les fuites internes de Google Search

Le 5 mai 2024, Rand Fishkin reçoit un email d'une source (qui a tenu à rester anonyme) affirmant posséder des milliers de documents internes provenant de l’équipe de recherche de Google. La source affirme que ces documents ont été confirmés comme authentiques par d’anciens employés de Google, qui ont partagé des informations supplémentaires.

Ces documents révèlent des pratiques internes de Google qui contredisent ses déclarations publiques, notamment l'utilisation des signaux de clics. Nous allons les développer ci-dessous, mais voilà quelques affirmations de la source de Rand Fishkin :

- Le système appelé NavBoost a initialement collecté des données à partir du PageRank de la barre d'outils de Google, et le souhait d'obtenir davantage de données sur le parcours de navigation a été la principale motivation pour créer le navigateur Chrome ;

- NavBoost utilise le nombre de recherches pour un mot-clé donné pour identifier la demande de recherche tendance, le nombre de clics sur un résultat de recherche, et les clics longs par rapport aux clics courts ;

- NavBoost évalue les requêtes en fonction de l'intention de l'utilisateur. Par exemple, certains seuils d'attention et clics sur des vidéos ou des images déclencheront des fonctionnalités de vidéo ou d'image pour cette requête et les requêtes associées associées à NavBoost ;

- Google examine les clics et l'engagement sur les recherches pendant et après la requête principale (appelée “requête NavBoost”). Par exemple, si de nombreux utilisateurs recherchent “Rand Fishkin”, ne trouvent pas SparkToro et modifient immédiatement leur requête en “SparkToro” puis cliquent sur le site de SparkToro, le site et les sites web le mentionnant recevront un coup de pouce dans les résultats de recherche pour le mot-clé “Rand Fishkin” ;

- D'autres facteurs mineurs tels que les pénalités pour les noms de domaine qui correspondent exactement aux requêtes de recherche sans marque (par exemple hommes-luxe-montres.com), un nouveau score “BabyPanda” et les signaux de spam sont également pris en compte lors de l'évaluation de la qualité ;

- NavBoost délimite géographiquement les données de clics, en tenant compte des pays et des états, ainsi que l’utilisation d’appareils mobiles par rapport aux ordinateurs ;

- Pendant la pandémie de Covid-19, Google a utilisé des listes blanches pour les sites Web susceptibles de figurer en bonne place dans les résultats de recherches liées au Covid et lors des élections, pour afficher ou rétrograder des sites.

Certaines de ces informations, notamment celles sur NavBoost, ont déjà été révélées lors du procès anti-trust de Google.

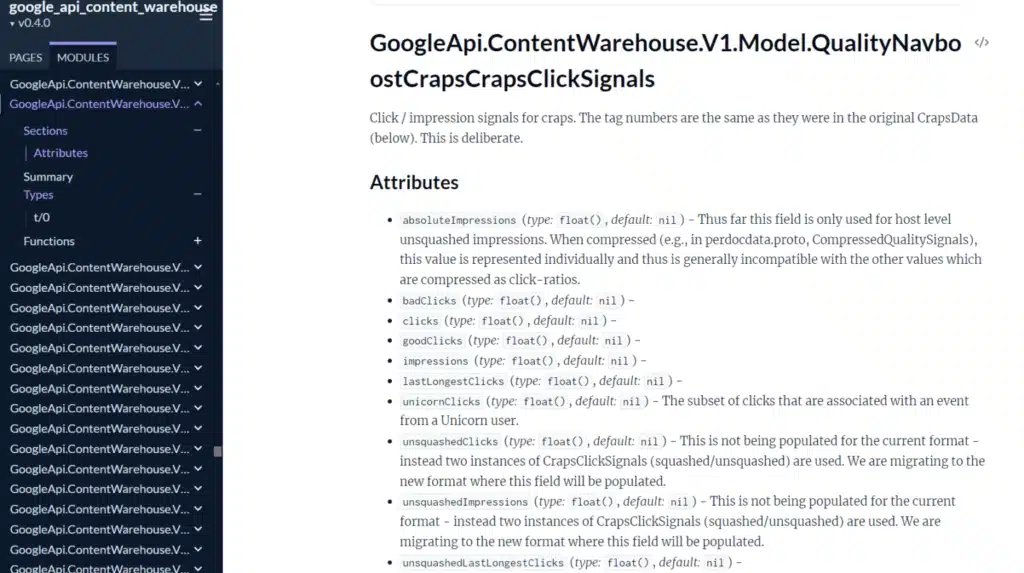

Une capture d’écran de Rand Fishkin des données divulguées sur les bons et les mauvais clics, dont la durée des clics (temps passé sur une page avant de revenir sur la SERP)

Si Rand Fishkin était, au départ, sceptique, il a pu s’entretenir avec la source en visioconférence qui lui a montré directement la fuite de documents : plus de 2500 pages de documentation semblant provenir du “Content API Warehouse” interne de Google. Le code a été téléchargé sur GitHub le 27 mars 2024 puis supprimé le 7 mai 2024.

Par précaution, Rand a contacté plusieurs amis ex-Googlers et Mike King, le fondateur d’iPullRank. Ce dernier a confirmé qu’il semblait bien s’agir de documents légitimes provenant de l’équipe de recherche de Google.

NavBoost : utilisation des clics et des données utilisateurs

NavBoost est un système de Google mentionné pour la première fois dans les témoignages du département de la justice des Etat-Unis par Pandu Nayak, vice-président de la recherche chez Google.

NavBoost a été développé pour améliorer la qualité des résultats de recherche et identifier les tendances en utilisant des données de clics. Ce système a commencé à collecter des données à partir de la barre d'outils PageRank de Google et plus tard de Chrome, dont la création a été motivée par le besoin accru de données de clics.

NavBoost recueille une variété de données de clics, notamment :

- Le nombre de clics sur un résultat de recherche : Les clics sur un résultat de recherche sont utilisés pour déterminer la popularité et la pertinence de ce résultat.

- Les clics longs versus les clics courts : NavBoost fait la distinction entre les clics longs (où l'utilisateur passe beaucoup de temps sur la page) et les clics courts (où l'utilisateur revient rapidement à la page de résultats), ce qui aide à évaluer la satisfaction de l'utilisateur.

- Les clics "écrasés" VS "non écrasés" : Les clics écrasés sont ceux que Google considère comme moins fiables ou pertinents, tandis que les clics non écrasés sont ceux qui sont considérés comme de haute qualité.

NavBoost délimite géographiquement les données de clics, prenant en compte les niveaux de pays et états, segmentées par régions géographiques pour affiner la pertinence des résultats de recherche et l’utilisation mobile VS desktop.

Les données de Chrome

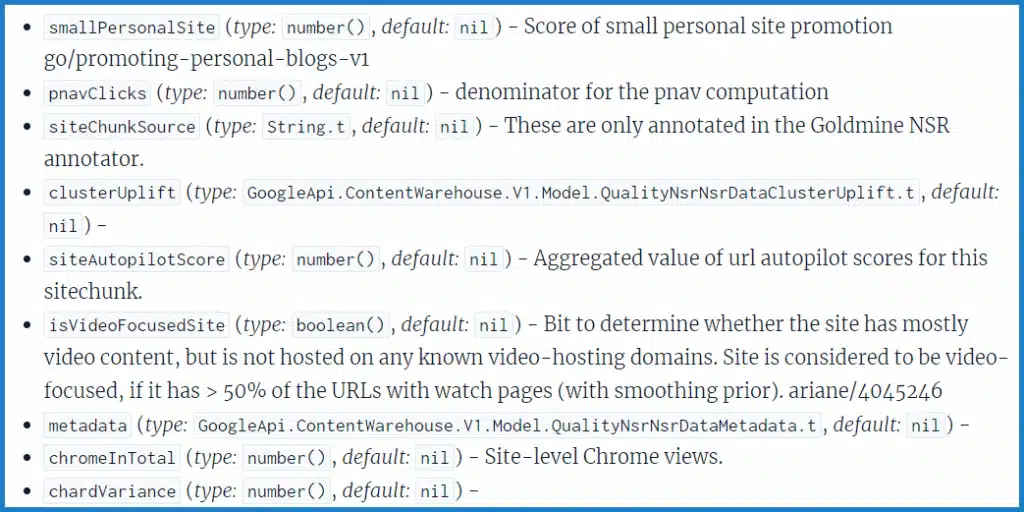

Contrairement aux déclarations publiques de Google, les documents internes montrent que Google utilise les flux de clics du navigateur Chrome pour améliorer ses résultats de recherche. Les sites sont évalués non seulement par leur contenu, mais aussi par leur autorité globale, un concept que Google a nié utiliser publiquement.

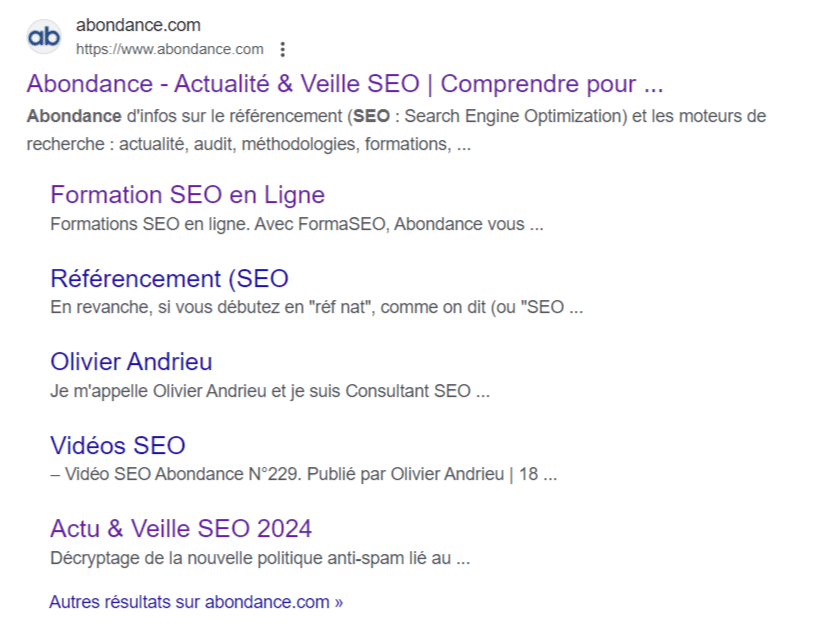

Un des documents décrit les fonctionnalités liées à la façon dont Google crée des sitelinks. Il présente un appel, “topUrl”, qui est une liste des principes URL avec le plus haut two_level_score : chrome_trans_clicks. Visiblement, Google utilise le nombre de clics sur les pages des navigateurs Chrome et l’utilise pour déterminer les URL les plus populaires sur un site et qui sont incluses dans la fonctionnalité des sitelinks.

Pondération des liens dans les SERP

D’après la source anonyme, Google dispose de 3 niveaux pour classer ses index de liens : qualité faible, moyenne, élevée. Les données de clic sont utilisées pour déterminer à quel niveau d’index un document appartient. Par exemple :

Si forbes.com/cats n’a aucun clic, il entre dans l’index de mauvaise qualité et le lien est ignoré.

Si forbes.com/dogs a un volume élevé de clics provenant d’appareils vérifiables (cf les données liées à Chrome), la page entre dans l’index de qualité élevée.

Une fois le lien considéré comme fiable, il peut diffuser le PageRank. Les liens provenant de l’index de mauvaise qualité seront simplement ignorés sans nuire au classement d’un site.

Les listes blanches et les filtres de qualité

Google applique des “listes blanches” pour certains secteurs sensibles, comme les sites de voyage, les autorités locales pendant la pandémie de COVID-19, et les informations liées aux élections. Ces filtres de qualité visent visiblement à garantir que les résultats de recherche pour ces sujets soient fiables et non controversés, pour éviter toute propagande pouvant générer des conflits.

On pourrait se demander ce que font les sites de voyage dans les secteurs sensibles, mais il existe bien un module sur les sites de voyage “de bonne qualité”.

Quality Raters, EEAT et authorship

Certains éléments des Quality Raters sont bien utilisés dans les systèmes de recherche. Google dispose d’une plateforme d’évaluation de la qualité appelée EWOK, citée dans un des documents. On apprend que les scores et données générées par les Quality Raters peuvent être directement utilisés dans le système de recherche de Google.

L’EEAT semblerait ne pas avoir l’importance que l’on peut penser. L’expertise est mentionnée une fois mais pas les autres aspects. La puissance des signaux EEAT reste donc encore en suspens… En revanche, la fuite laisse penser que Google est capable d’identifier les auteurs de contenu et les traiter comme des entités dans son système. Renforcer son influence en tant qu’auteur pourrait donc conduire à des avantages en matière de classement sur Google.

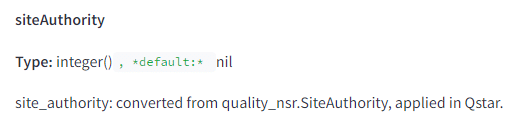

Autorité de domaine

Google a déclaré à plusieurs reprises qu’ils n’utilisaient pas l’autorité de domaine comme facteur de classement.

Visiblement, ils utilisent bien une fonctionnalité appelée “SiteAuthority” (et non pas Domain Authority mais à part une différence de nom...), utilisée dans le système de classement Qstar. On ne sait néanmoins pas comment cette mesure est calculée, donc cela ne correspond pas forcément aux modes de calcul des outils SEO qui proposent une note d'autorité de domaine.

Sandbox

Les portes-paroles de Google ont toujours insisté sur le fait qu'il n'existe pas de “sandbox” (bac à sable) dans lequel les sites sont séparés en fonction de leur âge ou du manque de signaux de confiance. Mais le document “PerDocData” met en avant un attribut nommé “hostAge”, utilisé spécifiquement pour les nouveaux domaines. Le positionnement de nouveaux sites sur des mots-clés concurrentiels serait donc bien limité.

Importance des liens

Les liens restent importants pour le classement, en tout cas rien ne remet cela en question dans les 2 500 documents. Google utilise plusieurs mesures pour évaluer leur qualité :

- Impact du niveau d'indexation : La valeur des liens est influencée par le niveau d'indexation des pages sources.

- Signaux de pics de spam de liens : Google peut détecter les pics de spam dans les ancres de liens.

- Dernières 20 versions : Google n'utilise que les 20 dernières versions d'une URL pour analyser les liens.

- PageRank de la page d'accueil : Le PageRank de la page d'accueil est pris en compte pour toutes les pages du site.

- Confiance de la page d'accueil : La confiance accordée à la page d'accueil influence la valeur des liens.

- Taille de police : Google prend en compte la taille de la police des mots et des liens dans les pages.

- Penguin et liens internes : Certains liens internes peuvent ne pas être pris en compte selon les critères du système Penguin.

Dégradations algorithmiques

Il y a plusieurs types de dégradations algorithmiques mentionnées dans les différents documents :

- Mauvaise correspondance des ancres : Dégradation lorsque le lien ne correspond pas au site cible.

- Dégradation basée sur la SERP : Indicateur de dégradation basé sur des facteurs observés dans la SERP, suggérant une insatisfaction potentielle des utilisateurs.

- Dégradation de navigation : Dégradation appliquée aux pages avec de mauvaises pratiques de navigation ou des problèmes d'expérience utilisateur.

- Dégradation des exact match domains : Les domaines correspondant exactement aux requêtes ne reçoivent plus autant de valeur qu'auparavant.

- Dégradation des avis sur les produits : Liée à la mise à jour récente des avis sur les produits.

- Dégradations de localisation : Les pages globales peuvent être dégradées en faveur des pages locales.

- Dégradations pour contenu adulte : Dégradation des contenus pour adultes.

Longueur des pages

Google limite le nombre de tokens pris en compte pour un document dans le système Mustang. Les auteurs devraient donc placer les contenus les plus importants au début de leurs contenus, même si on ne sait pas combien de tokens sont considérés.

Importance des dates

Google utilise plusieurs méthodes pour déterminer la date d’un contenu, y compris les dates extraites de l’URL, du titre et du contenu de la page : bylineDate, syntacticDate, semanticDate. Soyez cohérent dans les dates de vos pages pour éviter une baisse de performances.

Baby Panda

Il existe des références à quelque chose appelé "Baby Panda" dans les signaux de qualité, qui pourrait correspondre à la mise à jour du contenu utile. Baby Panda est un Twiddler, une fonction de reranking utilisée après le classement initial. Il semble fonctionner en complément de Panda, mais les détails spécifiques sur son fonctionnement ne sont pas fournis dans la documentation.

Your Money Your Life

Google utilise des classificateurs pour générer des scores spécifiques pour YMYL Santé et YMYL News. Ils prédisent également si des requêtes nouvelles ou peu fréquentes sont considérées comme YMYL. Ces scores influencent le classement des pages traitant de sujets sensibles où la qualité de l'information est indispensable.

Merci pour cette veille et cette synthèse.

Des critères officieux sont désormais officiels.

Restent à connaitre leur pondération dans l’algorithme de ranking et s’ils sont encore utilisés.