Sponsorisé par Topirank

L’essor fulgurant des intelligences artificielles génératives bouleverse notre rapport à l’information. De plus en plus d’internautes ne tapent plus leurs requêtes dans la barre de recherche de Google, mais les formulent directement auprès d’agents conversationnels comme ChatGPT, Perplexity ou Claude. Résultat : la façon dont les contenus sont découverts et transmis évolue rapidement, et les entreprises doivent repenser leurs stratégies SEO en conséquence. Face à ce nouveau paradigme, le cocon sémantique revient sur le devant de la scène. Mais cette fois, il ne s’agit plus seulement de plaire à Google, il faut aussi nourrir les IA !

Cocon sémantique : un pilier toujours solide du SEO

Le principe du cocon sémantique repose sur la structuration logique et hiérarchisée du contenu d’un site autour d’un champ lexical donné. Concrètement, cela revient à créer un maillage interne cohérent entre des pages traitant d’un même sujet, mais selon différentes angles ou niveaux de profondeur. L’objectif est ici de répondre à toutes les intentions de recherche en lien avec un thème central, tout en facilitant la compréhension des robots d’indexation.

Cette méthode, toujours d’actualité dans les SERP classiques, a pour effet d’augmenter la pertinence perçue d’un site sur une thématique, d’améliorer le taux de clics, de prolonger la durée des sessions utilisateur et de booster le positionnement naturel des pages. Mais ce qui faisait déjà sa force hier se révèle aujourd’hui encore plus importante face au développement des IA génératives.

L’explosion de la longue traîne : effet collatéral des LLMs

Les modèles de langage comme ceux développés par OpenAI, Anthropic ou Google (avec Gemini) n’interprètent pas les requêtes de la même manière qu’un moteur de recherche traditionnel. Là où un moteur de recherche classique décompose une intention en mots-clés optimisés, un LLM traite une phrase dans sa globalité, en s’appuyant sur des milliards d’exemples issus du langage humain.

Cela pousse les utilisateurs à formuler leurs requêtes sous forme de questions complexes, naturelles, contextuelles, ce qu’on pourrait appeler longue traîne conversationnelle.

En voici quelques exemples :

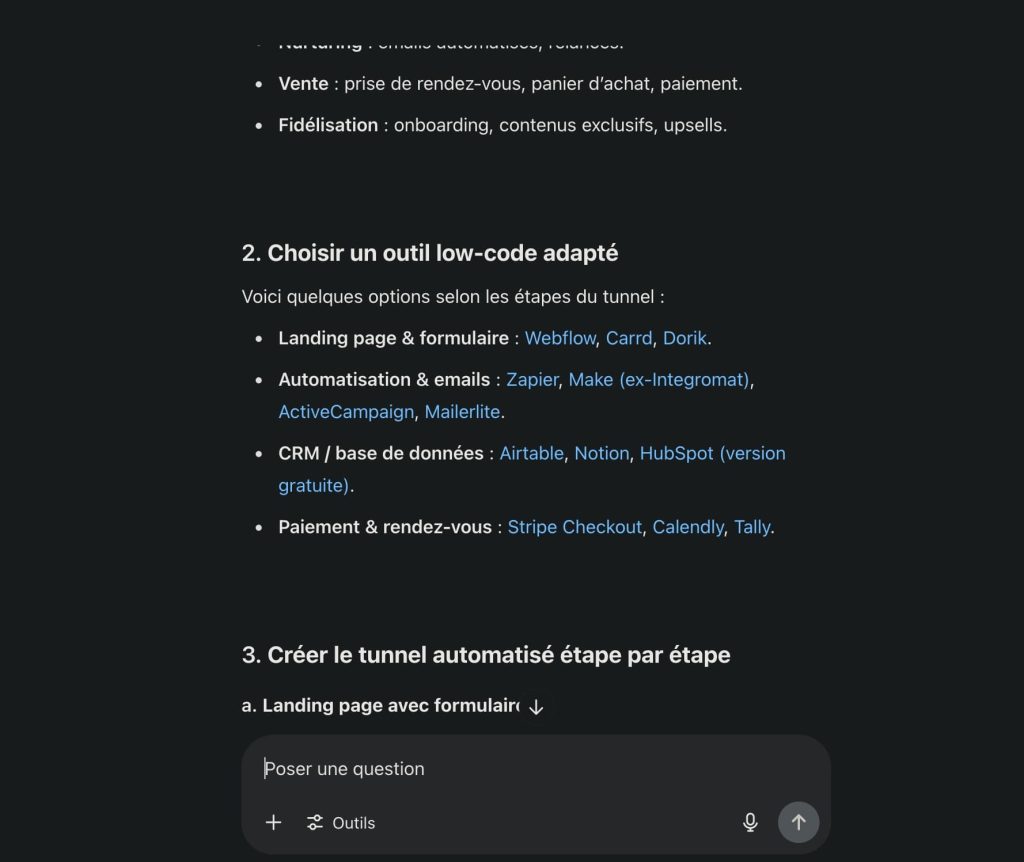

- « Comment automatiser un tunnel de vente avec un outil low-code ? »

- « Quelle est la différence entre un contrat freelance et un contrat en portage salarial pour un développeur web ? »

- « Quelle est la meilleure période pour réserver un vol pour le Japon en partant de Paris ? »

Concevoir une simple page optimisée sur des expressions comme « tunnel de vente », « freelance vs portage » ou « voyager au Japon » ne suffit plus. Il faut décomposer chaque thématique en micro-sujets et y répondre précisément. Le cocon sémantique devient alors une réponse structurelle à la complexité croissante des intentions des utilisateurs.

Être visible dans les réponses IA : un enjeu qui dépasse le site web

Une des grandes spécificités des LLMs, c’est qu’ils ne s’appuient pas seulement sur les pages indexées comme Google le fait. Ils se basent sur une grande typologie de contenus publiquement accessibles sur le web. Blogs, forums, articles académiques, documentation, articles invités, sites de niche : tous ces contenus peuvent servir de matière première pour la génération de réponses.

Conséquence directe : pour maximiser ses chances d’être cité (explicitement ou non) dans une réponse d’IA, il est judicieux d’élargir son cocon sémantique au-delà de son propre site. Publier des contenus thématiquement alignés sur d’autres plateformes, dans des formats adaptés (FAQ, tutoriels, Q&A, glossaires, synthèses…), permet en effet de nourrir un champ lexical plus large et de s’ancrer dans l’écosystème de données du LLM.

Ce principe est d’autant plus stratégique que les IA citent de plus en plus leurs sources. Être mentionné directement dans une réponse sur Perplexity ou Bing Copilot, c’est gagner en crédibilité, en trafic et en autorité.

Adapter son cocon aux attentes des intelligences artificielles

Si le cocon reste un outil pertinent, encore faut-il l’adapter aux nouvelles logiques des modèles de langage. Ceux-ci privilégient la clarté, la structure, la densité informationnelle et la formulation pédagogique.

Voici quelques leviers d’optimisation concrets :

- Segmenter les contenus en sous-pages ultra-thématiques, avec titres explicites (Hn bien structurés), intro synthétique, développement clair.

- Multiplier les formats utiles aux LLMs : encadrés FAQ, listes à puces, définitions, citations… Tous ces éléments sont facilement exploitables par un modèle de langage.

- Travailler le champ lexical connexe plutôt que de répéter à outrance un mot-clé. Les IA comprennent les synonymes, les périphrases, les cooccurrences.

- Employer un ton naturel et conversationnel, qui colle mieux aux usages des utilisateurs et aux réponses générées.

- Exploiter les données structurées (schema.org), notamment les blocs « HowTo », « FAQ », « Article », qui favorisent l’indexation sémantique.

En somme, il ne suffit plus d’être pertinent pour Google. Il faut devenir intelligible pour une IA générative, ce qui impose une rigueur nouvelle dans la conception des contenus.

Études de cas et stratégies gagnantes

Certaines entreprises ont déjà pris le virage de cette hybridation SEO / IA. Prenons l’exemple d’un site SaaS spécialisé dans la gestion de projets. En créant un cocon sémantique autour des méthodes agiles (Scrum, Kanban, Sprint planning, backlog…), avec des articles courts, précis, bien reliés entre eux, un site spécialisé peut réussir à faire apparaître plusieurs de ses pages dans des réponses de ChatGPT et Perplexity, notamment sur des requêtes très spécifiques comme « Comment organiser un sprint de deux semaines avec Trello ? ».

Autre cas : un cabinet RH qui développe un cocon sémantique autour de la reconversion professionnelle dans le secteur public. Il publie à la fois sur son blog, mais aussi sur Medium, LinkedIn et des sites partenaires. Résultat : son contenu est fréquemment repris par des IA en réponse à des questions comme « Quelles sont les options de reconversion après 45 ans dans la fonction publique ? ».

Dans les deux cas, le dénominateur commun est clair : une couverture exhaustive et bien structurée d’un champ lexical précis, alliée à une diffusion multi-plateformes.

Vers une nouvelle discipline : le GEO ?

Le SEO tel que nous le connaissions évolue rapidement. Face à des IA capables de répondre sans renvoyer vers des pages, les éditeurs de contenu doivent réinventer leur stratégie de visibilité. Ce mouvement donne naissance à un nouveau champ : le GEO, LLMO ou AEO… C’est-à-dire, une discipline visant à améliorer sa visibilité dans les agents conversationnels et IA génératives.

Dans ce contexte, le cocon sémantique redevient un outil de choix, non plus seulement pour séduire les algorithmes de Google, mais pour « éduquer » les IA, influencer leurs réponses, et se rendre visible dans un web en pleine transformation !