L'intelligence artificielle franchit une nouvelle étape vers l'autonomie réelle. Google Cloud vient d'officialiser le support du Model Context Protocol (MCP) pour une vaste gamme de ses services, allant de Google Maps à BigQuery en passant par Google Kubernetes Engine (GKE). Souvent comparé à un "USB-C pour l'IA", ce protocole standardisé permet désormais aux développeurs de connecter facilement leurs agents intelligents aux infrastructures de Google, sans avoir à gérer des serveurs locaux complexes. En somme : Une avancée qui promet de débrider le potentiel des agents autonomes en entreprise.

Ce qu'il faut retenir :

- Standardisation massive : Google intègre le protocole MCP à ses API existantes, offrant un accès unifié et géré ("fully-managed") à ses services sans nécessiter de serveurs locaux fragiles.

- Connexion aux données réelles : Les agents peuvent désormais interagir nativement avec Google Maps (données géospatiales), BigQuery (analyse de données d'entreprise) et l'infrastructure cloud (GCE, GKE) pour exécuter des tâches complexes.

- Sécurité et gouvernance : L'intégration inclut des garde-fous robustes via Google Cloud IAM et Model Armor pour prévenir les menaces comme les injections de prompt indirectes.

- Extension à l'entreprise : Via Apigee, les entreprises peuvent exposer leurs propres API internes comme des "outils" découvrables pour les agents IA.

La fin des intégrations "bricolées"

Jusqu'à présent, connecter un agent IA (comme Gemini ou Claude) à des données externes ou des outils nécessitait souvent un travail d'ingénierie assez lourd. Les développeurs devaient construire, héberger et maintenir leurs propres serveurs intermédiaires pour faire le pont entre le modèle et l'outil. C'était coûteux et techniquement fragile.

Avec cette annonce du 11 décembre 2025, Google change la donne. Au lieu de demander aux développeurs de créer ces ponts, Google a mis à jour son infrastructure API pour qu'elle "parle" nativement le langage MCP. Concrètement, cela signifie qu'un développeur peut pointer son agent IA (qu'il tourne sous Gemini 3 ou un autre client MCP) directement vers un endpoint Google fiable et sécurisé.

Comme le soulignent Michael Bachman et Anna Berenberg de Google Cloud, pour qu'une IA soit véritablement un "agent", elle ne doit pas seulement être intelligente ; elle doit pouvoir manipuler des outils et des données de manière fiable.

Les premiers services compatibles : de la carte au cloud

Google déploie ce support par vagues, mais les premiers services intégrés couvrent déjà des besoins critiques :

1. L'ancrage dans le monde réel avec Google Maps

Grâce à Maps Grounding Lite, les agents IA accèdent à des données géospatiales fraîches. Fini les hallucinations sur les temps de trajet ou l'existence de lieux fermés. Un agent peut désormais répondre avec précision à des questions logistiques complexes comme "Quelle est la distance entre le parc le plus proche et cette location ?" ou planifier des itinéraires en tenant compte de la météo, le tout via une connexion standardisée.

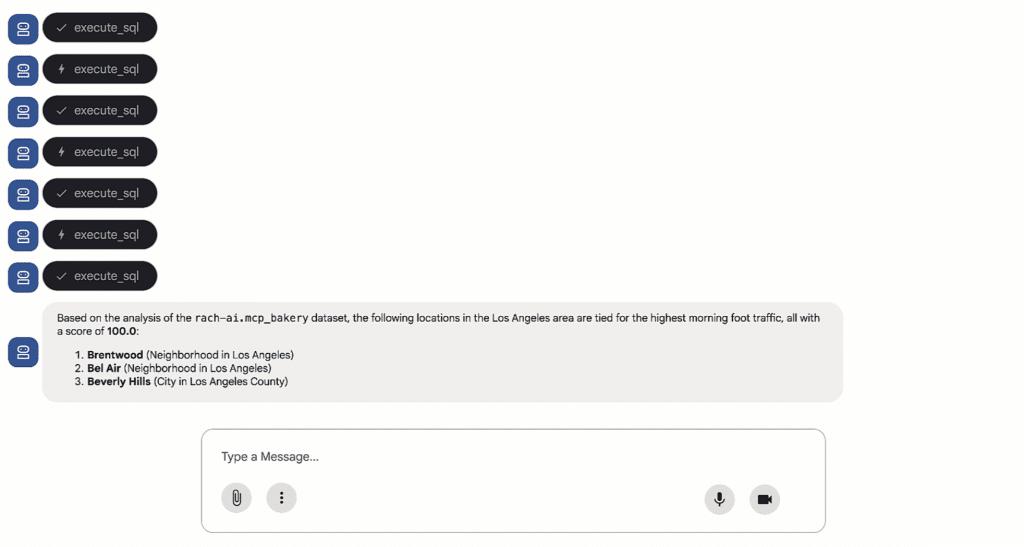

2. L'analyse de données avec BigQuery

C'est un atout majeur pour les entreprises. Le serveur MCP pour BigQuery permet aux agents de comprendre la structure des bases de données (schémas) et d'exécuter des requêtes SQL directement. L'avantage est double : on évite de copier des données sensibles dans la fenêtre contextuelle du modèle (ce qui est risqué et coûteux) et on permet à l'agent d'utiliser des fonctions avancées de BigQuery, comme les prévisions (forecasting).

3. Le pilotage d'infrastructure (GCE et GKE)

L'IA devient un administrateur système autonome.

- Sur Google Compute Engine (GCE), les agents peuvent provisionner ou redimensionner des machines virtuelles selon la demande.

- Sur Google Kubernetes Engine (GKE), l'interface MCP structure les interactions avec les clusters. L'agent ne se contente plus de lire du texte brut en sortie de console ; il interagit proprement avec l'API Kubernetes pour diagnostiquer des pannes ou optimiser les coûts, sous supervision humaine ou en autonomie.

Apigee : le pont vers vos propres données

L'annonce va plus loin que les seuls services Google. En intégrant MCP à Apigee, Google permet aux entreprises de transformer leur propre stack technique en outils pour l'IA.

Vos API internes, celles qui gèrent vos stocks, vos clients ou vos processus métiers spécifiques, peuvent être exposées et gouvernées comme des outils MCP. Elles deviennent "découvrables" par les agents, permettant de créer des flux de travail hybrides qui mélangent la puissance de calcul de Google et votre logique métier propriétaire.

Sécurité et futur de l'écosystème

L'un des principaux freins à l'adoption des agents autonomes reste la sécurité. Google répond à cette inquiétude en enveloppant ces serveurs MCP de ses couches de sécurité habituelles. L'accès est géré par Cloud IAM (gestion des identités), l'observabilité est assurée par des journaux d'audit (audit logging), et Model Armor protège contre les nouvelles menaces spécifiques aux LLM, comme les injections via des données tierces.

L'objectif est clair : construire un écosystème où les modèles, qu'il s'agisse de Gemini 3 ou d'autres, peuvent s'épanouir. D'ailleurs, Google annonce déjà la suite. Dans les mois à venir, le support MCP s'étendra à Cloud Run, Cloud Storage, Spanner, Cloud SQL et même aux outils de sécurité (SecOps).

En tant que membre fondateur de l'Agentic AI Foundation aux côtés d'Anthropic, Google confirme ici sa volonté de ne pas seulement fournir les modèles les plus intelligents, mais surtout l'infrastructure la plus robuste pour les faire travailler.