Google ne lit pas vos pages en entier pour générer ses réponses IA, même si elles font 3 000 mots. Les travaux de Dan Petrovic montrent l’existence d’un budget de grounding d’environ 2 000 mots par requête, réparti entre quelques sources seulement, avec un avantage net pour les pages les mieux classées. Ce qui change tout pour la stratégie de contenu : la densité d’information compte davantage que la longueur.

Ce qu'il faut retenir :

- Google dispose d’un budget d’environ 2 000 mots de grounding par requête, partagé entre 3 à 5 sources principales.

- La position dans le classement détermine la part de ce budget : la source #1 reçoit environ deux fois plus de texte que la #5.

- Au niveau d’une page, la sélection plafonne aux alentours de 540 mots ; au-delà de 1 500–2 000 mots, les gains sont marginaux.

- Les pages concises et très ciblées obtiennent un taux de couverture bien supérieur aux pavés de 4 000 mots : densité > longueur.

D’où viennent les chiffres ?

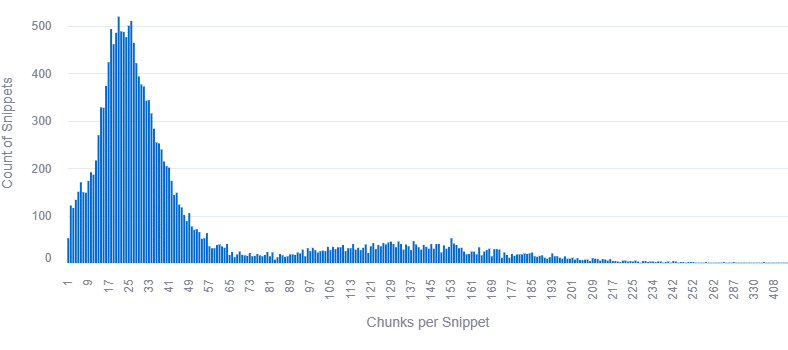

Dan Petrovic a analysé un large corpus de requêtes réelles pour comprendre comment Google alimente ses systèmes Gemini en contenu issu du web. L’étude porte sur 7 060 requêtes comptant au moins trois sources, comparant les extraits de grounding réellement envoyés au modèle avec le contenu complet de 2 275 pages tokenisées.

Le jeu de données comprend 883 262 extraits (snippets), avec une moyenne de 15,5 mots par chunk, et une statistique détaillée des longueurs de chunks (mots, caractères, mots par chunk). Pour observer le grounding, Dan n’essaie pas de « deviner » les extraits : il regarde les segments exacts fournis au modèle comme contexte avant génération, ce qui permet une correspondance précise avec le texte source.

Le budget de grounding : environ 2 000 mots par requête

Premier constat majeur : chaque requête semble disposer d’un budget de grounding total d’environ 2 000 mots, quelle que soit la longueur des pages sources. Les percentiles de mots totaux par requête se situent ainsi : p25 = 1 546, médiane = 1 929, p75 = 2 325, p95 = 2 798.

Ce budget est remarquablement stable : ajouter plus de sources ne multiplie pas le volume de texte total envoyé à l’IA, il est simplement redistribué entre davantage de documents. Dan précise que ces 2 000 mots correspondent à une médiane, avec quelques cas extrêmes allant jusqu’à environ 5 000 mots et un échantillon autour de 30 000 mots qu’il soupçonne d’être un bug dans sa pipeline.

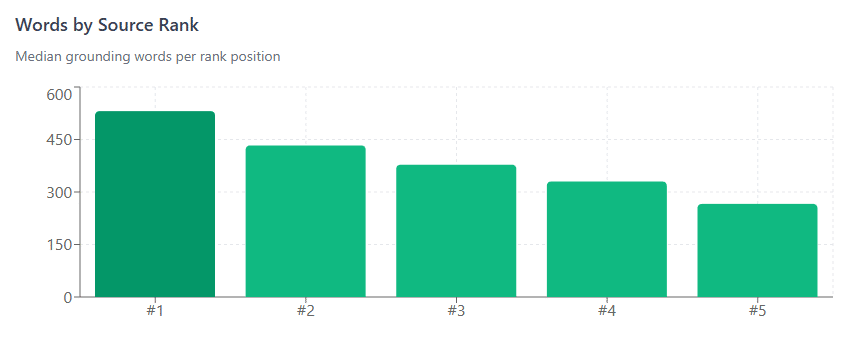

Comment Google répartit ce budget entre les sources ?

L’étude montre que la variable déterminante est le rang de la source dans les résultats de recherche, et non la longueur du contenu. Le budget global est partagé selon la position dans les SERPs, avec la répartition médiane suivante :

- Rang #1 : 531 mots, soit 28 % du budget total

- Rang #2 : 433 mots, soit 23 %

- Rang #3 : 378 mots, soit 20 %

- Rang #4 : 330 mots, soit 17 %

- Rang #5 : 266 mots, soit 13 %

Être en #1 vous donne donc environ deux fois plus de texte de grounding qu’une page en #5 : vous vous battez pour une part fixe d’un « gâteau » de 2 000 mots, vous ne l’agrandissez pas. Autrement dit, même un contenu très long ne récupérera pas plus de place si sa position est médiocre, tandis qu’un contenu plus court, mais mieux classé, aura plus de texte sélectionné.

Ce que Google prend réellement sur une page

Au niveau d’une page individuelle, l’étude regarde la distribution des mots et caractères effectivement sélectionnés pour le grounding.

Les principaux percentiles sont :

- Médiane : 377 mots / 2 427 caractères

- p75 : 491 mots / 3 182 caractères

- p90 : 605 mots / 3 863 caractères

- p95 : 648 mots / 4 202 caractères

- Max : 1 769 mots / 11 541 caractères

En pratique, 77 % des pages voient entre 200 et 600 mots sélectionnés, la « page typique » se situant autour de 377 mots utilisés dans le contexte de l’IA. On observe un plateau autour de 540 mots et 3 500 caractères : au-delà, ajouter du texte ne fait pas augmenter le volume réellement pris en compte par Gemini.

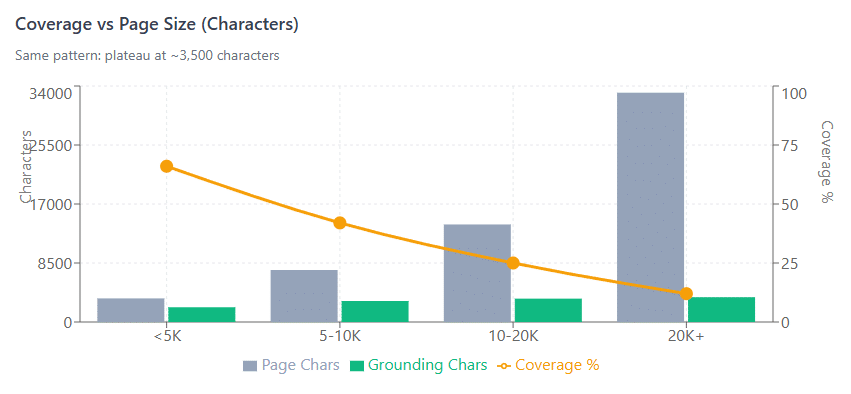

Couverture et taille de page : pourquoi les longs contenus s’essoufflent

L’un des résultats les plus parlants est la chute de la couverture (proportion de la page utilisée) à mesure que la taille de la page augmente. Dan compare la longueur de la page (en mots et en caractères) au volume de grounding effectif, puis calcule un taux de couverture.

En mots :

- < 1 000 mots : 370 mots pris en moyenne, soit 61 % de couverture

- 1 000–2 000 mots : 492 mots, 35 % de couverture

- 2 000–3 000 mots : 532 mots, 22 % de couverture

- 3 000+ mots : 544 mots, 13 % de couverture

En caractères :

- < 5 000 caractères : 2 127 caractères pris, 66 % de couverture

- 5 000–10 000 caractères : 3 024 caractères, 42 %

- 10 000–20 000 caractères : 3 363 caractères, 25 %

- 20 000+ caractères : 3 574 caractères, 12 %

On voit clairement que le volume de grounding plafonne autour de 540 mots / 3 500 caractères, tandis que la longueur des pages continue de grimper. Cela crée des rendements décroissants : au-delà d’environ 1 500–2 000 mots, chaque paragraphe supplémentaire réduit la proportion de votre page réellement visible par l’IA, sans augmenter la quantité absolue de texte sélectionné.

Critiques méthodologiques et réponses de Dan Petrovic

Dans un échange sur LinkedIn, Rohit Singh soulève plusieurs critiques importantes sur la méthodologie : absence de partage du dataset, questions sur la sélection des requêtes, la méthode de matching des « grounding words » et l’absence de tests de significativité statistique. Il met en avant quatre points : choix des 7 060 requêtes, méthode de correspondance entre extraits de grounding et texte source, absence de contrôle des variables de confusion (autorité, fraîcheur, structure), et manque d’intervalles de confiance pour le fameux budget de 2 000 mots.

Dan répond point par point :

- Les requêtes proviennent de plusieurs clients dans des secteurs variés (santé, voyage, finance, marketing, sports, B2B, marketplace, gambling, etc.), à partir d’entités primaires étendues en un grand nombre de prompts, chacun déclenchant un appel d’API de grounding.

- Les extraits observés sont exactement ceux fournis au modèle (approche extractive, sans matching flou), mais il reconnaît ne pas avoir contrôlé les variables de confusion ni réalisé d’analyses statistiques avancées sur le budget, en soulignant que ~2 000 mots correspond à une médiane et que certains outliers sont probablement des bugs.

- Dan explique enfin qu’il ne peut pas publier le dataset pour deux raisons : données clients et un second motif qu’il ne peut pas révéler sans dévoiler des informations sensibles sur son dispositif. Cela signifie que, même si les résultats sont techniquement solides et cohérents avec d’autres observations en AI SEO, ils ne sont pas indépendamment vérifiables dans l’état.

Ce que cela change pour la stratégie de contenu

L’implication principale est simple à formuler : dans le contexte de l’IA Search, la densité d’information bat la longueur brute.

Quelques conséquences pratiques :

- Mieux vaut une page très ciblée de 800–1 500 mots, optimisée pour une intention précise, qu’un pavé de 4 000 mots dont seulement 10–15 % seront utilisés.

- L’objectif n’est pas d’être « le plus long », mais d’être la source la plus pertinente, la mieux structurée, et suffisamment compacte pour que les passages essentiels soient facilement sélectionnables.

- La bataille se joue sur le classement : être dans les tout premiers résultats te donne une part significative du budget de grounding, ce qui augmente la visibilité dans les réponses IA.

- Pour un site qui vise l’AI Search, cela pousse à structurer le contenu en blocs d’information denses, bien balisés, avec un haut taux de signal et peu de remplissage. L’enjeu n’est plus seulement de séduire l’internaute, mais aussi de produire des segments de texte que le moteur peut facilement extraire pour alimenter ses réponses génératives.