Cet article a pour (humble) objectif de revenir sur l'historique des moteurs de recherche qui ont existé en France depuis la création du Web (Lokace, Ecila, Deepindex, Exalead, Orange, Xaphir, Qwant...), une période que j'ai eu la chance de vivre dès ses origines puisque je travaille sur le Web et que je me passionne pour les outils de recherche depuis 1993. L'idée sera également de tenter ici de tirer les leçons du passé et de comprendre pourquoi tous ces projets ont été des échecs et d'identifier ce qui a toujours manqué à ces outils pour réellement percer, au fil des ans...

Petit préambule : dans cet article,

- Je ne parlerai que des moteurs ayant développé leur propre technologie de recherche (algorithme/index), excluant donc une myriade de métamoteurs, d'outils utilisant des technologies existantes (la plupart du temps celles de Google ou de Bing à l'heure actuelle) ou créateurs de surcouche logicielle, aussi intéressante soit-elle (Kartoo...). Même si j'y reviendrai à la fin de cet article...

- Je ne parlerai que des moteurs d'origine française, donc exit les Lycos, Inktomi, Hotbot et autres AltaVista (même si, pour ce dernier, plusieurs français faisaient partie de l'équipe, mais le moteur avait avant tout une vocation US et a clairement été créé outre-Atlantique, pour Digital à l'époque).

- Je ne parlerai que des moteurs de recherche généralistes (tout le Web), et pas de ceux (très nombreux), se limitant à une seule approche ou une seule thématique.

- Je ne parlerai pas des annuaires (Nomade, le guide de Voilà, etc.), dont le fonctionnement était très différent de celui des moteurs proprement dit.

Autre point important : notez bien qu'on peut ne pas être d'accord avec moi par rapport à ce que j'écris dans cet article, je le conçois aisément, mais j'expose ici mon avis personnel que je partage avec moi-même... 🙂

La préhistoire : les années 1990

Ceci étant établi, commençons donc avec les débuts du Web et les années 90. La France a, à cette époque, peu de sites et les sites web, peu de pages (pour l'anecdote, mon premier livre, "Internet guide de connexion", paru en 1994, proposait en annexe la liste exhaustive des sites web français en quelques pages qui n'étaient pas écrites en petits caractères 😉 ). A cette époque, on trouve tout d'abord Lokace (1994-2002), un moteur qui ne s'est hélas jamais montré très pertinent dans ses résultats, ce qui a certainement entraîné rapidement sa chute. Apparaît dans la foulée Ecila (1996-2001), un peu plus pertinent, mais qui n'a jamais trouvé son public, lui non plus.

Sur cette première décennie, ces deux moteurs n'ont jamais percé pour une raison simple : les autres (la plupart du temps américains : Altavista, Lycos, Webcrawler, Infoseek, Excite, etc.) étaient meilleurs, même sur le Web francophone ! Et les annuaires étaient souvent préférés pour rechercher des sources d'information françaises. Ceci dit, ces "ancêtres" étaient des pionniers du domaine et ont participé au défrichage du Web francophone à leur manière.

Page d'accueil du moteur Ecila. Source : Internet Archive

Les années 2000 : Deepindex et Dir.com

En 2002 débarque DeepIndex, projet mis en place par Gilbert Wayenborgh, première "vraie" tentative de moteur de recherche français. Dans sa foulée, Dir.com, créé en 2003 par deux employé d'Iliad/Free, tente sa chance. Je dois bien dire que ce dernier moteur m'a toujours laissé un excellent souvenir. Tout d'abord, ses concepteurs étaient très sympas et nous avons même mené quelques projets en commun à l'époque. De plus, leur moteur était vraiment de bonne qualité, alors qu'ils n'avaient que très peu de moyens (pour ne pas dire quasiment aucun moyen), Dir.com ayant été créé "à l'arrache" au sein de Free, un peu au vu et au su de tout le monde. Ils n'ont hélas pas été suivis ensuite par leur "maison mère", laissant la technologie à l'abandon au bout de quelques années alors que celle-ci me semblait pourtant vraiment "bien née".

Deepindex, pour sa part, tiendra bon un peu plus longtemps, mais ce projet courageux abandonnera également la partie quelques années plus tard, au vu des importants investissements nécessaires pour continuer l'aventure à une époque où les modèles économiques pour un moteur de recherche étaient encore très flous (les réseaux publicitaires Espotting/Miva et Mirago ont également connu de nombreux problèmes à cette époque, entraînant le moteur dans leur charrette).

La page d'accueil du moteur Dir.com. Source : Internet Archive

Le temps des regrets : Orange et Exalead

Parmi les acteurs qui vont devenir majeurs par la suite, on peut bien sûr citer KE, technologie de "search" issue d'Echo et qui va équiper de nombreux moteurs de France Telecom puis d'Orange, et notamment Voilà et LeMoteur. Ce couple algorithme+index, développé par une équipe enthousiaste, sympathique et motivée à Sophia Antipolis, était vraiment de bonne qualité et souvent en avance sur son temps (parfois trop peut-être, d'ailleurs). Avec une "team" hélas réduite au fil du temps et très peu de moyens, l'équipe "Search" d'Orange a souvent fait des miracles alors que l'outil était avant tout vu par ses dirigeants comme une possibilité pour l'entreprise d'insérer des liens (naturels et publicitaires) "maison" dans les résultats de recherche, procédés interdits par Google. Et puis, un jour (2017), Orange a coupé le cordon et passé son moteur sur la technologie de Google. Le moteur KE reste un grand regret pour moi, car il avait vraiment sa place sur le marché français et il aurait certainement pu devenir rentable s'il avait été aidé par sa hiérarchie à cette époque. Les actionnaires en ont pourtant décidé autrement…

On ne peut bien sûr pas passer sous silence Exalead, créé en 2000 par François Bourdoncle (auteur notamment de l'outil "Cow 9 / Refine" sur Altavista à l'époque) et Patrice Bertin. Un beau moteur, une belle histoire. On y croyait dur comme fer… Jusqu'à leur rachat par Dassault Systèmes en 2010, qui sonnera le glas du moteur. Celui-ci tournicote désormais dans un coin du Web (le cimetière des éléphants du "search" ?). Pour Exalead aussi, j'ai un gros regret car c'était un vrai beau moteur, qui aurait réellement pu avoir un bel avenir. Mais peut-être ses concepteurs n'ont-ils jamais su (ou pu) faire un choix entre leur activité de développement de moteurs intra-site et de moteur de recherche Web proprement dit. Mais, là aussi, les investissements pour "tenir la route" en temps que moteur - obligatoirement mondial - ont également pu être considérés comme très (trop) importants, avec une rentabilité hasardeuse sans régie publicitaire propre.

Résultats pour ces deux belles technologies (Orange et Exalead) : RIP, tout simplement. Mais ils constituaient à mon avis avec Dir.com les 3 plus belles technologies de recherche "made in France" qui auraient pu avoir un rôle à jouer dans l'Hexagone en particulier et sur le Web en général. Dans les 3 cas, ce sont les actionnaires, les acquéreurs ou les "N+1" qui n'ont pas suivi. Un manque de vision à long terme ?

Le moteur Exalead est toujours en ligne. Source : Exalead

Les ratés de Xaphir et Qwant

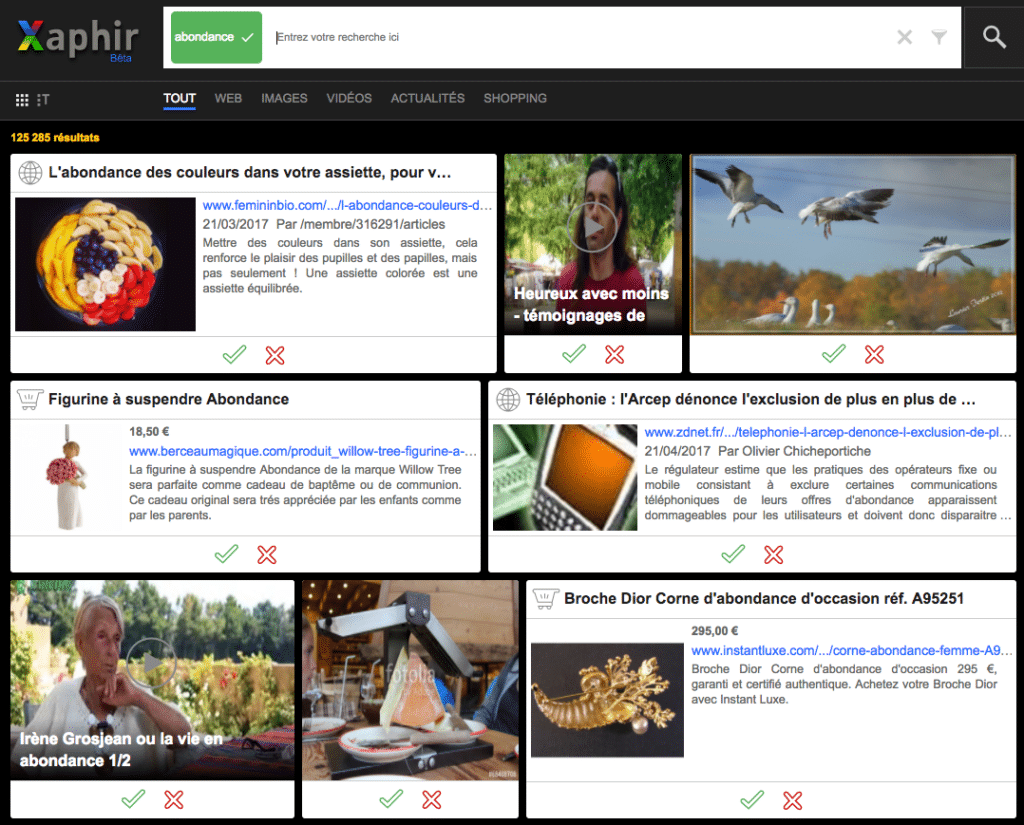

Ces dernières années, on a également vu apparaître Xaphir, moteur conçu à Epinal en 2013 par la société Xilopix, et hélas victime du "syndrome Cuill" (du nom de ce moteur, notamment lancé par Louis Monier, ex-Altavista, ebay, Google, etc. et qui a raté le coche en 2008 en sortant trop vite sous la pression des actionnaires). Des résultats de recherche catastrophiques à son lancement ont hélas scellé le sort de la technologie de Xaphir, rachetée en 2017 par Qwant. A vouloir sortir trop vite un moteur mal fini et pas assez rodé, ils se sont ainsi exposés à quelques déboires, hélas… Mais avaient-ils vraiment le choix ?

Résultat de recherche sur Xaphir pour la requête "abondance" à l'époque. Source : Abondance

Quant à Qwant, j'en ai parlé plusieurs fois sur Abondance par le passé, alors qu'en dire de plus ? Né en 2013, après une communication de départ absolument catastrophique, le moteur a multiplié les erreurs stratégiques pour en arriver finalement à une "annus horribilis" en 2019, conclue par le départ forcé de son PDG Eric Léandri début 2020. Résultat : ce moteur représente aujourd'hui un gros caillou dans la chaussure du gouvernement, à tel point que la question n'est pas (plus) réellement pour nos dirigeants politiques de trouver une alternative à Google, mais plutôt de trouver une alternative à Qwant… Et là, les choses sont clairement beaucoup plus difficiles… Et le fait d'installer le moteur sur les postes des fonctionnaires français ne changera globalement rien (ceux-là retourneront sur Google dès le lendemain). De plus, s'il faut forcer les gens à choisir tel ou tel moteur plutôt que leur choix personnel pour tenter d'obtenir un quelconque et hypothétique succès, c'est qu'il y a vraiment un problème… Bref, Qwant est aujourd'hui en état de mort cérébrale (et son concours SEO Qwanturank n'a hélas rien fait pour améliorer les choses) avec comme résultat, 7 ans après son lancement, des parts de trafic ne dépassant pas 1% en France. On peut le regretter, car il y a certainement en interne de cette entreprise des gens très valables, qui doivent parfois se demander ce qu'ils sont venus faire dans cette galère…

Aujourd'hui, où en est-on ?

Finalement, si on fait un retour en arrière sur les différents moteurs de recherche français qui ont vu le jour depuis près de trente ans, on s'aperçoit qu'ils ont tous été des échecs. Pourquoi ? Plusieurs raisons à cela, selon moi. En vrac :

- Parfois, ils n'étaient pas bons et pas pertinents dans leurs résultats. C'était clairement le cas de certains, ne nous le cachons pas. Mais ceux-la reste finalement des exceptions, car d'autres étaient très bons, ou en tout cas, ils faisaient le job plutôt bien par rapport au Web tel qu'il existait à leur époque.

- Ils ont été tués par des actionnaires ou des dirigeants qui n'y ont pas cru (le syndrome du "ça ne marchera jamais !"). Et c'était bien dommage car certains auraient de façon évidente mérité un meilleur avenir.

- Ils ont été conçus trop tôt, à une époque où les modèles économiques pour les moteurs de recherche étaient loin d'être évidents (c'est d'ailleurs l'une des raisons du succès de Google - mais pas la seule - : il est arrivé après tout le monde, à une époque bien plus propice au développement économique d'un tel outil).

- Les investissements nécessaires pour évoluer avec la taille et la complexité du Web ont eu raison des bonnes volontés pourtant évidentes au départ.

- Ils ont été victimes d'erreurs stratégiques et/ou d'une communication catastrophique parfois.

On pourrait certainement trouver d'autres raisons, mais à mon avis, les principales sont là. Et puis, passé le début des années 2000, le succès fulgurant de Google n'a plus laissé beaucoup de place à grand monde. 20 ans plus tard, il est trop tard…

En effet, le paysage actuel du "Search" mondial est devenu assez simple : au niveau planétaire, il ne reste plus que deux technologies de recherche disponibles : celles de Google et de Bing. Plus quelques miettes locales pour des Yandex (Russie), Seznam (République tchèque), Baidu (Chine) ou Naver (Corée du sud). Point barre.

Que manque-t-il aujourd'hui pour bâtir un moteur de recherche français ?

Pourtant, on comprend la motivation qu'ont de nombreuses personnes de combattre l'hégémonie américaine dans ce domaine. Qui traite et diffuse les résultats de recherche sur le Web aujourd'hui noyaute l'information, voire les opinions. Le risque géopolitique est énorme. Il ne serait donc pas illogique que le gouvernement français, ou tout simplement les citoyens français, appellent de leurs vœux un moteur "made in France". Mais il faut aujourd'hui et pour cela partir de quelques postulats qui me semblent évidents :

- Créer en 2020 (et a fortiori plus tard) un moteur de recherche (ou a minima la partie "crawl+index") "from scratch", en France ou ailleurs, est une totale utopie. Une hérésie. Un fantasme. Le Web est devenu trop énorme, trop complexe, et les investissements humains et techniques pour y arriver sont absolument colossaux. Même Amazon (avec A9) s'y est cassé les dents. Même Microsoft, avec Bing, a du mal à grignoter des parts de trafic à Google depuis des années. Même Facebook et Apple, pourtant souvent tentés, ne s'y sont jamais risqué.

- Si une start-up se lançait sur ce marché, elle partirait de toutes façons avec un handicap de plus de 20 ans de retard par rapport à ses concurrents. C'était peut-être un avantage pour Google en 1998 de partir après les autres en évitant leurs erreurs à une époque plus favorable, mais en 2020, la donne a considérablement changé. 20 ans de retard en termes de data : le handicap est désormais trop énorme.

- Et si, par miracle, cette start-up réussissait son coup, elle passerait immédiatement au statut de BBBBG (Born to Be Bought By Google) ou BBBBB (Born to Be Bought By Bing). Il ne faut pas rêver : qui dit non à quelques centaines de millions (voire plus) de dollars ?...

Soyons clair : la création d'une nouvelle technologie de "search" à notre époque est impossible, inimaginable, irréalisable, au moins pour la partie qui consiste à maintenir un index mondial à jour. Point. On peut le regretter pendant des jours et des mois, il en est pourtant ainsi. Un moteur, pour se développer, doit s'appuyer sur une technologie existante et, sur cette base, proposer, bâtir "autre chose". Et, plus clairement, si le but est de se battre contre Google, il n'existe qu'une solution : utiliser son concurrent, Bing !

Et donc, si on veut "briser le mauvais sort" qui envoie systématiquement à la poubelle les moteurs de recherche issus du cortex "made in France" depuis des décennies, il faudra se résoudre à travailler avec "le Grand Satan" Microsoft pour combattre "le grand Lucifer" Google. Ou ne rien faire. Ou voir mourir une expérimentation à court terme. Ou peut-être gagner un peu d'argent à court terme via un rachat. Ceci dit, le choix et l'axiome de départ restent assez drastiques et limités…

Notons que c'est ici l'approche d'outils comme Ecosia, Lilo, DuckDuckGo et d'autres, qui s'appuient sur des technologies existantes, et qui tirent finalement pas si mal que cela leur épingle du jeu. Mais il faut aller plus loin !

La vérité sera dans l'interface utilisateur...

Autre question, capitale : si on utilise une autre technologie (Bing en l'occurrence), que peut-on proposer de plus, ou plutôt de différent, que Google (et Bing, pour le coup) ? C'est là, à mon avis, que se situe le nerf de la Guerre. Je suis pourtant persuadé qu'il reste énormément de choses à faire au niveau de l'interface utilisateur. Depuis près de 30 ans, un moteur de recherche, c'est un formulaire de recherche (où on tape des mots clés) et une SERP, ou page de résultats du moteur, avec un certain nombre de liens naturels ("liens bleus") et publicitaires.

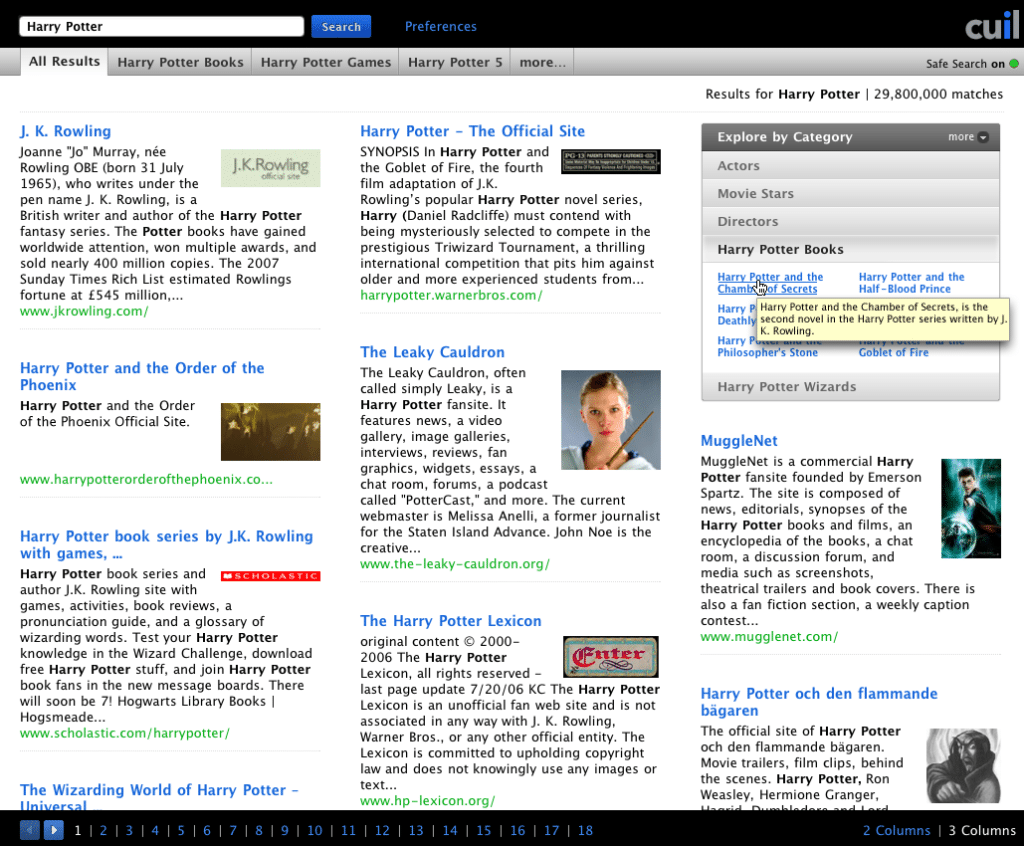

Alors, bien sûr, on ne peut pas bousculer les habitudes des internautes du jour au lendemain (ce serait un échec assuré), mais on pourrait tout à fait leur laisser le choix : soit un affichage des résultats "à la Google" (classique : formulaire + 10 liens bleus + pub), soit une autre façon (ou d'autres façons), plus originale(s), voire un peu folle(s), plus ou moins raisonnable(s) d'afficher les résultats. Cuill, notamment, avait montré la voie à l'époque et, s'il avait fourni des résultats pertinents, il serait certainement aujourd'hui un acteur majeur du "search". Car ses SERP avaient du chien et proposaient une autre voie de lecture assez innovante tout en restant finalement assez académiques. Cuill avait tout juste. Il a juste été lancé trop tôt, mais son approche de base était bonne (selon moi) au niveau de l'interface utilisateur… Xaphir avait également lancé quelques idées intéressantes à son époque. Mais lui aussi est sorti trop vite et n'a pas eu le temps de les développer.

Résultat de recherche sur Cuil à l'époque (2008). Source : Abondance

Il est donc tout à fait possible, à mon avis, de proposer un bon moteur de recherche, avec une "surcouche UX", basée sur la technologie de recherche de Bing (avec un accord garantissant la protection des données personnelles, bien sûr, bien que cela ne soit pas un critère réellement différentiant) mais proposant suffisamment d'innovations dans les aspects d'interface utilisateur pour être agréable à utiliser, au-delà de la pertinence indispensable.

Je continue donc à croire dur comme fer, qu'un moteur, ou en tout cas, un outil de recherche conçu en France (même s'il se base sur une technologie étrangère, ce dont l'internaute se contrefiche totalement - notons que ce dernier utilise déjà un ordinateur et un système d'exploitation américains, voire un téléphone d'origine asiatique - bref, la plomberie ce n'est pas son truc tant que l'eau est potable…) pour gagner des parts de marché et même, soyons fou, devenir rentable ! Et pour moi, le nœud de l'histoire se trouve sur ce que l'on peut proposer à l'internaute comme innovations dans l'interface utilisateur.

L'approche sera également essentielle : ce que veut avant tout l'internaute, c'est de l'honnêteté, de la franchise, de la loyauté et de la transparence. S'il a l'impression qu'on lui ment, qu'on lui cache des choses, il n'adhérera pas au projet. Un point à ne jamais oublier… Certains s'y sont peut-être brûlé les ailes dans le passé !

Il parait qu'en France, on n'a pas de pétrole, mais qu'on a des idées. Alors, prenons le pétrole (index, algorithmes) où il se trouve (Bing) et amenons des idées innovantes (interface, UX) ! Faisons travailler nos méninges et construisons un beau moteur qui parle la langue de Molière ! Ça vous dit ? Alors, à vos synapses ! 🙂

Très intéressant.

Il est vrai qu’il serait un peu plus judicieux de laisser du champ libre à l’utilisateur, sans avoir à lui proposer une liste et direction déjà toute tracé et orienté de la part du moteur de recherche qu’il utilise (google ou bing).

Enfin, tant que c’est lui qui utilise le moteur de recherche pour ces informations et non le contraire…

Et pour reprendre une expression que j’ai lu précédemment : » la plomberie ne nous intéresse pas, tant que l’eau est potable », il serait peut-être temps justement de s’intéresser sur le plombier avant de faire appel à ces services…

Cordialement.

J’ai lu l’article et un peu parcouru les commentaires (J’ai vécu cette époque aussi)

Je trouve excellente l’idée d’un indexeur quasi service public qui viendrait alimenter les innovations algorythmiques de start-up du search. Un peu comme le réseau ferré/ le rail est resté public alors que les locomotives vont appartenir à des privés.

De l’époque, j’ai toujours en mémoire KARTOO qui renouvelait l’interface (pas le seul, SEMIO de Vogel pour rappel, mais le plus coloré) et dont j’attendais beaucoup. OUI il y a encore des innovations à trouver dans les interfaces.

C’est sans doute à cette époque, que je n’ai plus suivi les innovations des autres moteurs vues les stats :

Google 90%, Bing 7% et les miettes pour les autres dont Yahoo (qui a racheté 3 moteurs sans réussir à redécoller).

A partir de ces stats et SEO focus, tant qu’un moteur ne dépassait pas 10% des requêtes, il ne m’intéressait pas.

Du coup, je ne me rappelle même plus de l’interface de résultats de CUIL (j’ai cherché sur Abondance seulement)

Bien à vous

David

Bonjour,

Nous avons lu votre article sur la malédiction des moteurs de recherches français. Nous vous informons que nous sommes actuellement en train de développer un moteur de recherche 100 % Français (en s’appuyant sur quelques scripts créés par une communauté française en ligne).

Nous sommes deux jeunes passionnés d’informatique et nous tenons la chaîne YouTube et le site Internet Le Taille Crayon.

Notre moteur de recherche est à but non-lucratif et ne référence que des sites français (et certains sites francophones, également).

Notre ambition n’est pas de renfermer l’internet français sur lui-même, ce qui serait idiot mais plutôt de montrer qu’il est possible de naviguer sur le Web qu’avec des sites français et par la même occasions de promouvoir ces sites français.

Vous pouvez déjà essayer la toute première version de notre navigateur à l’adresse « https://webeeblue.yn.fr » mais le lancement officiel n’est pas encore prévu…

Bjr. Euh, j’ai testé et toutes mes recherches renvoient « 0 résultats » ???

Bonjour,

Pouvez-vous nous communiquer les recherches effectuées.

Pour l’instant Webeeblue ne référence que très peu de site et votre aide nous est très précieuse !

Pouvez-vous nous répondre, soit sur ce forum ou bien par Email (de préférence) à

lecrayon@webeeblue.yn.fr

Merci !

Au moins faites un moteur FRANCOPHONE, il y a une communauté et des institutions internationales sur ce créneau. Et puis il y a des pays en croissance à 2 chiffres en Afrique.

Merci ! Nous allons d’abord nous concentrer sur des Sites français en priorité mais nous n’écartons aucune piste !

Bonjour,

L’article est très bien écrit et très intéressant. Je suis un novice dans le monde du web et du SEO et vos articles m’aident beaucoup pour comprendre les rouages de ce métier.

Merci beaucoup et félicitations pour votre travail !

Victor

Les chiffres ne cadrent pas du tout entre les différentes sources! Qui se trompe?

https://news.netcraft.com/archives/category/web-server-survey/ estime en décembre 2019 qu’il y a 1,3 milliards de noms de domaine mais seulement 180 millions de sites actifs. Cette source est fiable. Cela ferait une moyenne de entre 200 000 et 600 000 URLs par site actif ce qui n’est absolument pas crédible. Il faut noter que depuis 2011 le nombre de sites actifs est stable indépendemment de la croissance des noms de domaine: ce phénomène s’explique par le fait que les décés (les sites disparaissent!) équilibrent les naissances.

https://www.worldwidewebsize.com donne la taille de l’index de Google à 60 milliards d’URL. Cela ferait un pourcentage de pages indexées entre 0,15% et 0,05%… ce qui est difficile à croire, quoique cette source est moins fiable. A noter que depuis des années ce chiffre n’évolue pas beaucoup, probablement plafonné par le coût qu’il implique en terme de data center.

Je pense que certains rapports entretiennent une confusion entre sites et pages web… et que le flou permanent sur les données « taille du web » et « taille de l’index » arrange bien Google.

En tous cas, en 2009 les données étaient fiables et se recoupaient: il y avait 120 milliards de pages web et l’index était de 40 milliards (source: Cuil recoupée par de nombreuses autres sources). On serait passé entre 2009 et 2013 de 120 milliards de pages à 30 000 milliards? Une multiplication par 250 en 3 ans… Difficile à avaler.

Si une personne compétente et actualisée pouvait essayer d’investir du temps pour établir la vérité sur ces données essentielles en priviliégiant les sources transparentes sur les méthodologies (ce qui n’est pas le cas de Google ou Alexa pour citer 2 exemples), cette personne rendrait un grand service à la communaué scientifique et professionelle. Je pense à vous bien entendu ;-).

Vous écrivez : – Pour info, Google et Bing communiquent sur une taille entre 40 et 120 mille milliards d’URL (voir article sur Bing de c ematin).

Je pense que le mot mille est un lapsus : vous vouliez dire entre 40 et 120 milliards d’URL. La taille de l’index est une donnée clef et depuis 2008 les moteurs restent très discrets. Ce silence est-il là pour cacher une réalité essentielle: alors qu’avant 2007 les index recouvraient près de 80% de la Toile (c’est à dire que 80% des pages web étaient indexées) ensuite ce pourcentage est tombé en dessous de 5%. Un des effets collatéraux est que les URL non anglophones sont défavorisés dans les Index ce qui donne un argument solide pour construire des moteurs avec une meilleure couverture que Google ou Bing dans une langue donnée (ce que font – ou on fait- les russes, les chinois, les portugais, les coréens, les kurdes…). Voilà me semble-t-il un argument très fort pour la création d’un moteur francophone.

En 2012, le responsable scientifique de Exalead me confait en privé que 1) mon estimation d’une taille index inférieure à 5% chez Google était correcte et que 2) Exalead indexait plus de pages en français que Google. Je reviens sur la taille de l’index avec plus de détail dans la contribution suivante en recopiant un courrier fait au magazine La Recherche en 2014 qui présente des arguments.

Je mesure la place des langues dans l’ Internet dans le cadre de l’Observatoire des langues et cultures dans l’Internet depuis 1988. Entre 1988 et 2007, la méthode se servait des compteurs d’occurence de mots-clefs des moteurs de recherche. L »evolution des moteurs a invalidé cette méthode depuis. A partir de 2017 j’ai mis au point une autre méthode indépendante des moteurs (voir http://funredes.org/lc). J’avoue ne plus avoir suivi le thème des index depuis 2014 et je suis certain que s’il y a eu du nouveau depuis vous devez être bien informé.

non, non, il n’y a pas d’erreurs. Il s’agit bien de « 40 et 120 mille milliards »

C’était déjà 30 000 milliards en 2013 (https://www.abondance.com/20130517-12616-google-crawle-20-milliards-de-sites-web-chaque-jour.html) le chiffre est même monté jusqu’à 120 000 milliards pour Google avant déduplication (http://www.thesempost.com/how-many-urls-duplicates-google-knows-about/)

Attention à ne pas confondre :

1 billion (en anglais) = 1 milliard (en français)

avec

1 billion (en français) = 1 million de millions, soit 1000 milliards

Pour en savoir plus : https://fr.quora.com/Pourquoi-un-billion-en-anglais-représente-un-milliard-en-français-et-qu’un-billion-en-français-correspond-à-1000-milliards-Cela-entraîne-des-erreurs-de-traduction-dans-les-journaux

Bonjour,

Dans la catégorie « brainstorming », plutôt que de penser tête baissée à des algos, des technos, des fermes de serveurs, des investissements colossaux, pourquoi ne pas envisager le challenge différemment ?

Google ne s’est pas fait en un jour. Et pour rappel, Google a très longtemps utilisé l’Open Directory Project (alias DMOZ), c’est à dire toutes le résultat du travail de toutes ces petites mains du web qui structuraient l’information dans le monde entier, sur la base de volontariat…

Aujourd’hui encore, Google emploie à tour de bras des « travailleurs du clic » pour qualifier les résultats de ses pages (pas seulement les sites web puisque ça s’applique également aux résultats des assistants vocaux, aux cartes, etc)

Le grand public ignore tout cela et voit Google comme une boîte noire complètement magique, quand en réalité une partie énorme du travail est fournie par les internautes. Je ne mentionne même pas les internautes qui le font à leur insu comme les Re-captcha pour entraîner le machine learning, l’analyse du pogo-sticking pour améliorer le classement des serps etc

Pourquoi ne pas partir sur un modèle de moteur collaboratif/contributif ?

My 2 cents

@pyg : je voudrais bien y croire, mais je crois que le temps m’a rendu trop pragmatique. J’ai bien peur que cela ressemble encore à un « pognon de dingue » (comme dirait l’autre) jeté par la fenêtre. Mais peut-être suis-je trop pessimiste…

Merci pour cet (excellent) article, Olivier.

Il me paraît quasiment d’utilité publique tellement ce travail de synthèse et, osons le mot, de mémoire, est important pour pouvoir se poser de bonnes questions.

(Je m’étonne juste de ne pas y trouver mention de Quaero https://fr.wikipedia.org/wiki/Quaero , moteur franco-allemand certes, mais donc en partie FR. Ce n’était certes pas un moteur de recherche « classique », mais le but de Quaero était bien, me semble-t-il de proposer des outils pour la recherche.)

Je conçois parfaitement que l’angle de l’article était de participer à identifier « ce qu’il manque pour qu’un moteur de recherche FR puisse percer », mais j’aimerai y ajouter une dimension supplémentaire 🙂

En bon libriste (disclaimer : je suis directeur de Framasoft, asso d’éducation populaire aux enjeux du numérique), je rejoins complètement Olivier Ertzscheid (de https://affordance.info ) lorsqu’il publiait dans Libération une tribune (en … 2016 !) « Pour des Etats Généraux de l’Internet Indépendant » https://www.liberation.fr/debats/2016/12/15/pour-des-etats-generaux-de-l-internet-independant_1535520

Olivier (celui d’Affordance, pas celui d’Abondance, faut suivre 😉 ) y pointait la nécéssité impérieuse de mettre en place et d’opérer un « index indépendant » (lire l’article https://www.affordance.info/mon_weblog/2015/04/symptome-acces-mal-internet.html ou voir les slides https://affordance.typepad.com/mon_weblog/2017/11/one-index-to-rule-them-all.html

Pour résumer grossièrement, il s’agissait de proposer de créer notre propre index (qui allait au-delà de simplement lister les pages web) qui soit :

– ouvert et accessible à tou⋅te⋅s (domaine public ou licence libre copyleftée)

– à des conditions équitables

– accessible complètement (et non par traitement pré-rendu)

A partir d’un tel index, il devenait pensable de créer de multiples moteurs de recherche avec leurs propres algorithmes de classement, avec leurs propres présentations, avec leurs propres thématiques, pour un coût infiniment moindre. Le tout utilisant ce « commun » qu’aurait été l’index web indépendant (exactement comme Wikipédia est une encyclopédie certes imparfaite, mais indépendante).

C’était une idée sacrément ambitieuse. Mais pas infaisable.

C’était une idée coûteuse. Mais au coût absolument dérisoire par rapport aux enjeux.

Je rappelle qu’Internet Archive (https://archive.org) , c’est

330 billion web pages

20 million books and texts

4.5 million audio recordings (including 180,000 live concerts)

4 million videos (including 1.6 million Television News programs)

3 million images

200,000 software programs

C’était aussi l’un des buts de https://www.openindex.org/designforapublicindex/ (de 2001 à 2009)

Aujourd’hui, en dehors de Archive.org, l’un des index les plus intéressants me parait être https://commoncrawl.org/ (même si l’API est ouverte, il y a encore pas mal de limitations mais qui ne demanderaient qu’à sauter).

C’est donc bien sur cette idée de « l’investissement » qu’on a échoué.

Aujourd’hui, selon l’institut LaLoucheDePyg, construire un index **des documents uniquement** (= en gros, des pages web & PDF, si je résume très très grossièrement) coûterait en gros 10 à 20 millions d’euros avant de pouvoir être correctement opéré

(je me base ici sur de vieux calculs que j’avais fait concernant archive.org et d’autres plus récents autour de Qwant).

Le coût annuel serait ensuite bien moindre.

Je pense que, sans cet index indépendant, l’idée d’un moteur de recherche FR demeure vouée à l’échec, car qui irait miser 20 millions d’euros pour aller concurrencer les 1 000 milliards de Google ? Même si des modèles économiques à court terme sont possibles (Qwant en propose un, actuellement non-rentable certes, mais qui n’est pas idiot sur le papier), des modèles rentables à long terme ne le seront jamais (sauf à aligner les planètes Régulation FR + Régulation EU + Régulation US + penser que Google laisserait faire en mode Bisounours sans réagir. Ce qui, soyons sérieux 5mn, n’arrivera PAS.).

Avec un tel index (qui pourrait être financé par différentes sources, publiques et privées, mais avec une gouvernance indépendante), alors on ôterait le blocage à l’innovation que réprésente le coût de constitution et d'(inter)opérabilité cet index, et on pourrait voir fleurir – enfin ! – de vrais moteurs de recherches indépendants (pour la recherche, pour le grand public FR, pour la startup bidule, pour les agriculteurs slovaques, etc.). En laissant chacun gérer sa techno, son business model, son « angle ». (Et nous libriste, pourrions nous appuyer dessus pour inventer de nouvelles formes de recherches, décentralisées et fédérées, prenant la suite de projets intéressant comme https://yacy.net malheureusement à l’arrêt depuis quelques années).

Quant on sait que le coût d’un kilomètre d’autoroute est d’environ 5 millions d’euros ( https://fr.wikipedia.org/wiki/Autoroute#Co%C3%BBts ) et que le coût de https://fr.wikipedia.org/wiki/Quaero (échec certes retentissant comme le décrivait un 3e Olivier : https://www.oezratty.net/wordpress/2008/que-devient-quaero/ ) tournait autour de 100 millions d’€, ça ne serait quand même pas le bout du monde.

Se dire que pour l’équivalent de 2 à 5 km d’autouroute, on pourrait avoir un commun qui permette de sortir de Google, ça aurait quand même de la gueule, non ?

– Quaero : j’y ai pensé mais j’en ai déjà parlé dans d’autres articles, alors à quoi bon ? Ca n’a rien donné de concret, de toutes façons.

– « construire un index **des documents uniquement** (= en gros, des pages web & PDF, si je résume très très grossièrement) coûterait en gros 10 à 20 millions d’euros » : euh, pour quelle taille ? Car ça me semble être un critère plus qu’important. Je doute fort que ça ait coûté cela à Google et Bing pour créer le leur…

– Pour info, Google et Bing communiquent sur une taille entre 40 et 120 mille milliards d’URL (voir article sur Bing de c ematin). Une paille… Quel coût pour cette taille ?

> – Quaero : j’y ai pensé mais j’en ai déjà parlé dans d’autres articles, alors à quoi bon ? Ca n’a rien donné de concret, de toutes façons.

Comme cet article donnait une vision historique des essais et erreurs, je me suis dit que ça aurait pu être pertinent (mais c’est ton article, tu écris bien ce que tu veux 🙂 )

> – « construire un index **des documents uniquement** (= en gros, des pages web & PDF, si je résume très très grossièrement) coûterait en gros 10 à 20 millions d’euros » : euh, pour quelle taille ?

en gros 100 à 500 milliards de pages, si je me base sur le travail d’Archive.org qui héberge +300 milliards de pages et 20 millions de documents (et qui a coûté bien moins que ça d’après les quelques chiffres que j’avais trouvé). Après, il y aura toujours besoin d’investissements annuels (moindres, mais pas négligeables) mais en dessous, ça risque d’être compliqué d’être pertinent.

> Car ça me semble être un critère plus qu’important. Je doute fort que ça ait coûté cela à Google et Bing pour créer le leur…

La taille n’est effectivement pas la même, mais les objectifs politiques et stratégiques non plus.

> – Pour info, Google et Bing communiquent sur une taille entre 40 et 120 mille milliards d’URL (voir article sur Bing de c ematin). Une paille… Quel coût pour cette taille ?

Je pense qu’on s’est mal compris. Le but de se projet n’est pas d’en avoir une plus grosse que Google. Je dis justement qu’on ne peut pas rivaliser contre 155 Mds $ de CA (et 32 Mds $ de bénéfices), et donc qu’il faut chercher d’autres voies, sous peine de répéter nos erreurs en boucle et que cette dépendance devienne perpétuelle.

Les 20 millions dont je parle (4 Km d’autoroute !) permettraient de bootstraper un index suffisant pour se dire qu’on peut envisager autre chose que Google ou Bing! Je rappelle que la première année, Google se vantait d’indexer 1 million de pages web « seulement ». Bref, ta remarque me parait laisser de côté « dynamique historique » de la construction d’un index dans le temps, ou alors me semble jeter le bébé avec l’eau du bain sous prétexte qu’il y a un nageur Olympique américain dans la piscine d’à côté. Alors que moi, ce qui m’intéresse en réponse à ton article, c’est qu’on tire les leçons de nos erreurs et qu’on mise sur l’avenir en se disant que l’avenir d’un moteur de recherche FR passera sur des technologies FR (ou autres), utilisant un « commun » numérique, plutôt que sur l’illusoire stricte mise en concurrence d’un David français face à un Goliath U.S. déjà installé.

Est-ce qu’à l’année 1 on pourra dire « OK, plus jamais je n’utilise Google ? » : non ! 🙂

Mais il faut bien commencer quelque part, sauf à se dire qu’en fait on s’en fout, et que l’accès aux savoirs du monde reposant entre les mains de seulement 2 ou 3 entreprises est une situation souhaitable.

Je comprends bien, mais si dès le départ, on ne nage pas dans la même piscine, il n’y a à mon avis aucune chance qu’on passe dans l’autre dans le temps. Bien au contraire, le fossé se creusera. C’est un peu le sens de mon article : combler 20 ans de retard (et Dieu sait si la situation aujourd’hui n’est pas celle de 1998 à la naissance de Google… Avec quelque smillions de pages, il tenait la route et s’est très rapidement mis au même niveau que ses concurrents). L’histoire montre très bien que si un moteur est mauvais dans ses résultats dès le départ, c’est l’échec assuré. Et si l’index n’est pas à la hauteur, comment le moteur peut-il l’être ? C’est en tout cas ma principale préoccupation…

> si dès le départ, on ne nage pas dans la même piscine, il n’y a à mon avis aucune chance qu’on passe dans l’autre dans le temps.

Je comprends parfaitement ce point de vue. Maintenant, je ne le partage pas, parce que mon intuition c’est que Google, se sentant en position de force (et il y a de quoi !) va continuer à aller dans des sens « non éthiques » ( notre veille sur le sujet : https://framablog.org/author/chris-h/ ) et qu’à un moment (certes hypothétique, mais j’y crois, malheureusement ), ça va juste péter.

Evidemment, je peux me planter, et j’ai un regard forcément biaisé du fait de mon métier (qui fait que je suis entouré de Google-criticals 😉 ).

> Et si l’index n’est pas à la hauteur, comment le moteur peut-il l’être ? C’est en tout cas ma principale préoccupation…

On est d’accord : mauvais index == mauvais moteur (et « bon index » ne signifie pas pour autant « bon moteur », d’ailleurs).

Ce n’est pas une solution « clé en main » qui est proposée. Mais ça reste à mon avis la seule voie valable à long terme : que de multiples acteurs s’allient pour alimenter un commun numérique public et libre, et que la sacro-sainte création de valeur (innovation et $$) se face en dehors de ce cadre (essentiellement dans l’applicatif, donc).

Voici un argumentaire de 2014 à propos de la taille des index des grands moteurs de recherche.

To: courrier@larecherche.fr

From: Daniel Pimienta

Subject: Courrier de lecteur sur dossiers de la Recherche #8, de février/mars 2014

Dans les dossiers de la Recherche #8, de février/mars 2014, Stpehane Vlossat fait référence, dans le chapitre « Les têtes chercheuses de Google » de l’article sur « Les 5 algorithmes indispensables pour le Web », aux, je cite: « 60,000 milliards de pages contenues sur le Web ». Quelle est la source ou le calcul qui lui permet de mentionner ce chiffre?

Par ailleurs il écrit à propos des programmes de « crawling » du robot de Google, je cite: « qu’ils récupérent et indexent le contenu de la quasi intégralité des sites ».

Sauf changement remarquable qui se serait produit dans les mois passés (et quil serait souhaitable dans ce cas de développer dans un tel article) cette affirmation me semble non seulement fausse mais aussi contribuer à la propagation d’un mythe bien dangereux sur la toute puissance de Google et la confiance qu’il faudrait accorder aux résultats de nos recherches avec cet outil!

D’après les études que nous poursuivons à FUNREDES dans l’Observatoire des Langues sur l’Internet, s’il est vrai que les moteurs de recherche étaient capables jusqu’en 2007 d’indexer plus de 80% des pages existantes sur le web cette situation a radicalement changé depuis. Il y a 2 ans, les meilleures estimations, corroborées par un ancien responsable de recherche chez Exalead (un moteur de recherche européen), plaidaient pour un chiffre inférieur à 5%, ce qui devrait poser de graves questions sur la confiance que nous accordons aux résultats des recherches sur le Web.

Les derniers chiffres fiables dont nous disposons sur la taille du web sont de 2008; pour des chiffres actuels le seul moyen est de faire des extrapolations hasardeuses.

En 2008, nous avions ces chiffres (source http://www.giswatch.org/thematic-report/2008-access-infrastructure/accessing-content):

Nombre d’utilisateurs Internet: 1,4 milliards

Serveurs Internet: 500 millions

Sites web : 100-170 millions

Pages Web: 140 milliards

Pages web indexées: entre 20 et 40 milliards

Note: Le moteur CUIL, aujourd’hui disparu, était lancé avec la prétention d’indexer la quasi totalité du Web avec le chiffre annoncé de 120 milliards de pages. Google indexait en 2008 entre 15% et 30% du web (une des techiques pour garder une couverture large en termes de sites est justement de ne plus indexer toutes les pages d’un même site mais se concentrer sur les pages les plus visitées).

Depuis 2008, le Web a continué de croitre de manière exponentielle mais pas du tout la taille des indexes qui sont restée limitée pour des questions de coût des « data centers », lesquels sont liés à la taille de l’index (coût direct mais aussi coût indirect énorme en consommation éléctrique).

Aujourd’hui nous avons:

Nombre d’utilisateurs Internet: probablement proche de 3 milliards (extrapolation de l’UIT à partir des derniers chiffres de 2012 de InternetWorldStats)

Serveurs Internet: 900 millions (source Netcraft)

Sites web : >400 millions? (350 millions en 2011 selon http://www.statisticbrain.com/total-number-of-websites/)

Pages Web: vous dites 60,000 milliards. C’est possible: une extrapolation de 2008 à 8% de croissance par mois donnerait aujourd’hui cette valeur. Mais il y a aussi des pages qui disparaissent et il me semble qu’il serait plus raisonnable de tabler sur une taille de 1200 milliards de pages en extrapolant à partir de 3% de croissance mensuelle.

Pages web indexées: entre 20 et 40 milliards Pas de changement de ce côté! Voir par exemple http://www.worldwidewebsize.com/

Si le nombre de pages web était de 60,000 milliards et que Google indexait 60 milliards de pages sa couverture serait aujourd’hui de 1 pour 1000!

Si le nombre de pages web était de 1200 milliards et que Google indexait 60 milliards de pages sa couverture serait aujourd’hui de 5%!

Dans n’importe quel scénario il est illusoire de croire que les moteurs de recherche indexent la quasi totalité des pages web; il est par contre certain qu’ils font preuves de beaucoup d’astuces pour nous donner cette impression mais que cette situation devrait nous questionner sur la validité du résultat de nos recherches, surtout quand il s’agit d’information dans d’autres langues que l’anglais et/ou dans des domaines peu médiatiques ou peu propices à la publicité…

Daniel Pimienta

Président de FUNREDES

http://funredes.org

http://funredes.org/lc/

On pourrait nuancer le pessimisme sur Qwant. A mon domicile, ce moteur a 100% du marché de la recherche internet depuis qu’il existe et je vois tout autour de moi de plus en plus de personnes qui l’utilisent. Ceux qui déplorent le besoin de soutien pour un moteur comme Qwant devraient considérer que Google tient tout le marché. Avec un tel écart, on ne peut qu’avoir un coup de pouce sinon on est mort, quel problème ? D’ailleurs, si Qwant avait bénéficié des mêmes milliards de dollars que Google pour démarrer, je pense qu’il n’y aurait pas tout ce débat.

De toute façon, comment ne pas considérer que même Google bénéficie d’un soutient massif et majeur. Ils ont des dépenses marketing titanesques pour maintenir leur contrôle. Les navigateurs le mettent par défaut, grassement payés, les téléphones Android sont un immense écosystème de soutien payé à coup de milliards d’investissements. Tous les sites internet sont payés ou asservis par des contrats publicitaires par Google pour mettre en avant ses outils, dont son moteur de recherche. A regarder les conditions du succès de Google, on pourrait même penser que le 1% de Qwant a coûté 10 fois moins cher que chaque % gagné par son concurrent. A l’aune de ces constats, je trouve le projet Qwant courageux et pas si inefficace.

Reste que Google a trouvé le moyen de gagner de l’argent par son emprise massive et mondiale, Qwant est encore un petit projet comparé.

Oula le coup de vieux.

Article très intéressant où j’ai appris (ou peut-être que je l’ai su) que Lycos, en faites, était américain. Perso. j’ai toujours classé Exalead comme metamoteur.

Par contre de mémoire Orange/wanadoo avait sortie un moteur de recherche à l’époque (année 90) qui renvoyait les résultats et de la pub pour sa version entreprise (ce n’était pas voila) masi impossible de me rappeler son nom.

Sinon j’ai retrouvé ça sur Voila https://blogs.mediapart.fr/pierre-grenet/blog/200818/voila-vingt-ans-apres-ne-comptez-pas-sur-google-pour-ecrire-l-histoire

Je vois qu’il y a ici un concentré de compétences sur le thème des moteurs de recherche et je me permets une question à l’auteur (et à la cantonnade) : qu’est-il advenu du projet de Wikimedia de créer un moteur de recherche éthique et honnête il y a quelques années. Le projet avait (malheureusement à mon avis) provoqué pas mal de critiques au sein même de la communauté Wikimedia : a-t-il été abandonné? Le besoin d’un moteur objectif qui ne soit pas intelligent (et vicieux) et se contente simplement de rechercher les mots-clefs dans les pages sans se préoccuper de contexte, traduction et historique de recherche reste à mon sens pour une communauté scientifique ou professionelle qui n’est pas préoccupée seulement par les premiers 10 résultats mais veut conduire des études systématiques et complètes et/ou pour qui le comptage des occurrences a un sens (AltaVista quoi :-)) .

Wikia Search ? C’est ici !

Merci de vos réponses. Bien dommage que Exalead n’actualise plus son index… Je ne faisais pas référence a WikiaSearch mais à un projet plus « classique » et plus récent (2016) que la presse avait mentionné (voir par exemple : https://www.newsweek.com/wikipedia-takes-google-new-transparent-search-engine-427028) .

Wikipedia avait démenti : https://www.abondance.com/20160217-16162-wikipedia-bientot-concurrent-de-google.html

Merci pour cette intéressante revue historique et présente. Je trouve que vous passez trop vite sur Exalead qui reste une petite merveille au niveau de l’interface (la possibilité judicieuse de trier les résultats par langue, type de fichier, etc… rappelle les prouesses de feu NorthernLight) et qui se défend bien me semble-t-il sur la taille de son index de pages en français. Le fait que la stratégie commerciale de Dassault Système ne soit pas dans le grand public n’empêche que l’accès est libre au public et que c’est une alternative de qualité pour les personnes intéressées par la toile francophone. Je me suis toujours demandé pourquoi son utilisation n’est pas recommandée dans le monde universitaire francophone voire dans l’administration (un succès de ce côté mettrait probablement Dassault dans l’embarras ou pourrait-il lui faire revoir sa stratégie?). S’il y a des arguments solides contre son utilisation je ne les vois pas clairement et je serais curieux curieux de les connaitre.

Eh bien, c’est surtout qu’Exalead n’est quasiment plus mis à jour. Quelques requêtes sur le moteur le montrent vite, hélas…

« vieux de la vieille » aussi, je me souviens qu’un temps -mais je ne me souviens plus quand- il y avait un moteur qui, à partir d’une recherche, créait un réseau de liens de et vers les thèmes ou notions approchants.

Cela vous rappelle-t-il qqch ? et si oui quoi

Kartoo ?

ah oui, c’est bien Kartoo. Et c’est bien navrant que ça soit fini.

Il y a bien encore un Kartoo, mais tout triste et plat….

L’article était tout à fait intéressant

je suis blogueur, je developpe un moteur de recherche mais pour le moment je vais utiliser l’API de BING, car je suis encore entrain faire des recherches sur comment Google ou Bing parviens à indexer un site , web ,sont il partenaire au ICANN? pour savoir que un nouveau site est disponible et commencer a crawler

Olivier,

Ton très excellent article m’évoque quelques questions …

1/ Te rappelles-tu de cet article du Monde qui explique que Google a une copie de la base de l’ICANN ?

https://www.lemonde.fr/idees/article/2016/05/06/comment-google-a-change-l-internet-sans-vous-le-dire_4914648_3232.html

Qu’en penses-tu ? D’autres structures ont-elle ce privilège ?

nb : j’ai l’article en entier si tu veux le lire

2/ La solution ne réside-t-elle pas dans un découpage de Google/Alphabet ? Avec un tel monopole, ils auraient dû passer à la tronçonneuse il y a bien longtemps, non ? Ce n’est pas une preuve de bonne santé démocratique de garder une structure comme celle-ci ….

3/ Est-ce que le projet de RINA de Louis Pouzin pourrait (s’il voyait le jour) rebattre les cartes ?

4/ Quand est-ce que tu passes au Club IES nous faire une conférence sur ces sujets ;-))

Jerome

1. J’avoue ne pas trop voir le rapport avec le sujet des moteurs de recherche français ?

2. Idem

3. RINA est un projet de structure réseau, non ? Là aussi, quel rapport ?

Globalement, attention, l’article ne traite pas de l’hégémonie de Google sur le Web et le Search, mais pose la question « qu’est-ce qu’il manque aux moteurs de recherche français pour résusir ? ». C’est un très bon sujet, certes, et même un excellent sujet, mais pas celui de l’article ci-dessus 🙂

Humm, c’est pas faux… j’ai profité de cet article pour te poser des questions qui me turlupinaient 😉 Mais je me suis en effet éloigné du sujet.

Néanmoins si dans un prochain article, tu avais un éclairage sur ces différents points, je suis preneur.

Excellent article Olivier, comme d’habitude !

Pourtant, je reste persuadé que l’on ne peut pas se satisfaire de ce duopole (Google/Bing). Que cela représente un risque considérable pour notre capacité à nous informer librement. Et que le devoir de notre génération, c’est d’offrir à nos enfants et petits enfants des solutions alternatives …

Bon, je sais c’est grandiloquent … mais le pire est que je le pense sincèrement ;-))

Jerome

Je ne crois pas a la fatalité, mais à la passion qui engendre la bonne volonté.

Une parenthèse sur Qwant ; depuis le passage de l’audit de la DINUM, je ne vois que rarement des mises a jours, au points qu’il me semble voir presque des pages « statiques » sur la courte traine, sensée être l’index propre a Qwant. Certains résultats n’ont pas changé depuis 6 mois… exemple avec la requete « BOURSE ». Les spécialistes peuvent s’amuser a vérifier et a en titer les conclusions qui leur semble évidente, je m’abstient dans ce commentaire… Mais n’en pense pas moins. D’accord avec Olivier sur ce cas … désastreux, destructeur. ET puis, lorsque les comptes de 2018 ne sont toujours pas validés…

—- Un (des) nouveau(x) moteur(s) Français —-

J’invite ceux qui ont des compétences et de l’expérience passée (surtout), à me contacter soit par email (prénom.longo + hotmail.fr) ou via Linkedin pour se rassembler autour d’un consortium sur les projets de moteurs, voire d’un nouveau projet purement FR, vu que le gouv s’entête avec Bing Microsoft.

L’angle pour réussir a rentabiliser un tel outil face a Google est de mon point de vue extremement fin et précis, autant sur la stratégie que de la technique, et il est necessaire d’être le plus économe possible pour durer et affiner cette stratégie. Néanmoins, le jeu en vaut la chandelle, l’IA est assez mature et répandue aujourd’hui pour réussir un outil assez pertinent.

J’interroge chaque année mes étudiants sur leur pratique du web et cette année encore, qwant arrive en bonne position (à peu près 25% des étudiants l’utilisent plus que google).

Juste pour apporter un peu d’eau à notre moulin…

bonjour,

j’utilise pour ma part Qwant depuis au moins deux ans.

Les résultats sont tout à fait valables.

Je sais pourquoi je l’utilise: essayer de me libérer de google. C’est d’ailleurs je crois l’angle mort de votre article, une partie du public craint désormais de laisser toutes ses datas à au grand méchant Google.

C’est tellement vrai que c’est devenu un argument marketing d’Apple.

Et à ce petit jeu, il est bien meilleur que Duckduckgo qui est juste complètement nul en Francais.

Je suis aussi un peu étonné par la haine que Qwant suscite chez une partie des commentateurs francais (Manhack par exemple)… Cela dépasse le cadre de l’analyse technique.

Oui, le sujet avait été abordé dans les articles précédents sur Qwant (voir les liens dans l’article)

La « haine » ?… Vous avez lu mes enquêtes ? Qwant avait fait condamner Marc Longo pour « dénigrement », au motif que « la divulgation d’une information de nature à jeter le discrédit sur un concurrent constitue un dénigrement, peu important qu’elle soit exacte ».

J’ai donc vérifié cette information, et découvert que, depuis plusieurs mois, l’index était toujours bloqué à 2017, et identifié deux autres bugs qui, tous, ont été reconnus (et corrigés) par Qwant.

[Contenu supprimé]

Condamnation rejetée en appel

Meme si j’ai finalement gagné ce procès, il ne s’agit pas de haine, mais de vérité technologique et de constat de résultats, de com qui dépasse de loin la simple « exagération », car celle-ci est surtout destinée a trouver des fonds pour beaucoup, et des fonds publics sur nos impots.

Donc, en la matière, il s’agit d’honnêteté des propos et des déclarations, du respect des conditions générales de l’API Bing, des chiffres etc, car sinon on déborde dans la tromperie. L’un des premier article d’abondance sur le questionnement d’honnêteté : https://www.abondance.com/20130221-12295-qwant-nous-voulons-lier-notre-outil-au-web-3-0.html

Je rappelle que la DINUM n’a pas réussie en Juin 2019 a auditer correctement pour évaluer la part de Bing, que cela n’a pu etre possible que fin Septembre 2019, et que la part de Bing est de presque 70%. Le journaliste (qui a eut l’interdiction de publier le rapport) exprime l’inquiétude de la DINUM et précise que l’audit a été fait dans des conditions d’urgence…https://www.acteurspublics.fr/articles/qwant-la-dependance-a-microsoft-inquiete-la-direction-du-numerique-de-letat

Malgré le départ d’Éric Léandri, la transparence n’est toujours pas au rendez-vous, ni sur la technique et le rapport DINUM, ni sur les comptes (2018). C’est désormais une affaire qui concerne l’État, avec toute la rigueur de nos institutions qui vont avec, je suis étonné de ce dénouement choisi a Bercy dont dépend Cédric O.

Merci pour cet excellent article.

QWANT est l’alternative à essayer lorsqu’on ne veut pas se laisser totalement absorber par Google de crainte de voir ses données récupérées. Et il fait le job…😉 pas si mal que cela.

Un mensonge intégral. Les données ne sont pas protégées : lues par Bing, elles sont également entièrement disponibles pour l’Etat.

Et si on parlait de moteur francophone ? notre langue est très utilisée sur la planète, ses tournures de phrases demandent une façon d’indexer différente de l’anglais… un moteur francophone pourrait en tirer partie, tout en se complétant des résultats de Google ou Bing.

Je suis beaucoup plus mesuré sur LeMoteur… De mémoire, LeMoteur proposait les résultats de Voila, amputés des résultats Vidéo et Images. A l’époque, la seule valeur ajoutée que j’y trouvais était un look sombre avec un fond noir, peut-être moins consommateur en énergie 🙂

Exact, Voilà, Orange et LeMoteur avaient la même origine pour les résultats.

Bonjour,

Bravo pour ce très bel article 😉

Ayant connu le web à ses débuts (1994) ca me fait plaisir de (re)voir les screenshots des pages des moteurs aujourd’hui disparus…

Sans vouloir être présomptueux, de toute façon nous ne sommes qu’une minuscule structure nous avons inventé un moteur d’ouverture. Je tiens à ce mot pour de corréler de la signification du mot moteur de recherche. Je crois comme vous qu’il est illusoire de faire une copie de Google mais qu’il existe des failles dans le concept même de moteur. Quoi que vous en pensiez j’aime les points de vue personnels de cet article. Bien à vous

Je pense que vous, comme beaucoup, notament Dimitri plus haut, mais j’en ai vu aussi sur Webrankinfo, il y a des tentatives pour créer des moteurs de recherche, au début Artisanaux, il ne reste plus qu’a les faires évoluer.Je fais aussi parti de ceux-là.

Les expériences qui débutent pretent souvent a sourire, leurs concepteurs étant souvent dans une bulle stratégique et de positionnement bien a eux. Xaphir était aussi troublant dans son interface que Qwant avec ses colonnes dont le web Bing.

Ce qui compte, c’est le coeur du concept technologique et la pertinence , tout ce qui est autour peut s’améliorer dans le temps et grandir petit a petit.

J’encourage tous les projets, mais Google place la barre si haute, qu’aucun investisseur sensé ne misera sur un projet naissant. Il faut donc penser en même temps a une rentabilité minimum, sinon c’est voué a l’échec. Qui dit rentabilité dit revendre des résultats (B2B) et/ou avoir de la publicité rentable. A moins de pondre un concept techno avec une pertinence et rapidité extraordinaire, il faut en passer par la rentabilité.

Et de ce coté là, les régies ne jouent pas toujours le jeu, il faut peut etre penser a créer la sienne en parralle et ou bien travailler ce point.

Les projets cités par Olivier n’avaient pas vraiment de stratégie commerciale et/ou d’équilibre financier/rentabilité, peut-être est-ce la leçon a tirer?

Heureusement, le gouvernement dépensera autant que possible nos impôts (dont nous détenons le record en valeur dans l’OCDE) pour entretenir cette inutile interface qu’est Qwant, tout en étant très docile face aux demandes de désindexation « pour la désindexation » de celui qui le nourrit. Le communisme à la française, jamais dénoncé par les pseudo-libertaires vrais censeurs type La Quadrature du Net.

Moi j’utilise Qwant, j’en fais la promotion. Globalement des résultats pertinents.

Pourquoi ne pas parler de DuckDuckGo comme alternative à Google bien qu’Américain.

Mais au delà des déboires des technlogies françaises et dans la lignée de imposer ou pas aux fonctionnaires Qwant…

Je suis un peu la campagne électorale. Je suis étonné que des candidats utilisent tous les outils google, gmail ou google drive, comme outils de campagne, alors que toutes ces infos et opinions politiques qui y sont déposées peuvent être identifiées personnellement. Elles seront utilisées par Google à des fin commerciales et peuvent être transmises aux autorités américaines.

D’où ma question (qui dépasse les moteurs de recherches ) n’y a t-il pas aussi une inculture numériques françaises des élus et des universitaires (et des haut fonctionnaires ?)

C’est possible, une inculture dont profitent très grassement les losers de Qwant qui sont maintenant entretenus par l’Etat.

Evidemment que tous les politiciens sérieux doivent utiliser du propriétaire et pas WhatsApp, Gmail etc. Pour autant, cela ne justifie en rien de maintenir en vie des unités inefficaces au détriment d’autres créations d’entreprise, dont nous avons le savoir-faire particulier pour les dégoûter. Ce qui justement les incite à s’installer… aux Etats-Unis ou en Chine.

Heureusement, les penseurs qui nous gouvernent (sans besoin de bulletin de vote) entretiennent grassement Google avec notre impôt (1000 ou 2000 € par bagnole, 1 ou 2 € par paquet de lessive etc…), sans formulaire de déclaration de revenus (Google ne sait pas ce que c’est), sans fraude possible (pas encore trouvé de produit en vente » 150 €, 103 € si vous tenez à vous passer de la pub »)

Alors, « Nos Impôts » et « le Communisme à la française », ça me ferait rigoler si ce n’était pathétique.

Agrémentez d’exemples ? Votre histoire de paquet de lessive n’a aucun sens en l’état