Les 25 ans de Google sont l’occasion de se souvenir des 25 moments les plus marquants pour le moteur de recherche, de la création de Google Images en 2001 à la Search Generative Experience en 2023.

Google Images : 2001

L’idée de créer Google Images a été inspirée par… Jennifer Lopez ! Sa robe Versace, portée lors des Grammy Awards 2000, est rapidement devenue la requête la plus populaire sur Google… mais les internautes ne pouvaient pas trouver aussi facilement de photos de la robe. Google Images a résolu ce problème !

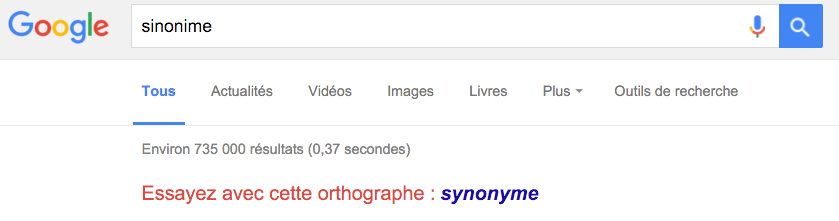

“Essayez avec cette orthographe” : 2001

Les fautes d’orthographe dans les requêtes sont légion. En 2001, Google a lancé “Did you mean ?”, en français “Essayez avec cette orthographe” et la correction orthographique suggérée. Il s’agissait de la première application d’apprentissage automatique !

Il y a quelques années, le moteur de recherche fournissait des pages contenant la même faute d’orthographe. Aujourd’hui, grâce à l’IA, vous obtenez les bonnes pages même si vous faites une erreur, car Google vous corrige automatiquement. Il propose néanmoins “Essayez avec l’orthographe” avec la faute commise, au cas où !

Google News : 2002

Lors des attentats du 11 septembre 2001, les internautes ont cherché des informations sur Google mais sans trouver les réponses désirées. Google a ainsi décidé de répondre au besoin d’informations en temps réel en lançant Google News, ou Google Actualités, dès 2002.

A noter : très rapidement après les attentats, Google proposait déjà une sorte de Google News, via une liste de liens utiles sélectionnés par le moteur.

Easter Eggs : 2003

Depuis 20 ans, Google distille des Easter Eggs, cachés dans le moteur de recherche. De nombreux articles à ce sujet ont été rédigés sur Abondance. Olivier Andrieu a partagé, en 2020, ses 30 Easter Eggs favoris !

Saisie semi-automatique : 2004

D’abord lancée en tant que “Google Suggest”, l’autocomplétion est toujours disponible sur le moteur de recherche. Une belle fonctionnalité en 2004, qui a permis de rendre la recherche beaucoup plus rapide grâce à la prédiction automatique des requêtes.

D’après Google, aujourd’hui la saisie semi-automatique réduit la saisie de 25% et permet d’économiser 200 ans de temps de saisie par jour, en moyenne.

Informations locales : 2004

Dès 2004, il était possible de trouver la pizzeria la plus proche de chez vous ou le meilleur coiffeur de la ville. Les annuaires téléphoniques ont peu à peu laissé leur place à Google ! Des plans, des itinéraires et des avis ont été ajoutés aux fiches d’entreprises.

En 2011, la fonctionnalité d’appel a été ajoutée sur mobile pour appeler facilement les entreprises. Les résultats locaux génèrent chaque mois plus de 6,5 milliards de connexions pour les entreprises (appels, itinéraires, commandes et réservations).

Google Traduction : 2006

En 2002, l’équipe Google a commencé à travailler sur une technologie de traduction automatique, dans le but de lutter contre les barrières linguistiques en ligne. 4 ans après, Google Traduction était lancé avec des traductions entre l’arabe et l’anglais.

Aujourd’hui, l’outil prend en charge plus de 100 langues, avec 24 langues de plus en 2022.

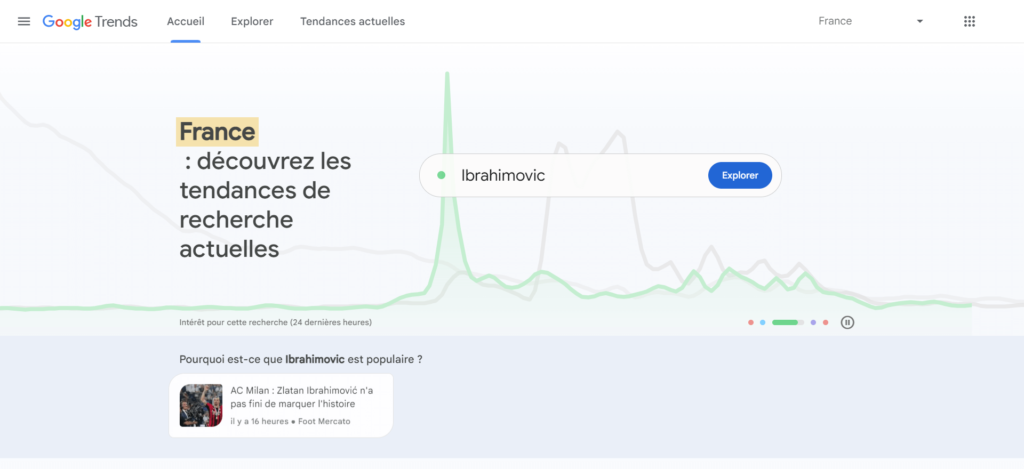

Google Trends : 2006

Lorsque Google Trends a été créé, c’était pour comprendre les tendances sur le moteur de recherche avec des données agrégées.

A présent, il s’agit de la plus grosse base de données gratuite au monde autour des tendances de recherche et leur évolution.

En 2023, le design de Google Trends a changé pour devenir plus moderne et ergonomique.

Recherche universelle : 2007

En 2007, Google a décidé que son moteur de recherche ne devait pas se limiter aux liens textuels, mais aussi fournir des informations pertinentes dans tous les formats : images, vidéos, résultats locaux.

Les systèmes ont donc été repensés pour intégrer tous ces contenus en même temps et décider où et quand les résultats devaient s’intégrer. La recherche universelle a été, selon Google, leur plus gros changement en matière de recherche à l’époque.

Application mobile Google : 2008

Le lancement de l’App Store d’Apple a permis de lancer la première application mobile Google sur iPhone. Les fonctionnalités Position et la saisie semi-automatique ont été particulièrement utiles sur un petit écran.

Aujourd’hui, l’application Google est disponible sur iOS et Android et permet de faire bien plus de choses, avec Google Lens ou l’outil de traduction visuelle.

Recherche vocale : 2008

Via l’application mobile Google, la firme a introduit la recherche vocale, avant de l’étendre aux ordinateurs en 2011. Le pays où elle est la plus utilisée aujourd’hui : l’Inde ! Le pourcentage d’Indiens effectuant des recherches vocales quotidiennes est quasiment 2 fois supérieur à la moyenne mondiale.

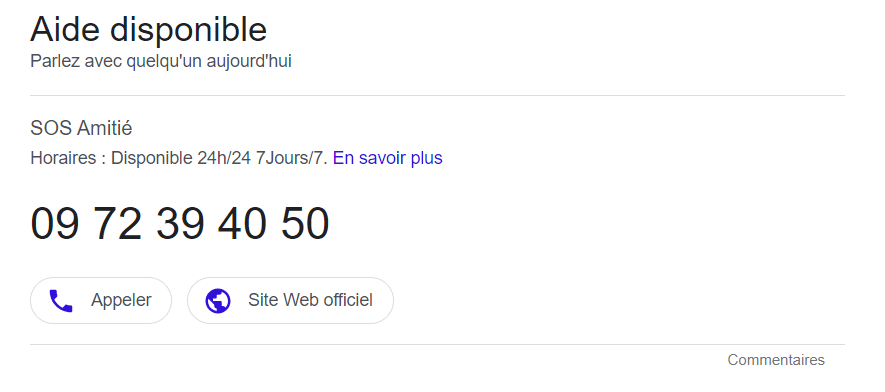

Assistance d’urgence : 2009

Après avoir reçu le retour d’une mère ayant eu du mal à trouver des informations anti-poison alors que sa fille avait avalé quelque chose de potentiellement dangereux, Google a décidé de créer un encart pour la ligne téléphonique d’assistance anti-poison, tout en haut des résultats de recherche.

Depuis, Google a ajouté d’autres encarts avec plusieurs lignes d’assistance téléphonique d’urgence, comme la prévention du suicide.

Recherche visuelle : 2011

Pour aider les internautes ayant des difficultés à décrire avec des mots ce qu’ils recherchaient, Google a lancé la recherche visuelle en 2011, pour télécharger n’importe quelle image ou URL d’image, découvrir ce dont il s’agit et où se trouve cette image sur le web. Les prémices de Google Lens !

Knowledge Graph : 2012

Le Knowledge Graph, cet encadré offrant des informations sur des personnes, des lieux ou des objets directement dans les SERP, a été lancé en 2012. Un aperçu rapide très utile pour les internautes, qui a néanmoins fait baisser le trafic sur les sites…

Le Knowledge Graph a été lancé en France 8 mois après sa sortie aux Etats-Unis.

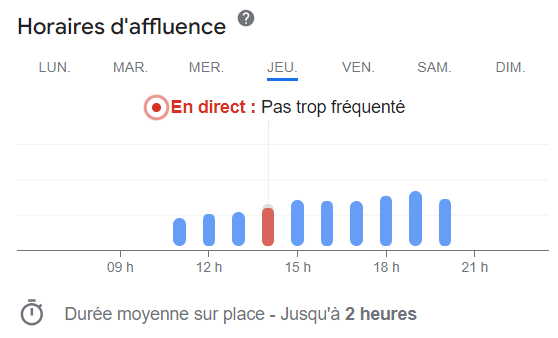

Horaires d’affluence : 2015

Pour connaître les meilleurs moments pour aller dans un restaurant, un magasin ou un musée, Google a lancé la fonctionnalité “Popular Times” pour que les utilisateurs sachent à quels horaires le lieu qu’ils recherchent est le plus fréquenté - et adapter leur venue.

Google Discover : 2016

Dans la même lignée que Google News, la firme a lancé Discover en 2016 pour offrir un flux personnalisé aux utilisateurs, avec du contenu adapté à leurs centres d’intérêt sans avoir besoin de faire de recherches. Une nouvelle façon de s’informer !

Google Lens : 2017

Après la recherche visuelle, Google a lancé Lens, qui transforme votre objectif de téléphone en requête de recherche. Le but : rechercher ce que vous voyez, avec de nombreuses fonctionnalités. Lens enregistre plus de 12 milliards de recherches mensuelles !

Prévision des inondations : 2018

Malheureusement, les inondations sont devenues monnaie courante dans certaines régions du globe. Google a ainsi créé des modèles de prévision, pour prédire où et quand des inondations se produiront, tout ça grâce à l’intelligence artificielle. D’abord déployée en Inde, cette fonctionnalité d'alerte inondation a été étendue à 80 pays.

BERT : 2019

Google a introduit l’algorithme de machine learning BERT (Bidirectional Encoder Representations from Transformers), dont l’objectif est de rendre la recherche plus utile et efficace en comprenant mieux le langage, en prenant en compte le contexte d’un mot. BERT est appliqué à plus de 70 langues désormais.

Shopping Graph : 2020

L’expérience d’achat s’est considérablement améliorée avec l’arrivée du Shopping Graph, qui a permis à n’importe quel commerçant de présenter ses produits gratuitement sur Google. Les données Shopping Graph sont alimentées par l’IA et regroupent les produits, les vendeurs, les marques, les avis et un inventaire local mis à jour en temps réel. Il comprend aujourd’hui 35 milliards de produits.

Hum to Search : 2020

La fonctionnalité Hum to Search est utile aux mélomanes : depuis 2020, les internautes qui ont une mélodie dans la tête, sans se souvenir du titre de la chanson, peuvent fredonner la musique pendant 10 à 15 secondes et Google leur permet de retrouver la bonne chanson ! Merci l’apprentissage automatique qui identifie les correspondances potentielles.

About this result : 2021

About this result, “A propos de ce résultat” en français, sert à offrir du contexte autour du contenu proposé et sa source. Il est déployé sur quasiment chaque résultat de recherche, et désormais dans toutes les langues. A propos de ce résultat est arrivé tardivement en France, en 2022.

Recherche multiple : 2022

La recherche multiple, mêlant texte et image, est disponible sur Google depuis l’an dernier. Il est possible de prendre une photo et de renseigner une requête en même temps. Multisearch est disponible dans le monde entier sur mobile, via Google Lens.

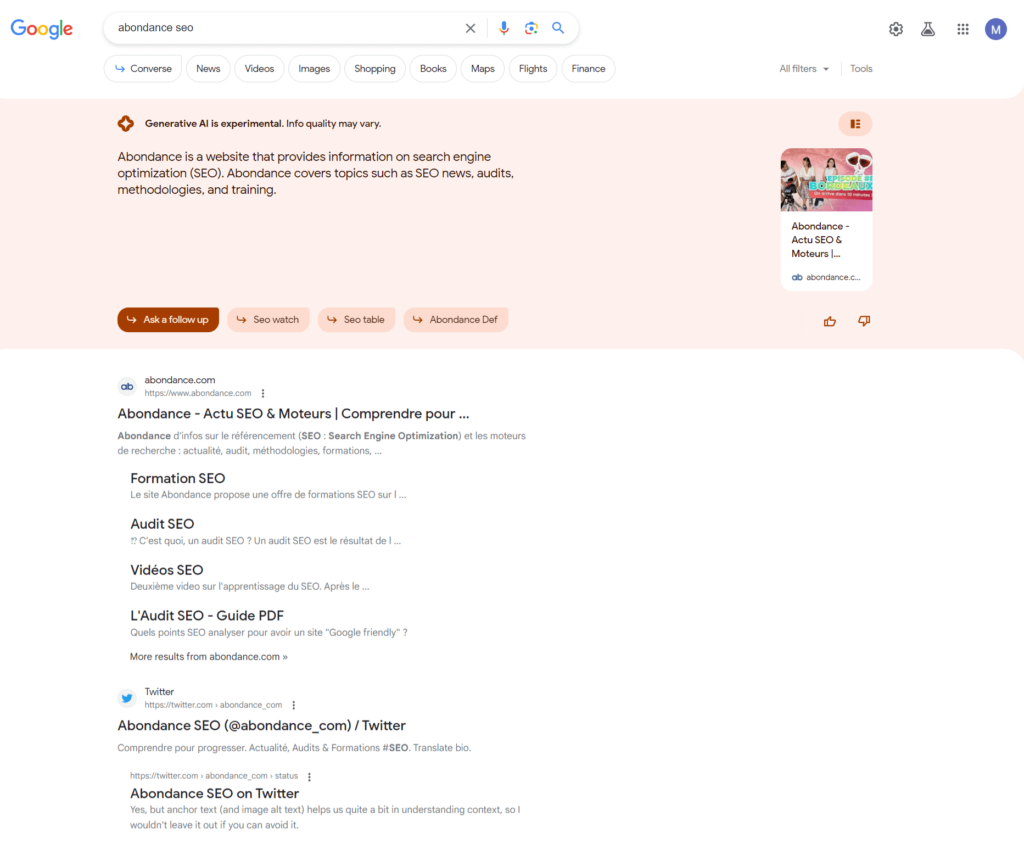

Search Labs et SGE : 2023

Dernier événement en date, la Search Generative Experience ! La première expérience de Search Labs apporte de l’IA générative directement dans le moteur de recherche, avec des réponses instantanées.

Quels sont les événements autour de Google qui vous ont le plus marqué ?